随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLM)正逐渐渗透到人们日常生活和工作中。从ChatGPT到各种定制化的智能助手,LLM正凭借其强大的语言理解和生成能力,成为信息检索、内容创作、甚至编程辅助等多个领域的得力帮手。然而,在这种强大工具背后,隐藏着一种鲜为人知但又极为重要的认知现象,即盖尔曼失忆效应(Gell-Mann Amnesia Effect)。这一效应最初由著名作家迈克尔·克莱顿提出,形容人们在面对自己熟悉领域的错误报道时,会意识到信息的不准确,但随后却又回归到对不熟悉领域报道的盲目信任。将这一现象应用到大型语言模型,揭示了用户在面对LLM输出时的复杂心理和认知误区。 人们使用LLM时,往往会被它们快速且表面上看似准确的回答所折服。

对于一些陌生领域的问题,LLM凭借庞大的训练数据和复杂的模型结构,能够迅速提供相关信息甚至详尽解答,使用户感受到“魔法”般的体验。然而,当用户对某个领域具备一定专业知识时,往往能够敏锐地发现LLM输出中潜藏的错误或不合理之处。这种对自身专业知识的凭依,使得用户在熟悉领域对结果产生怀疑,但对不熟悉领域的答案却轻易接受,由此产生了如盖尔曼失忆效应般的认知波动。 盖尔曼失忆效应告诉我们,专业知识的缺失导致用户对信息的批判性思维下降,容易陷入对LLM生成内容的盲目信赖。这种现象在AI驱动的内容创作、自动决策辅助等场景中尤为突出。LLM的回答速度惊人且形式优雅,很难通过表面来判断其准确性,尤其当它能用流畅的语言隐藏事实错误甚至逻辑漏洞时。

在没有足够领域知识的情况下,用户可能难以辨别真假,进而将错误信息当作“唯一真理”。 另一方面,专业领域的实践者在使用LLM协助完成任务时,也会经历一种“拉锯战”。他们可能利用自己的经验去校对和修正模型的输出,同时也会不断学习如何更有效地向模型发问以获得理想的答案。这种过程既体现了对LLM能力的信任,也反映了对其不足的警觉。由此,LLM成为了促进人类思考而非替代的工具,其背后隐藏的盖尔曼失忆效应也提醒我们要保持批判性智慧。 大型语言模型的训练往往基于海量多源数据,这其中既包含大量权威信息,也混杂着难以甄别的错误内容。

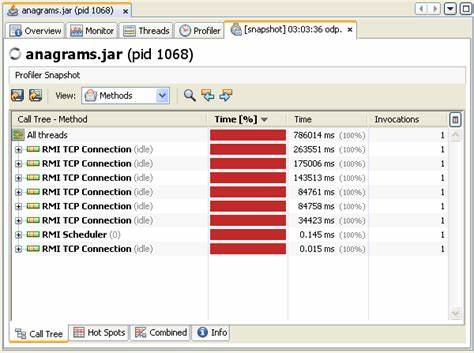

模型通过模式匹配和统计学习产生回答,却无真正的理解和判断机制。因此它在某些领域的表现非常出色,提供条理清晰且逻辑通顺的答案,但在细节精准度和复杂推理问题上仍存在不足。这种能力的强弱不均也导致用户在不同话题上的信任度波动,进一步强化了盖尔曼失忆效应的表现。 除了用户认知陷阱,LLM在实际开发和应用中也面临一些挑战。例如,在“vibe coding”(依赖LLM自动生成或辅助编写代码)的实践中,具备一定编程经验的用户能够识别模型生成代码中的错误和逻辑缺陷,并做相应调整;但是缺乏经验的人则可能无法察觉潜在问题,从而导致产品质量下降或严重bug。这体现了模型并非万能,最终落脚点仍是人类的审查和主导。

盖尔曼失忆效应也提示教育领域需要加强用户的信息素养培养。面对日益普及的AI工具,培养用户的批判思维和跨学科知识储备显得尤为重要。只有具备一定的领域认知,才能在使用LLM时既发挥其高效优势,又避免盲目依赖,减少错误传播和信息误导。未来,结合人机协作的最佳实践,完善模型解释能力和透明度,将有助于缓解这一效应带来的负面影响。 此外,从社会层面看,公众对大型语言模型及其输出的理解也影响着信息传播生态。对LLM生成内容产生的盲目信任,可能加剧谣言扩散及错误观念的形成,需要媒体、教育者和技术开发者通力合作,引导正确使用AI。

及时揭露和纠正错误,用科学态度对待智能生成内容,才能确保公共信息环境的健康发展。 总体而言,大型语言模型作为终极的盖尔曼失忆效应机器,折射出人类认知的复杂性和技术发展的双刃剑特性。它们确实极大提升了我们的信息获取和处理效率,但也带来了认知盲点和误判风险。为此,用户、开发者及社会各界应共同努力,既善用LLM的力量,也保持清醒和批判,打造更智能、更可信的未来信息世界。