在大数据时代,数据流的处理和分析成为各行各业的重要需求。随着海量数据的不断涌入,如何从中高效且公平地抽取样本,成为计量分析和算法设计中的关键问题。Reservoir Sampling算法作为处理动态数据流的经典方法,尤其是其中著名的算法R,在随机抽样领域中占据着不可替代的地位。今天,我们将围绕算法R的起源与发现者展开深入探讨,揭示其背后鲜为人知的历史与发展轨迹。Reservoir Sampling是一类用于从未知长度或动态增长的数据流中进行均匀随机抽样的算法。这类算法允许我们在只扫描一次数据的情况下,从流中抽出指定数量的样本,使得每个样本被选中的概率相等。

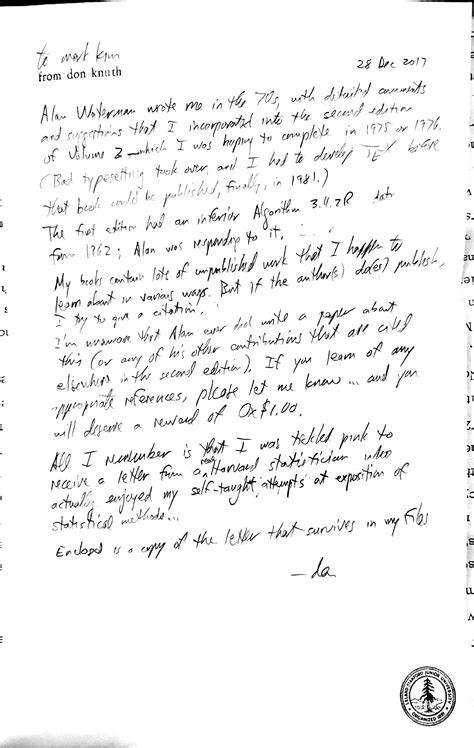

算法R是该领域首个被广泛知晓且实用的方案,其核心思想在于维护一个称为“水塘”或“储备池”(reservoir)的固定大小的样本集合,最初将前m个元素直接装入水塘,然后对于之后每个新元素,通过一定的随机机制决定是否取代已存储的样本。这种动态替换保证了最终输出的样本具有真正的随机性和均匀性。关于算法R的发现者,业界和学术界存在一定程度的争议和探讨。根据权威资料显示,算法R最早被提及并推广者为艾伦·G·沃特曼(Alan G. Waterman)。在著名计算机科学家唐纳德·克努特(Donald Knuth)撰写的《计算机程序设计艺术》(The Art of Computer Programming)第二版中,他将算法R归功于沃特曼。克努特曾在70年代收到沃特曼的来信,讨论改进之前版本中较为笨拙的随机抽样算法,并采纳了沃特曼提出的更高效方案,使之成为算法R的原型。

然而,值得注意的是,沃特曼本人似乎未正式发表相关学术论文,这使得算法R的早期来源较难考证。克努特在后续回复信中坦言,对沃特曼发现的高明算法深感佩服,并将其作为自己著作中的重要内容进行呈现。除了沃特曼之外,A.I. McLeod和D.R. Bellhouse在1983年也独立提出了类似的随机抽样方法,虽未引用沃特曼或克努特的工作,但他们的研究进一步丰富和验证了算法R的有效性。历史追溯中,又发现1962年Fan、Muller和Rezucha曾提出一种与Reservoir Sampling思想类似的算法,尽管在实现细节和步骤上有所不同。他们的方法涉及到为每个元素生成随机值,将元素及其标签保存至储备池,并通过分阶段的比较和选择实现样本的随机性。虽然这种方法在概念上与后来的算法存在联系,但是否直接影响了算法R的发展尚无定论。

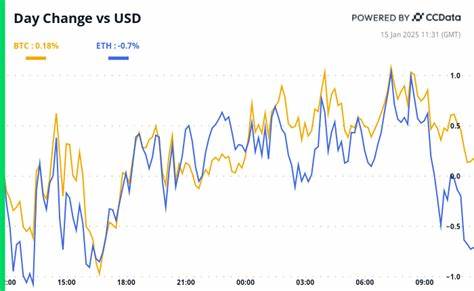

围绕算法R的一大趣事是,维特(Vitter)在1985年发表论文中推广了高效的Reservoir Sampling版本,即算法Z,但在其介绍中明确承认算法R是由于沃特曼提出,这在一定程度上揭示了算法R的原创归属。令人意外的是,尽管沃特曼对算法R的贡献被多位权威人士认可,知名的中文和英文维基百科页面却多次忽略了这一点,而是将算法R的发现归功于J.S.维特。这种信息上的错漏反映了学术传播过程中信息传递的复杂性,也提醒我们在查证历史贡献时需谨慎对待各种证据和文献。算法R的实际意义不仅体现在理论创新上,更深刻体现在其广泛应用中。随着流式数据在金融交易监测、网络流量分析、实时推荐系统等领域的重要性日益凸显,如何实时且公平地抽取代表样本成为必备技术。算法R简单高效,且能够在空间受限、数据量巨大的条件下,保证每个数据点被选择的概率相等,这使其在大规模数据处理场景中极受欢迎。

此外,算法R 的思想也启发了后续大量的改进算法和变体,从提高速度、减少随机数使用,到适用于分布式环境,成为数据科学家和工程师工具箱中的常用利器。回顾算法R的发现历史,我们可以看到原创贡献往往并非单一的发明者可以完全包揽,而是多位研究者在不同时期、不同环境中提出、改进和传播的结果。沃特曼作为算法R最早的提出者,其与克努特的通信和互动帮助这一算法得以完美呈现和推广,而McLeod和Bellhouse的独立发现也佐证了其思想的正确性和普遍适用性。算法R的历史教会我们,科学研究是一个积累和传承的过程,需要尊重和致谢每一位贡献者,同时重视严谨的文献索引和传播方式。对于未来研究而言,Reservoir Sampling依旧是一个活跃的研究领域,新的模型和需求不断涌现,比如面对非均匀概率需求、数据缺失、隐私保护等问题,新的算法设计挑战在等待解决。总而言之,算法R作为Reservoir Sampling的基石,其发现和流传不仅丰富了计算机科学和统计学的理论体系,也为现实世界中处理大规模流数据提供了强有力的技术支持。

认识其背后的历史渊源和贡献者,有助于我们更好地理解算法本质,推动技术进步和创新。未来,随着数据规模和复杂性的不断提升,对于高效、公平以及可扩展样本抽取算法的需求将更加迫切,而算法R及其衍生版本无疑将在这条道路上继续发挥重要作用。