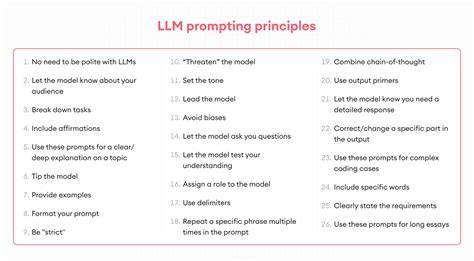

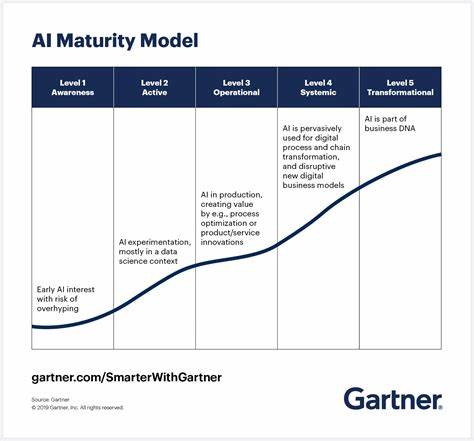

近年来,随着人工智能技术的飞速发展,基于大型语言模型(LLM)的应用愈发普及,从智能客服、内容生成到企业自动化,LLM无处不在。然而,LLM的核心之一是提示(Prompt),其设计与管理的高效性直接影响模型的输出质量。因此,如何系统化、规范化地管理提示成为业界亟需解决的问题。PromptOps应运而生,作为一款Git原生的提示管理和测试框架,旨在为开发团队提供一套完善的提示版本管理、变更追踪和自动化测试机制,为LLM提示开发插上高效的翅膀。PromptOps的设计理念深度融合了软件工程中版本控制的最佳实践,结合Git的强大功能,实现了提示的零手动版本管理。团队成员在本地编辑提示模板时,PromptOps能够自动检测更改并依据语义版本控制规则自动更新版本号,无需人工干预,大大降低了管理复杂度。

这种自动化的语义版本策略包括三种类型:补丁版本对应模板内容的微小调整,次版本代表兼容性新增变量,主版本则用于删除必需变量导致的不兼容变更。这样的细化版本控制使团队能够明确判断每次修改的影响范围,有助于风险评估和回滚操作。同时,PromptOps提供了丰富的测试能力。无论是针对未提交的修改进行即时测试,还是对历史版本进行回归验证,都能够轻松实现。测试结果自动以Markdown报告形式生成,方便团队分享和审阅。此外,PromptOps通过Git钩子无缝嵌入开发流程,在代码提交前后自动触发版本更新、标签创建及测试,确保每次提交的提示都得到规范和验证,极大地提升了提示开发的可靠性。

PromptOps拥有完善的CLI工具和Python SDK,兼顾命令行用户和开发者需求。安装简便,仅需pip一键安装,初始化项目时自动配置Git钩子和项目结构,引导用户快速上手。此外,Python SDK支持从应用程序内部动态获取指定版本的提示文本,甚至可基于变量渲染模板,支持多种主流LLM框架如OpenAI和Anthropic,方便将提示管理集成到生产环境中。项目结构设计合理,模板存放于YAML文件,结合Jinja2实现灵活的模板渲染,变量定义、测试数据、结果报告、日志分析等模块也被完整纳入,形成闭环管理体系,满足不同项目和团队规模的需求。PromptOps的社区虽处于起步阶段,但已展现出强劲的生命力和发展潜力。MIT开源许可鼓励更多开发者参与贡献,结合丰富的文档和示例,推动了PromptOps不断完善和功能扩展。

依托于现代DevOps理念,PromptOps将Prompt管理视为代码管理的自然延伸,借助Git化管理将提示的开发、测试、发布无缝结合,使提示管理步入规范化、自动化的新时代。对大型企业和多团队协作尤其适用,可保证提示版本的可追踪性和一致性,避免由于提示不统一带来的质量波动。此外,PromptOps适合作为学习和研究工具,帮助开发者系统理解提示版本控制及设计原则。面对不断更新的语言模型和复杂多变的业务需求,PromptOps的版本感知测试功能令人耳目一新:用户可轻松调用任意版本的提示进行对比,分析变量变更对模型响应的影响,从而优化Prompt设计策略。Git钩子自动化也保障了流程的规范执行,无需担心版本号遗漏或测试遗漏。开箱即用的CLI命令覆盖了从初始化、钩子管理、版本测试到差异对比和报告生成的完整流程,极大减少了运维负担。

Python SDK的设计简洁且兼容性强,支持根据不同版本号或工作区状态动态拉取模板文本,满足复杂应用场景。随着LLM技术逐渐渗透各类业务,提示的版本管理成为必不可少的基础设施。PromptOps正通过创新的Git原生设计、智能自动化和强大的测试能力,助力开发团队节省大量人工版本维护时间,提高提示质量和一致性。选择PromptOps,无疑是通往高效Prompt开发的理想之选。未来,随着模型复杂度和应用场景的增加,PromptOps有望持续演进,增强语义版本分析算法、支持更多模板语言及集成多源配置管理,推动Prompt管理迈向更智能、更自动化的阶段。对于关注LLM产业链的软件研发者、AI产品经理和研究人员来说,深入掌握PromptOps的原理和使用,有助于理解工业级Prompt工程的最佳实践,提升人工智能解决方案的商业价值和用户体验。

总之,PromptOps作为一款聚焦于生产级提示管理的开源工具,通过Git原生版本控制与自动化测试的有机结合,提供了构建稳健、灵活且高效提示管理流程的强大支持。无论是初创团队还是大型企业项目,都能从中受益,推动LLM技术应用迈上新的台阶。