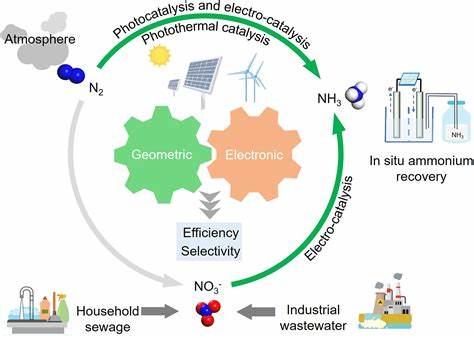

在现代生物医学领域,影像数据和图示成为不可或缺的工具。无论是手术示意图、解剖结构展示,还是疾病诊断图像,‘眼见为实’的理念深深植根于专业人员和大众心中。然而,伴随着人工智能技术的快速发展,尤其是生成式AI(Generative AI)在图像创作中的应用越来越普遍,生物医学视觉表达质量和准确性面临前所未有的挑战。众所周知,医学图像的准确性不仅关乎科学研究的严谨,更直接影响临床决策和公众健康信息的传播。一旦AI生成的生物医学图像中出现错误,可能造成误导,甚至带来危害。基于此背景,来自挪威卑尔根大学、多伦多大学及哈佛大学的科研团队展开了一项专题研究,呼吁制定生成式AI在生物医学可视化领域的规范与指南,以确保医学影像的真实性和科学性。

这篇名为《“看起来吸引,但却错误”——生成式AI在生物医学可视化中的创造力与准确性冲突》的论文,将于2025年11月在IEEE Vis大会上正式发表。研究中,作者们比对了由OpenAI最新模型GPT-4o和DALL·E 3生成的医学图像与传统生物医学可视化专家制作的版本,揭示了AI生成图像存在的视觉迷惑性与科学不准之处。一些错误或失真是细微的解剖结构误差,其他则明显超出现实范畴,如曾引发广泛质疑的“超常发育大鼠”图像便成为讽刺的典型对象。问题的严重性在于,即便这些AI图像因其打磨精致、专业感强而让人难辨真伪,所传递的不准确信息却可能误导普通患者和经验丰富的临床医生,甚至影响生命攸关的医疗决策。 调查显示,虽然目前尚无确凿证据证明AI生成的医学图像直接导致健康损害,但它们的错误使用已在医学与科研出版物中逐渐浮现,这种流传存在潜在危害。研究者们还揭示了错误图像如何破坏科学界的公信力,降低公众对科研成果的信任度。

在疫情期间,类似的信任危机便显露无遗,这加剧了疫苗推广和公共卫生宣传的难度。与此同时,恶意利用这些误导性图像的情况也成为隐忧,给错误信息的快速扩散提供便利。 专家对于生成式AI的态度呈现多元化。部分医学视觉设计师认可AI独特的抽象美学,认为它在促进客户沟通方面有所助益;而另一部分则批评其“千篇一律”的风格缺乏生动细节,甚至会引发滑稽的“外星蛋”式解剖图。例如,一位名为“阿图尔”的受访者直言,AI尚无法精确区分人体神经等复杂结构,只是随机拼接的“线条”,而“乌苏拉”则戏称AI展示的胰腺像外星谜团。这些观点反映了AI技术现阶段准确性不足、虚构与错乱内容频现的问题。

在技术应用方面,AI已被用来协助处理重复性编码任务、数据清理等,但在对医学图像的深度理解和精准呈现上,仍存在巨大差距。另外,生成式AI的黑箱特性和算法偏见也引发了担忧,尤其在责任归属和结果解释方面充满不确定。专家认为,在医疗与科学的关键信息输出中,信任必须建立在透明和专业能力基础上,而AI目前无法满足这一点。 面向未来,产业界与学术界需共同努力,构建严谨的技术审查流程和使用规范,加强人机合作而非盲目信赖AI输出。在推广AI辅助工具时,强调专业人员的判断力与责任感尤为重要。同时,也应推动公众教育,提升大众对生成式AI图像辨识能力,防止错误信息带来的负面影响。

生成式AI的创新潜力毋庸置疑,但若不能妥善处理其产生的误差和伦理风险,其副作用同样不可小觑。 总体而言,生物医学图像作为科学传播和临床实践的桥梁,“看见即相信”的传统观念依然核心。然而,随着AI技术深度介入,这一原则可能被挑战甚至破坏。如何在欣赏生成式AI带来的视觉冲击力和创意同时,强化科学严谨与真实性的监督,是当前及未来社会必须面对的课题。开放对话、严格监督和批判反思,将有助于这个充满潜力却又复杂的工具在生物医学领域发挥最大价值,推动人类健康事业稳健发展。