随着人工智能技术的迅猛发展,音乐创作领域迎来了前所未有的变革。Magenta RealTime(简称Magenta RT)作为一款拥有开放权重的实时音乐生成模型,凭借其先进的算法设计和出众的实时性能,正在引领音乐制作方式的革新。该模型不仅允许用户在生成音乐的同时进行互动控制,还支持多风格、多乐器的混合与变换,极大拓展了音乐表达的可能性,深受创作者和研究者关注。 Magenta RT是Google Magenta项目中的最新里程碑,其源自于深受赞誉的Lyria RealTime模型。Lyria RealTime曾为Google AI Studio的实时音乐API和Music FX DJ应用提供了强大支持,促进了音乐与人工智能的融合。不同于传统黑箱模型,Magenta RT以开放权重的形式发布,意味着开发者和音乐爱好者可以在本地机器甚至更低成本的平台上运行和定制该模型,提升了普及性和创新空间。

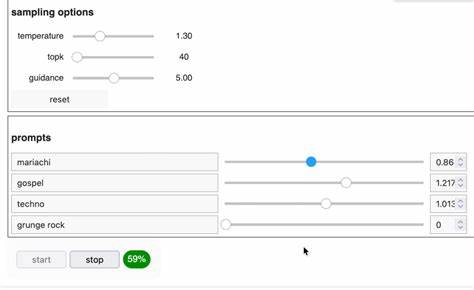

该模型基于拥有约8亿参数的自回归变换器架构,训练数据覆盖约19万小时的多源库存音乐,侧重于西方器乐作品。训练过程中,模型利用了最新的SpectroStream音频表示技术,支持高达48kHz立体声的输出质量,效果细腻且富有表现力。借助Magenta自行研发的MusicCoCa联合音乐与文本的嵌入模型,Magenta RT能够将文本描述和音频样本融合为统一的风格基向量,实现创作风格的灵活调整和实时混合。 实时生成音乐的难点在于必须满足低延迟和因果流式生成的双重需求。Magenta RT通过采用块自回归的方法,实现了将音乐分割为连续音频片段的模式,每个片段约为两秒,结合之前十秒的上下文音频信息以及风格嵌入,生成下一段细致音轨。这种设计不仅保证了音乐流的连贯性与风格一致性,也让用户可以通过实时调整风格权重,瞬间听到音乐的变化,满足现场互动表演的需求。

现阶段Magenta RT在Google Colab的免费TPU资源上测试表现优异,生成两秒钟音频仅需约1.25秒,实时因子达到1.6,远超实时播放速率。未来目标是支持本地设备运行,鼓励普通创作者在无云端依赖的情况下感受AI辅助音乐的魅力。此外,模型计划进一步缩减延迟,扩展风格覆盖范围,提升对人声和复杂结构的生成能力,朝着更高质量和更具交互性的智能音乐工具迈进。 Magenta RT不仅是一套音乐生成引擎,更是一个开放的创作平台。它继承了Magenta项目在音乐潜空间探索方面的丰富经验,允许用户穿梭于跨风格、多乐器的音频空间,创造前所未闻的融合文本与声音的实验之作。通过实时交互调整输入提示,艺术家们可实现DJ混音式的即兴创作,也可为艺术装置、虚拟现实场景和游戏环境注入独特的交互式音效和背景音乐,拓展音乐表达的边界。

Magenta RT的设计理念体现了AI技术与人类创造力的协同增效。它不是要取代音乐家,而是致力于消弭技术门槛,启发灵感,提供高带宽的情感和控制反馈通道。用户在操作模型的过程中建立起持续的感知-动作循环,激发“心流”体验,让创作过程本身成为享受与探索的旅程。相比于大量被动消费AI生成内容,实时模型保证了音乐的独特性和即时互动性,创造出属于当下的独一无二时刻。 尽管Magenta RT取得了诸多突破,但它仍存在若干局限。训练数据偏重西方器乐,导致其对多元文化音乐传统和人声表现的支持尚不完善。

模型最多只能参考最近10秒的音频上下文,难以自发构建长篇乐曲的复杂结构,同时由于两秒块的生成设计,用户对风格调整的响应存在延迟。为解决这些问题,团队推荐有更广泛需求的用户使用与之配套的Lyria RealTime API,且正积极推动模型迭代。 展望未来,Magenta RT将在降低延迟、提升声音质量和提升交互深度等方面实现显著改进。团队致力于开发新一代实时音乐模型,打造真正可演奏的数字乐器及现场伴奏工具,赋予音乐家更多创造力和表现力。随着开源社区和创意开发者的参与,Magenta RT很可能成为未来智能音乐生态的核心驱动力。 总的来说,Magenta RealTime是一项兼具前沿科技与文化意义的创新突破。

它代表了人工智能与艺术结合的美好图景,开启了实时、可控、高质量音乐创造的新时代。无论是专业音乐人还是爱好者,Magenta RT都为大家提供了一条通往无限可能的音乐创作之路。未来,随着技术优化与应用扩展,Magenta RT必将继续激发全球音乐的想象力与创作潜能,助力更多人实现属于自己的音乐梦想。