语音合成技术已经逐渐成为智能设备和人机交互的重要组成部分。随着人工智能的发展,传统的文字转语音(TTS)技术正迈向更真实、自然的声音合成。不少开发者和爱好者希望拥有专属的个性化语音,然而传统的语音训练通常依赖大量的语料和复杂的硬件环境,令许多人望而却步。近日,一种创新的方法引起了广泛关注——利用仅一条语音样本,结合先进的AI模型,实现Piper TTS的新声训练。该技术不仅大幅降低了数据需求,也让个性化语音定制成为可能。本文将深入探讨如何从零开始,使用最少的语音数据训练Piper TTS模型,分享具体步骤、硬件选择、软件配置,以及克服训练过程中的难点和优化方案。

Piper TTS作为开源领域内极具代表性的AI语音合成引擎,其独特优势在于高效快速,适合中低配硬件运行,同时音质表现远超传统TTS技术。传统训练方法一般需要数千甚至上万条语料,配合高性能GPU长时间深度训练,这对多数开发者来说负担较大。相比之下,通过借助具有“零样本”克隆能力的Chatterbox TTS引擎,将一个完整的短句进行多次生成和筛选,可构建起一个用于微调Piper模型的训练集,从而用极少数据实现新的声音风格训练。 硬件配置方面,理想情况下应当配备支持CUDA的GPU进行训练加速。虽然最新高端GPU能够显著缩短训练周期,但经过实验验证,略陈旧的卡如Nvidia Tesla P4凭借8GB显存也能完成任务,只是训练时间较长。训练过程所需的CPU和RAM资源相对较低,关键在于合理利用GPU计算能力。

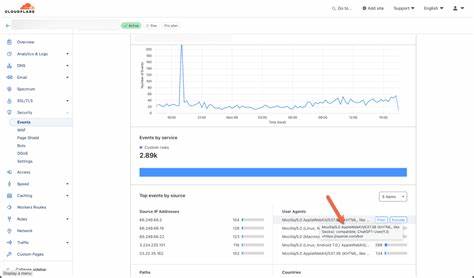

许多用户根据自身设备情况,采用了裸机或者无机箱的组合,以保证散热和性能的稳定。此外,最佳实践建议定期观察GPU负载和温度,避免因过热导致训练中断。 软件环境搭建方面,基于Docker的容器化部署提供了极大便利。预制的Docker镜像包含了包括Piper训练脚本、Chatterbox TTS引擎以及Whisper转录工具等必要依赖,免去了环境配置中的诸多兼容性问题。更进一步,自定义脚本处理音频生成和验证流程,为整个训练管道带来了自动化和稳定性。利用Whisper转录引擎反复检验合成语音的准确性,有效剔除生成错误,确保训练数据质量。

训练时遵循Piper官方的指导原则,设置合理的批次大小和学习率等超参数,以适配不同的硬件条件和数据集规模。 在文本数据的准备环节,尽管只需单句语音,但为了细化和丰富训练效果,扩展文本库仍然是必要步骤。整合公共开源数据集如LJSpeech语料库、项目固件文案、以及个人收集的短句,可以构建涵盖多音素覆盖率的文本集。随后,结合Chatterbox逐句生成对应音频文件,利用自动化筛选工具剔除不合格样本,获得训练效果最佳的子集。数据采样率统一为22050Hz单声道,符合Piper训练标准,从而保证模型输入输出的兼容性。 训练过程使用基于PyTorch Lightning框架的Piper官方训练脚本,采用高精度单精度浮点数格式以保证模型稳定性。

通过微调预训练的高质量LJSpeech检查点,缩短了训练时间并减少所需的数据量。训练时观察损失函数曲线是否稳步下降,预示模型效果逐步提升。虽然训练时间可能长达数天,但中途可通过断点续训避免前期计算浪费,保证整体流程顺畅。最终导出模型包括ONNX格式权重和配置元数据,为后续部署提供兼容性支持。 训练成果反馈显示,最终模型生成的语音自然且接近Chatterbox风格,成功实现从商用TTS示例单句生成个性化声音。虽然对比完全克隆存在细微差距,但输出效果足以满足大多定制化场景如智能助手、公共广播等应用需求。

整个项目中遇到的挑战主要体现在生成数据的随机性导致音频质量不稳定,因此自动化验证和多轮重试策略必不可少。同时,依赖的第三方库存在频繁更新和兼容性风险,后期维护需保持适当关注。 展望未来,剪除训练语音尾部无用静音、优化数据水印处理、探索端到端从零训练等方向值得尝试。构建更大规模训练集和升级硬件将持续提升模型音质和鲁棒性。此外,定制词典和发音规则也有望进一步改善罕见词汇的合成准确度。个人声音克隆、影视角色定制等创意应用也顺理成章成为可能。

通过持续迭代和优化,此类低门槛训练方法将极大推动本地AI语音合成普及与创新。 总结来看,以极简数据完成Piper TTS声音训练的技术路线,代表着AI语音定制的便捷化与平民化趋势。借助先进的零样本生成模型和自动化质量控制手段,即使硬件和数据资源有限的开发者,也能打造专属的合成声音。结合容器化部署与开源社区资源,整个流程具备较高的复制性和可持续性。期待未来更多爱好者和企业应用此方案,推动人机交互体验步入更富个性且更具亲和力的新时代。