随机对照试验(RCT)作为医学研究的金标准,其结果的可靠性直接关系到临床决策和健康指导方针的制定。为了保障系统评价中的证据质量,风险偏倚评估(Risk of Bias,RoB)成为不可或缺的环节。近年来,随着技术发展,修订版风险偏倚工具(RoB2)被广泛采纳,以克服旧版本中存在的不足,提供更加科学和系统化的偏倚评估框架。然而,RoB2的复杂性和专业知识要求较高,导致实际应用中出现了低一致性和高时间成本的问题,使得大量系统评价难以高效准确地完成偏倚评估。大语言模型(LLM)作为人工智能领域的革命性技术,其强大的自然语言理解和推理能力,为解决RoB2实施难题提供了新的可能。本文将深度剖析LLM辅助RoB2评估RCT风险偏倚的一系列研究成果、方法创新及实际效果,展望其对未来医学研究和系统评价工作的深远影响。

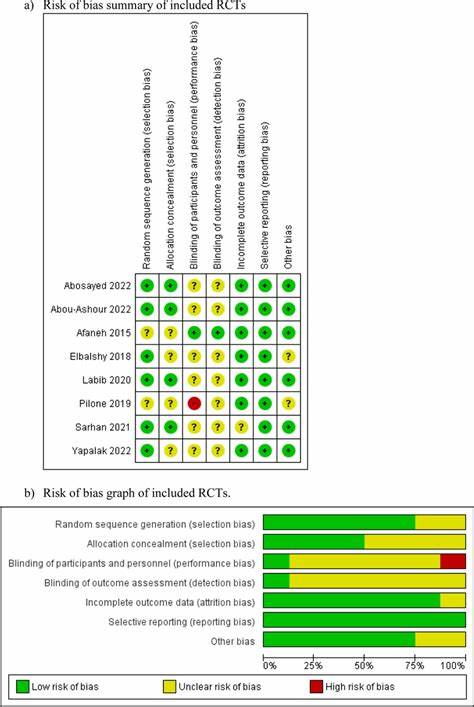

RoB2是由科克兰协作组织发布的风险偏倚评估工具,涵盖随机化过程、干预偏差、缺失数据、结果测量及报告选择等多个关键领域,评估结果分为“低风险”、“存在一定担忧”及“高风险”三个等级。尽管其结构科学严密,但高复杂度使得评审人员在判断时面临巨大挑战,尤其是在“干预偏差”和“结果测量”两个领域,要求审稿者具备深厚的专业知识和细致的文本解析能力。人工评审不仅需要投入大量时间,且不同评审者间的结果往往存在较大差异,严重影响系统评价的效率和稳定性。面对上述问题,大语言模型的发展为难题的破解开辟了新思路。LLM通过庞大的语料库训练,具备挖掘文本间关联、理解复杂方法学细节、模拟人类推理过程的能力,为自动化风险偏倚评估带来了更高的准确率和一致性。尤其是其链式思维(chain-of-thought)技能,使得模型能够按照专业人员的逻辑步骤逐项分析信号问题,形成更精准的风险判断,进而解决人工评审中主观性差异和知识盲区的问题。

在一项针对46项RCT的大规模验证研究中,研究人员利用名为Claude 3.5 Sonnet的LLM对RoB2进行系统化评估。该过程采用了严格的提示工程技术,指导模型提取与RoB2信号问题相关的关键信息,回答相应问题并基于此做出每个领域的风险评定。整体结果显示,LLM在信号问题层面达到了约83%的平均准确率,且大多数问题的准确率超过70%。当利用LLM产生的信号问答数据通过RoB2算法推导领域判断时,部分准确率明显提升尤其是在干预偏差领域(包括“分配”和“依从性”方面),表明模型通过符合工具逻辑的流程达到了更优的评估质量。更令人惊讶的是,LLM评估的耗时仅为人工评审的约6%,从平均31.5分钟缩短至不到2分钟,显著提高了工作效率。评审一致性方面,LLM两次独立评估间保持了85%以上的稳定性,显示出极高的复现能力。

值得一提的是,虽然LLM凭借提示工程表现良好,但也暴露出信息提取不足、前提问题误判和对复杂数据如盲法状态识别的逻辑错误。这些不足提醒我们当前的AI辅助评估尚不能完全替代人类专家,而应发挥辅助作用,例如减少双重独立评审的工作负担,促进偏倚风险的初步筛查和复核。此外,LLM的应用对评审标准的统一也有积极意义,避免了不同团队因主观判断标准不同带来的偏差,提升了跨研究的一致性。该研究还指出了未来改进方向,包括扩大医学领域的应用范围、提升模型处理附件材料的能力和进一步优化提示设计。随着AI技术的发展,尤其是更强大模型的推出,RoB2评估的自动化和智能化程度有望大幅提升,并逐渐实现零样本或少样本模式下的高效评估。为了保证透明度,研究者在引用LLM辅助结果时应详细说明所用模型版本及提示策略,以利结果复现和可信度检验。

整合现有研究可见,LLM在RCT风险偏倚评估的应用前景广阔。但实际运用时仍需谨慎平衡AI的高效优势和潜在偏见风险。模型可能因训练数据固有的偏倚而误判特定方法或报告形式,故人工监督和专业校验依然必不可少。未来通过持续学习、与临床专业知识结合和多模型融合,有望最大化AI技术的辅助能力,推动系统评价向更高质量和效率迈进。综上,LLM通过深度理解复杂文本和模拟专业判断,为RCT使用修订版风险偏倚工具的评价提供了强有力的技术支持。它不仅大幅缩短分析时间,减轻人力成本,还通过标准化流程减少主观差异,提高评审一致性。

尽管尚无法完全替代人工,但作为辅助工具,LLM已展现出非凡潜力,值得在医学研究和证据合成领域进行更广泛的探索与应用。未来,随着模型持续迭代升级和提示技术的不断优化,LLM辅助风险偏倚评估将成为推动临床循证医学发展的重要引擎。研究人员和系统评价者应关注相关领域进展,积极尝试结合先进语言模型,以提升自身工作效率,助力精准医疗决策和患者福祉的提升。