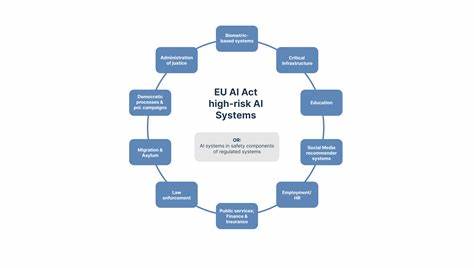

随着人工智能技术的快速发展,如何规范其应用成为全球关注的焦点。欧盟作为世界上最严格、最具前瞻性的数字法规制定者之一,近年来推出了人工智能法案(AI Act),旨在通过明确的法律框架保障技术发展的安全性和伦理性。在该法案中,高风险系统的分类尤为关键,因为它关系到具体的监管力度和合规要求。为了更好地完善法规,欧盟开启了面向公众的咨询过程,广泛收集社会各界的意见和建议,力图打造更具包容性和科学性的监管机制。 欧盟人工智能法案的核心理念是风险分类管理,尤其是对那些可能对个人安全、基本权利和公共利益产生重大影响的AI系统进行严格监管。所谓高风险系统,涵盖了医疗设备、交通管理、执法辅助工具、教育评估系统和关键基础设施等多个领域。

这些系统一旦出现失误,可能导致严重后果,因此在设计、开发和部署阶段需满足更高的透明度、可解释性和安全控制标准。 公众咨询作为立法过程中的重要环节,旨在确保法规不仅仅来自官僚机构的单方面设计,而是科学吸纳现实需求和多方声音。通过这一公开征询,欧盟委员会邀请企业、研究机构、消费者团体以及普通公民提交反馈,对高风险系统的定义范围、分类标准、应适用的具体要求以及监管落实方式进行讨论。公众的积极参与为法案提供了宝贵的数据支持,使得监管方案更具灵活性和可执行性。 此次公众咨询揭示了多个关键议题。首先,如何界定“高风险”成为焦点。

一部分意见认为应严格限定在对人身安全或基本权利有直接影响的系统,避免过度扩张监管范围给创新带来不必要障碍;另一部分则强调应扩展定义,特别是涵盖潜在歧视、隐私泄露等风险。其次,针对不同类别的高风险系统,需设计差异化的合规要求,不宜一刀切。医疗AI系统可能需要临床试验数据支持,而自动驾驶车辆则侧重于环境感知和故障响应能力。 此外,公众咨询也推动了对监管机制创新的探讨。除了传统的事前审核和认证程序,有意见建议采用动态监测、第三方评估和后续监管结合的方式,确保AI系统在全生命周期内符合安全规范。技术的快速迭代意味着监管也需灵活应变,适时调整标准和检测方式。

公众对于隐私保护的高度关注也促使立法者考虑引入更加严格的数据治理规则,确保AI应用不损害用户权益。 作为数字主权和科技伦理双重主体,欧盟在此次公众咨询过程中体现出开放与包容的态度。多种语言、多样文化背景参与反馈,丰富了立法视角,有助于避免法规单一视域的局限。通过网络平台和线下研讨,欧盟汇集了跨行业的智慧,加快了法规的完备性和国际兼容性。欧盟希望以AI法案为标准引领全球AI治理走向规范、有序的发展轨道。 在全球范围内,人工智能监管正在形成多极格局。

美国则更多依赖行业自律和局部立法,中国注重顶层设计和技术创新支持。欧盟的高风险系统分类和公众咨询模式则强调权责明确和公众参与,强调法律的底线作用。未来,这一监管框架或将影响跨境数据流动和技术合作,成为企业合规的重要参照。 值得关注的是,随着人工智能应用的不断扩展,高风险系统的定义将保持动态演进。公众咨询作为民主决策的重要工具,确保法规与技术发展同步,兼顾安全和创新。参与者的反馈不仅有助于修订标准,也推动相关产业改进内控体系,树立行业标杆。

欧盟在这一过程中积累的经验将为世界各国提供宝贵的示范。 总结来看,欧盟围绕人工智能法案高风险系统分类的公众咨询彰显了其立法的严谨性与开放性。通过广泛吸纳社会各界声音,欧盟不仅提高了法规的科学性和权威性,也增强了公众对AI治理的信任感。立法者通过兼顾技术进步与社会责任,推动构建一个安全、透明且有保障的人工智能生态环境。未来,随着法律的正式实施与不断完善,欧盟有望引领全球人工智能规范的范式,促进技术健康发展,为全球数字社会树立典范。