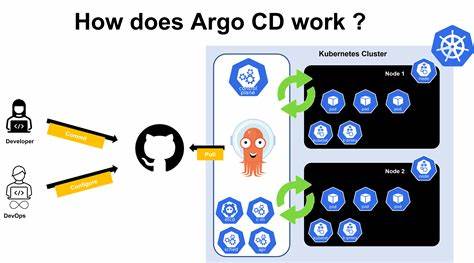

随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLM)在自然语言理解和生成领域展现出前所未有的能力,带动了智能对话、文本生成以及知识自动化处理的变革。InfiniChat作为一款聚焦本地运行LLM对话的创新工具,通过模拟两个人工智能模型之间的持续对话,为AI研究者和开发者提供了一个独特的观察和试验平台。该平台不仅帮助用户理解AI模型的交互特点,更展示了多模型协作的未来可能性。InfiniChat的背后灵感源于人们对AI自主对话能力的好奇和探索欲望。它在命令行界面中,通过Ollama框架连接本地部署的多个大型语言模型,让这些模型能够彼此交流,持续演绎丰富多样的对话内容。用户可以自定义对话主题、调整模型参数,甚至设定辩论模式,让两个模型分别扮演正反双方展开辩论,极大丰富了应用趣味和深度。

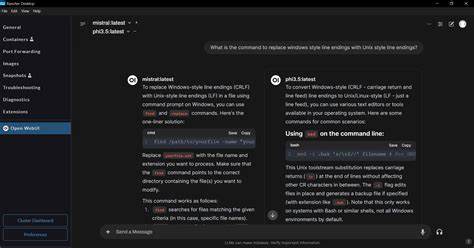

InfiniChat支持完整的对话历史追踪,确保模型在对话过程中的连贯性和上下文理解能力。它也支持流式输出,实时将模型回答呈现在屏幕,配合色彩区分不同模型的发言,使终端界面既直观又具有观赏性。开发者能够方便地根据需求调整对话最大轮数、单次回复的最大token数等参数,兼顾性能和输出质量。由于本地模型运行需要较高的计算资源,InfiniChat推荐使用拥有一定内存容量的设备,确保25GB以上的RAM能够支持模型顺畅运转。平台默认集成了llama3:latest和gemma3:12b两款流行的大型模型,也支持自定义替换,满足多样化需求。InfiniChat的运行环境依托于Python,配合pipenv进行依赖管理,用户只需简单几步即可完成安装和配置,快速启动对话体验。

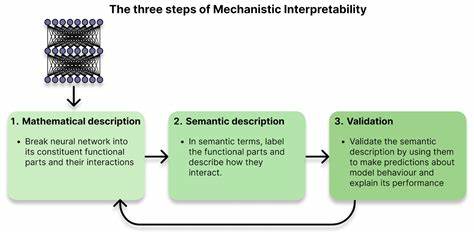

其开源性质鼓励社区积极参与改进与扩展,吸引了对AI对话系统感兴趣的程序员和研究者交互贡献。使用InfiniChat,可以实现诸如头脑风暴、观点辩论、知识探讨甚至创意故事生成等多种对话形态。辩论模式特别适合对某一具体议题进行深度探讨,模型分别扮演支持与反对角色,为用户提供多角度的视野。此外,InfiniChat的对话自动保存功能也便于用户事后回顾和分析,生成的对话文本文件方便整合进研究或写作流程。这种模拟AI间对话的方式,不仅有助于挖掘模型潜在的语言理解和推理能力,也为未来多智能体系统的协作研究提供了宝贵经验。通过观察AI模型在特定约束或自由对话环境中的表现,研究者可以捕捉其偏好、矛盾点及创新思想。

这不仅打开了AI自我学习和自主交互的新思路,也为构建更智能、更具交互性的系统奠定了基础。InfiniChat还通过命令行参数灵活定制用户体验。通过增加对话轮数,可以模拟更长时间、更复杂的讨论;调整流输出速率,适应不同阅读习惯和演示需求。自定义模型提示语也允许塑造不同风格的AI个性,比如让一个模型扮演幽默助理,另一个则保持学术严谨,形成鲜明对比。随着本地化AI技术的发展,用户越来越关注数据隐私和离线操作的优势。InfiniChat正是在这一趋势下应运而生,支持全程本地运行,不依赖云端服务,保护用户数据安全同时确保对话内容的高度私密性。

这对于企业和个人用户而言,既满足了技术探索的需求,也降低了使用风险。展望未来,InfiniChat有望整合更多先进模型和更智能的管理策略,提升对话质量和多模态交互能力。结合图像、声音等多样信息输入输出,将创造更加丰富和立体的AI交流体验。同时,开放的社区协作也将推进功能扩展与优化,促进AI生态系统的繁荣发展。总体来说,InfiniChat是AI对话领域一款富有创意和实用价值的工具,在推动本地大型语言模型研究和应用方面发挥着重要作用。它为用户提供了观察和深入理解AI行为的窗口,激发了人工智能互动设计的更多可能。

对于科技爱好者、研究人员以及创新开发者而言,InfiniChat无疑是探索AI多智能体对话、模拟交互场景的绝佳起点,为人工智能技术的未来演进增添无限想象力。