随着人工智能技术的迅猛发展,大型语言模型(Large Language Models, LLMs)已成为推动自然语言处理领域创新的重要引擎。它们不仅广泛应用于翻译、问答、内容生成等多种场景,同时也在虚拟助手、智能客服等实际生活中发挥着日益重要的作用。随着LLM在各领域的深入渗透,理解这些模型的决策过程和潜在“个性”成为了业界和学术界关注的焦点。对此,研究者们提出了通过关键事件分析(Critical Event Analysis)方法来揭示模型背后的个性特征,令模型的行为更加透明且易于解释。关键事件分析作为一种从历史、新闻、传记等文本资料中提炼并重点解读重要事件的手段,能够帮助我们了解模型如何感知、筛选并排序信息,这反映出模型在处理信息时的内在偏好与风格。近日,Pranav Agarwal与Ioana Ciucă发表了题为“Supernova Event Dataset: Interpreting Large Language Models' Personality through Critical Event Analysis”的研究论文,首次构建了包含丰富文章类型的“Supernova事件数据集”,涵盖传记、历史事件、新闻报道以及科学发现,专门用于评估和比较不同LLM在关键事件提取与排序上的表现。

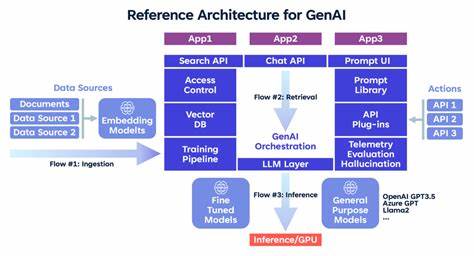

该研究不仅比较了多款小型模型如Phi-4、Orca 2、Qwen 2.5,还引入了Claude 3.7、Gemini 2.5以及OpenAI的o3等较大型、高性能模型,基于其对事件的重要性判断展现出的风格差异,进一步邀请另一款LLM担任“裁判”,对各模型的事件选择与分类结果进行分析,进而推断模型各自的“个性特征”。具体而言,Orca 2模型表现出明显的情感推理倾向,特别关注人际关系和情绪因素,在处理人物传记内容时更偏重于人物间的互动动态。Qwen 2.5则呈现出富有策略性的分析风格,善于对事件进行深度逻辑推敲和结构化解读,其判断标准更像是一位策略家,注重长远因果链条和决策层面的优化。而在科学发现相关内容的分析上,不同模型展示出鲜明的差异化风格:Claude Sonnet 3.7强调概念架构的构建,注重理论背景和抽象理解;Gemini 2.5 Pro更倾向于实证验证,侧重数据和实验的真实性;OpenAI的o3模型则以详尽的步骤性因果推理著称,喜欢分解事件的因果关系,逐步揭示事物发展的逻辑路径。这一创新的研究方法为挖掘LLM的内在“心理”提供了全新视角,突破了传统仅通过性能指标评估模型的局限。由于关键事件的选择具有较强的主观性,模型在处理时必然带有一定的价值观和认知偏向,这些偏向实际上塑造了模型的“人格特质”。

从某种意义上说,通过让模型展示它们如何看待“重要性”,我们也窥探了它们理解世界的方式。探索模型个性特征不仅对学术研究有益,更对实际应用产生深远影响。例如,在智能助理设计中,如果能掌握模型在情感理解或分析思维方面的不同,都能够为用户提供更个性化、贴合需求的服务体验。同时,明确模型的偏好方向,有助于规避潜在的偏见与误判风险,提升模型的安全性与公平性。此外,关键事件分析框架的引入,为后续模型调教(fine-tuning)提供了指导方向。通过调整模型对事件的关注点,可以实现风格和表现的定制化,打造出更具特色和差异化的语言模型版本,满足特定行业或人群的需求。

从技术层面看,Supernova事件数据集作为基础工具,无疑为相关领域的研究者搭建了丰富且多样化的数据平台,有助于推动事件抽取、因果推理等NLP子任务的发展。其涵盖各类文本的设计,也保证了实验的普适性与多样性,提升了研究结论的可靠性和泛化能力。同时,运用另一款LLM作为“裁判”以判定模型的个性特征,体现了当前多模型协同和相互评估的趋势。这种方法不仅节省了人工评审成本,也提高了评估的客观性,显示了未来模型互评与合作的新方向。未来的发展可以在此基础上进一步探索更多维度的模型个性解读,例如结合情绪分析、价值观评估以及多模态信息处理,构建一个更加全面的多维度“模型性格画像”。这样不仅可以助力优化模型设计,还能提升人机交互的自然度和有效性。

总结来说,通过关键事件分析揭示大型语言模型的个性特征,是理解和优化LLM不可忽视的重要路径。随着模型规模不断增大和应用场景愈加复杂,深刻洞察这些模型内在的偏好和思维方式,将极大推动人工智能的可信赖性和智能化水平。Pranav Agarwal与Ioana Ciucă的研究为该领域注入了新活力,其提出的理论框架和数据集为未来相关探索奠定了坚实基础。展望未来,期待更多创新方法涌现,推动大型语言模型在人类社会中发挥更为积极和智能的作用。