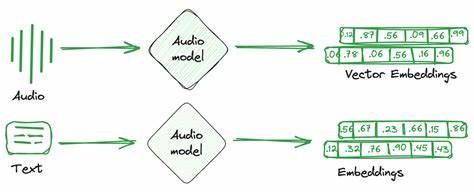

在当今数字化和智能化的浪潮中,如何快速处理和检索海量数据成为企业和研究机构面临的共同挑战。向量化技术,尤其是生成语义嵌入(embedding)以及构建高效的向量索引库,是提升自然语言处理、推荐系统、图像检索等领域性能的核心技术。而随着GPU计算能力的飞速发展,如何充分发挥硬件优势,加速生成大规模嵌入并高效建立索引体系统成了提升整体AI系统能力的关键一步。 嵌入向量是将复杂、高维且多样化的数据转化为固定维度的数值向量,进而使得计算机能够理解其语义关系与特征信息。生成高质量嵌入不仅能提升模型的理解和匹配能力,还为后续的相似度搜索、聚类和分类应用奠定基础。然而,面对数亿级别甚至更大规模的数据集,传统CPU处理方式常常难以满足时效需求,索引构建的效率也容易成为数据处理瓶颈。

为了突破计算性能瓶颈,大量领先企业和专家借助GPU强大的并行计算能力,结合优化的软件栈,打造了基于GPU的高性能嵌入生成与向量索引构建方案。例如,利用NVIDIA的DGX Cloud Lepton平台,融合Nebius等合作伙伴的云GPU资源,可以实现对数千万条文本进行分布式并行计算,大幅缩短嵌入生成时间。同时,借助如FAISS这样成熟的GPU加速向量检索库,不仅能快速完成索引的构建,还能确保实时检索的高效响应。 多样化的应用场景要求向量索引系统具备极强的灵活性和拓展性。在企业级别的信息检索中,如何根据不同类别、领域或客户需求,构建独立且细粒度的向量库,成为提高搜索精准度和用户体验的关键。比如针对Reddit这样拥有超过三万个社区(subreddit)的平台,构建每个社区独立的向量索引,不仅能精准匹配用户输入的语义,还可通过聚合社区中心向量进行快速的初步筛选,极大丰富推荐系统的智能性。

这一系列流程的成功得益于深度集成的AI软件框架和自动化工作流管理工具。如Outerbounds平台基于Metaflow构建的稳定且开发者友好的API,既支撑了高吞吐量的批量嵌入计算,也管理了复杂的索引更新流程。此外,通过自动环境依赖打包与GPU资源调度装饰器,保证了在各类云环境中应用可以无缝运行,大幅降低了系统运维和开发门槛。 加速嵌入生成不仅依赖软硬件的深度配合,更需要不断优化模型本身与处理流程。嵌入模型的设计需要兼顾精度和计算效率,像NVIDIA NeMo Retriever的nv-embedqa-e5-v5模型,针对问答和文本检索特性进行了专项调优,能够在保持低延迟的前提下,提供高质量向量表示。此外,合理运用批处理机制与并行化策略,对数据进行分片处理,使GPU资源利用率最大化,也成为提升整体效能的关键要素。

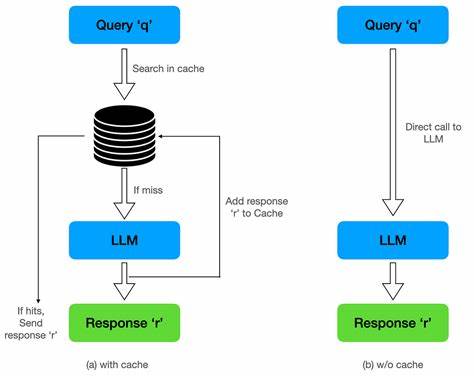

向量索引构建是大规模检索系统的基石。借助GPU加速的FAISS库,能够在极短时间内处理千万级别嵌入数据,生成精准且高密度的索引结构。相比传统多核CPU处理,单块NVIDIA H100 GPU在索引速度和资源成本上均展现出数倍优势,体现了现代高性能计算的巨大潜力。同时,索引库的分布式管理与动态更新能力,使得系统能快速适应数据变化,实现实时响应和持续性能优化。 数据隐私和安全合规也成为向量处理系统不可忽视的要素。许多企业倾向于自建端到端AI解决方案以掌控数据全生命周期,避免将敏感信息托付于第三方API。

通过集成GPU云服务和闭环工作流平台,实现模型训练、推理、索引构建全过程在自主环境中完成,既满足监管要求,也增强了系统安全性和稳定性。 构建响应迅捷、稳定可靠的向量检索系统,还要求开发和运维团队拥有完善的监控和版本管理能力。通过Outerbounds等平台,可实现对代码、模型和数据的全面追踪,支持多版本并行部署与AB测试,从而在复杂多变的业务场景下保持创新与质量的平衡。团队成员之间的协作因清晰的资产管理和隔离策略而变得高效且安全。 在行业趋势的推动下,未来加速生成嵌入和向量索引的技术将更加智能化和自动化。模型架构的不断升级、新一代GPU硬件的迭代,以及云计算资源的广泛普及,都为开发者打造更灵活、更强大、更易用的向量处理平台提供了坚实基础。

面向不同行业的应用需求,定制化嵌入模型和多层次索引策略将成为常态,助力企业深度挖掘数据价值,实现前所未有的智能创新。 总结来看,快速高效地生成嵌入向量和构建海量向量索引,不仅需要高性能的硬件支持,也离不开完善的软件生态和敏捷的开发流程。借助包括NVIDIA DGX Cloud Lepton、Nebius云GPU资源、FAISS加速库及Outerbounds开发平台的集成应用,企业能够突破数据规模和计算复杂度的限制,打造具备端到端自主控制、安全合规及高效响应的下一代智能检索系统。在加速AI产品落地、提升用户体验和优化商业决策中发挥着举足轻重的作用。 。