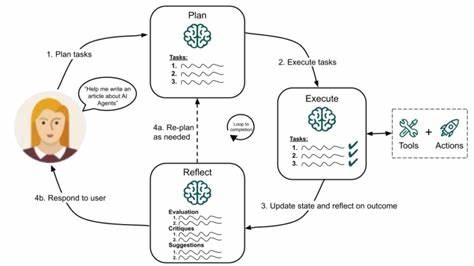

随着人工智能技术的迅猛发展,如何构建更加智能、高效且稳定的AI代理成为业界关注的焦点。Cogency作为一款前沿的认知架构,针对AI代理的执行状态管理和多轮对话保持提出了创新性方案,助力智能系统实现无缝且上下文感知的交互体验。Cogency通过独特的设计理念和技术实现,突破了传统AI代理面临的状态同步和恢复难题,成为人工智能领域中备受关注的开源项目。作为一款面向开发者的工具,Cogency致力于通过完善的执行架构和强大的状态管理机制,提高AI代理的鲁棒性、扩展性和效率。其核心在于将状态外化到持久存储中,通过“先持久化后重构”的方法确保每次执行都基于最新的上下文,这一设计极大地减少了因状态不一致产生的错误,并支持崩溃恢复。Cogency的执行模式灵活多样,主要包括“恢复模式”、“重放模式”与“自动模式”。

恢复模式通过WebSocket会话保持工具调用之间的LLM(session)状态,减少了上下文重放的需求,有效地控制了Token消耗,适合对响应时间敏感的互动场景。重放模式则在每轮请求中从存储重建上下文,确保了内容的完整性与对话一致性,兼容更多类型的语言模型。这种模式对存储依赖较大,但增强了系统的灵活性。自动模式结合以上两者,根据实际网络与环境条件智能切换,既保证了效率也维护了兼容性。状态管理方面,Cogency采用了一套明确的分割协议,使用特殊标记(如§think、§call、§execute、§respond、§end)来标识不同的执行阶段和状态,确保代理的动作步骤具有高度可追踪性与操作清晰度。所有对状态的更新均即时写入持久存储,这使得系统能够在任意时刻准确反映执行进度,且即便面临系统故障,也能从日志中精确恢复。

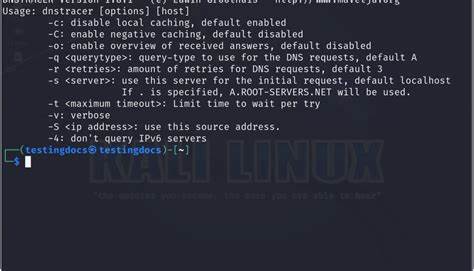

通过将状态外部化,Cogency实现了无状态设计思想中的纯函数特性,使得代理与上下文组装成为纯函数操作,维护了代码的简洁和模块化,且减少了并发执行时的冲突风险。多轮对话支持是当代智能代理不可或缺的功能,Cogency通过构建基于事件的存储系统,将用户请求、代理思考、工具调用等数据作为类型化记录储存,形成完整的对话轨迹。此外,系统还支持配置历史窗口,控制上下文消息的长度,帮助开发者在保证对话连贯性的前提下管理计算成本。Cogency对外提供丰富的内置工具集,涵盖文件读写、搜索抓取、Shell命令执行等,同时支持用户自定义工具的接入与调用,极大扩展了AI代理的应用场景。通过Tool接口,开发者能够轻松封装自有逻辑并整合进智能代理的工作流中,使AI助手在处理复杂任务时更具灵活性和专业性。智能学习则是Cogency的另一亮点。

系统能够基于用户ID进行被动学习,自动吸收和调整用户偏好,提升对话的个性化和精准度。通过主动回溯检索工具,Cogency还能跨会话调用历史信息,确保长时间、多轮次的交互中保持连贯的上下文关联。成本控制和资源优化也是Cogency设计的重点。不同于传统需要频繁重复传入大量上下文的AI调用,Cogency的恢复模式显著减少了Token的使用量,经过数学验证的效率效果在多轮交互中表现尤为突出。具体来说,恢复模式在8轮交互中能达到5倍以上的Token使用效率提升,进一步提升了系统的实用性和经济性。从安装部署的便捷性来看,Cogency基于Python开发,通过简单的pip命令即可快速完成安装,支持多种LLM服务商接口,包括OpenAI、谷歌Gemini和Anthropic。

开发者只需设置API密钥,即可启动高效的智能代理服务。Cogency不仅注重系统架构的先进性,还在文档完善和社区支持方面展示出极大诚意。通过详细的设计文档、协议说明和效率证明,开发者能够深入理解其核心机制,同时项目持续更新和维护,有助于生态健康成长。总的来说,Cogency通过革新的思路和技术实践,在AI代理的技术领域树立了新的里程碑。其基于持久化重构的状态管理和多模式执行策略,为实现更智能、更稳定的人工智能服务提供了坚实基础。无论是对话系统、智能助手还是自动化工作流,Cogency都展示出广泛的应用潜力。

未来,随着对更复杂认知任务的需求不断增长,Cogency的设计理念和技术框架有望推动智能代理向更深层次发展,促进人工智能与人类生活的融合创新。开发者和研究人员可持续关注和参与该项目,共同探索认知架构在实际应用中的更多可能,助力打造真正具备认知理解能力的智能系统。