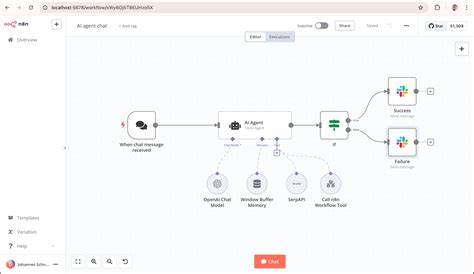

随着人工智能技术的不断发展,越来越多的企业和开发者开始关注如何在本地安全、高效地部署AI模型,实现自动化智能化工作流。云端AI服务虽然便捷,但数据隐私、安全性以及成本压力依旧是不可忽视的挑战。基于此,结合n8n、Docker Model Runner和Docker MCP工具包打造本地AI自动化平台,成为理想的解决方案。通过这套强大的三组件架构,用户不仅可以实现本地智能推理,还能保持对数据的完全控制,同时享受极致的性能优化与灵活的工作流编排能力。 n8n是一款开源且公平代码许可的工作流自动化平台,支持400多种集成,兼顾无代码的快速上手与代码灵活度,允许用户通过拖拽式界面构建复杂流程,也支持自定义JavaScript或Python脚本,充分满足不同开发需求。它不仅支持多种数据库和缓存系统,如PostgreSQL和Redis,还可以集成多种API服务和AI能力,助力用户轻松搭建智能化工作流。

更重要的是,n8n可以自托管,确保数据不会被上传至云端,保障企业数据隐私与安全。 Docker Model Runner作为Docker Desktop 4.40版本引入的实验性功能,开创性地突破了传统容器化AI推理的限制。它通过在主机层面运行推理服务,将大型语言模型(LLM)直接部署在宿主机上,避免了容器化带来的性能损耗和资源开销。特别针对苹果芯片(Apple Silicon)做了深度优化,利用Metal API实现GPU加速,提升推理速度和响应性能。Model Runner采用OCI artifact格式管理模型,依托Docker Hub实现模型的标准化存储和分发,确保了模型的灵活部署和快速更新。通过兼容OpenAI的API接口设计,开发者能够无缝替换云端模型,直接调用本地推理服务,无需调整业务逻辑。

与此同时,Windows平台支持也已逐步完善,未来跨平台特性将更加成熟。 Docker MCP工具包极大丰富了AI自动化生态的外部交互能力。MCP即Model Context Protocol,定义了AI代理与外部系统、安全工具之间的标准交互协议。通过MCP,AI模型可以安全、受控地访问文件系统、调用外部API、操作GitHub仓库,甚至编排复杂的工具链,实现多步骤、多系统的智能自动化。MCP以沙箱方式执行外部工具,保证系统安全和稳定。Docker MCP工具包以扩展形式集成于Docker Desktop,方便用户通过图形界面或命令行管理MCP服务器及其权限,简化了配置和权限管理过程。

特别是对GitHub的深度集成,使得开发者可以轻松构建与代码库自动交互的智能工作流,实现代码分析、问题创建、PR管理等高效协作。 整合n8n、Docker Model Runner与MCP工具包能够构建一个功能完善、性能卓越且安全可信的本地智能自动化平台。n8n负责工作流的编排和任务调度,将各类触发器、数据处理节点与AI推理节点有机串联。Docker Model Runner作为本地AI推理引擎,承担核心的语言理解和生成任务,确保推理速度快且模型可控。MCP工具包则拓展了AI模型与外部系统的交互边界,使得AI不仅停留在孤立的“大脑”,而是能够主动获取上下文、调用工具、回写结果,从而完成复杂的自动化目标。 搭建这套平台只需一份docker-compose.yml文件,极大简化了部署流程。

配置文件中定义了三类关键服务:PostgreSQL数据库、Redis缓存以及n8n工作流引擎。n8n容器内环境变量设置详细涵盖了数据库连接、缓存地址、加密密钥和AI集成相关参数,其中AI接口地址指向Docker Model Runner的本地API,默认端口5678公开暴露,实现浏览器访问控制台。通过挂载共享目录,n8n可以安全访问和处理宿主机文件,非常适合文档处理和数据导入等场景。生产环境可根据需求启用n8n的队列模式,强化任务执行的稳定性和扩展性。 在环境变量中,数据库用户名、密码、数据库名及加密密钥务必采用安全强密码,并根据时区配置调整机器的运行环境。此外,模型版本(例如ai/llama3.2:3B)也通过变量传递,方便快速切换模型版本以满足不同任务需求。

Docker Model Runner支持多种模型,用户可根据任务复杂度和计算资源灵活选择,从轻量级高效的1.2GB测试模型,到具备良好推理能力的3GB平衡模型,甚至更大规模的7B码能力模型。 使用该平台,用户可创建从简单对话生成到复杂代码分析的多样化工作流。在n8n内可以通过HTTP Request节点调用Model Runner的本地推理接口,实现交互式AI服务。结合MCP工具包的GitHub服务器,工作流还能自动访问GitHub上的仓库数据,执行代码检索、问题跟踪、PR管理等任务。整个过程数据保留本地,安全性极高,无需依赖任何云端第三方,实现了真正的离线智能工作流系统。 此外,Docker MCP工具包的秘钥管理和服务器配置功能极大简化了权限管理。

用户只需在Docker Desktop界面安装MCP扩展,创建并绑定个人访问令牌(PAT),即可启用GitHub MCP服务。通过docker mcp CLI,管理员还能轻松检查服务器状态、工具列表和密钥配置,保证系统安全有序运行。未来MCP扩展支持更多API如文件系统、数据库和第三方服务,将极大提升工作流的智能自动化能力。 本地AI自动化平台的重要优势在于其出色的性能和隐私保护。相比传统公有云AI服务,不存在网络延迟和访问瓶颈,响应速度惊人。借助Apple Silicon芯片的GPU加速,模型推理流畅高效,适合复杂自然语言处理和代码分析任务。

同时无需承担云端高昂的按量计费,长期运行成本显著降低。用户数据从生成、处理到存储全链路本地掌控,避免了数据泄露风险,满足企业对数据安全和合规性的高标准要求。 最后,整套平台的可扩展性和社区支持也非常出色。n8n拥有丰富的生态插件和强大的工作流设计器,用户可以自由设计定制化流程。Docker Model Runner通过标准OCI模型格式管理和Docker Hub分发,支持模型更新和多版本切换。Docker MCP工具包则链接生态多个工具和数据源,推动AI与外部世界深度融合。

整个体系正处于快速发展之中,社区活跃,文档齐全,开发者能够方便地获得技术支持和新功能升级。 总之,结合n8n、Docker Model Runner和Docker MCP工具包的本地AI自动化平台代表了当下AI应用部署的先进趋势。它完美融合了高性能的本地模型推理、强大的工作流引擎能力和安全可信的外部工具集成机制,突破了技术和安全瓶颈,为企业和开发者带来了灵活、安全、经济的AI智能化解决方案。无论是代码智能分析、文件智能处理,还是跨平台自动化协作,都能轻松实现。未来随着平台不断完善和跨OS支持显著提升,这套架构必将成为本地AI自动化的主流选择。开始构建您的本地智能自动化工作流,拥抱数据安全和计算性能的双重革新,释放AI全潜能!。