随着人工智能技术的迅速发展,链式思考(Chain-of-Thought,CoT)作为一种提升模型推理能力的技术手段,受到了广泛关注。然而,链式思考并不等同于可解释性,混淆这两个概念可能导致对人工智能系统的误解。准确理解两者的异同,对于推动可信赖且透明的智能系统建设至关重要。链式思考指的是人工智能模型在生成答案时,通过一系列推理步骤逐步展开思维路径,以更好地解决复杂问题。这种技术能够帮助模型更有效地拆解任务,展现出较强的演绎与归纳能力,特别适合数学、逻辑推理等需要多步推理的场景。许多研究表明,启用链式思考后,语言模型在完成复杂任务时表现显著提升,生成结果更加精准和合理。

尽管链式思考看似能展现模型的“思路”,但其并非真正意义上的可解释性。可解释性要求对模型的内部决策机制给予清晰、透明的解释,使人类用户能够理解为何模型会得出某一特定结论。换句话说,它关乎模型推理过程的真实性及其与输入数据之间的因果关系。链式思考过程往往是人工生成或自动生成的“推理文本”,它是模型在输出答案时的辅助性叙述,更多展现为模型的猜测或近似的推理过程,未必反映真实的决策机制。模型内部的计算路径和权重调整依然是一种黑箱机制,用户不能单凭链式思考文本完全理解模型的工作原理。正因如此,将链式思考误认为是模型的解释将带来潜在问题。

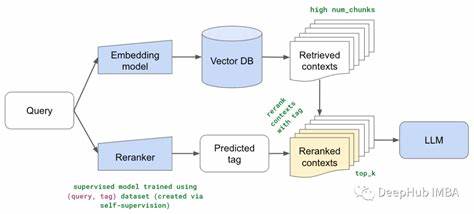

用户可能过分信赖这些推理步骤以为它们代表模型实际的判断依据,从而忽视了模型内部复杂且隐秘的学习机制,甚至使错误或偏见的推理步骤得到误导性的认可。事实上,当前主流的可解释性方法侧重于揭示模型参数对于输出结果的影响、多层神经元的激活情况以及模型决策过程中重要特征的贡献度等方面。这些技术如特征归因、注意力机制可视化和对抗样本分析等,旨在为模型决策提供更具实证性的解读,而非简单的自然语言推理文本。随着应用场景对人工智能透明度要求的提升,研究者和开发者开始更加重视可解释性技术的创新与实践,力求突破黑箱限制,帮助用户建立对智能系统的信任。链式思考作为提升模型推理水平的一种技巧,仍有其重要价值,特别是在复杂任务的逻辑推理表现提升方面。它能帮助模型拓展思考深度,为用户提供更连贯的答案生成过程,增强交互体验。

然而,要实现真正意义上的可解释性,除了链式思考以外,还需结合模型内部机制分析、多模态信息融合和可视化工具支持,形成多层次、多角度的解释体系。未来的人工智能系统将更加注重推理过程与决策机制的透明化,为不同领域的用户提供清晰、可信赖的模型解释,推动智能技术安全且普惠地应用于实际生活。总结而言,链式思考虽能展示模型推理的表面逻辑,但不代表真正的可解释性。明确区分两者对促进人工智能技术合理运用及提升其信任度具有重要意义。推动基于可解释性技术的深入发展,将为智能系统的伦理性、安全性和有效性保驾护航,最终实现更加智能透明的人工智能未来。