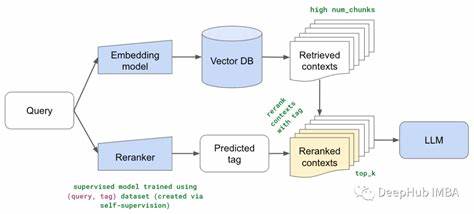

近年来,随着大型语言模型(LLM)在自然语言处理领域的深入应用,重排序技术作为提升搜索结果相关性和用户体验的重要环节,日益受到关注。ZeroEntropy团队于2025年7月发布了其最新的重排序模型zerank-1,凭借创新的训练方法和强大的性能表现,在LLM重排序器领域掀起了新的浪潮。zerank-1不仅在提升top-k结果精准度方面表现卓越,还以极具竞争力的成本和效率优势,超越了许多规模更大、资源消耗更高的封闭源模型,为搜索技术带来了新的革新契机。作为业界备受瞩目的新产品,zerank-1及其轻量版本zerank-1-small为搜索引擎和信息检索系统注入了强劲动力,值得深入探讨。zerank-1的诞生基于一种独特的训练框架——借鉴象棋及其他竞技游戏中使用的ELO评分系统,ZeroEntropy团队创新性地将这一机制应用于模型训练,通过成对偏好比较和排名优化,极大提升了模型在不同搜索语境中的适应性和判别能力。这种基于ELO的训练策略能更精细地捕捉查询和文档间的相关度差异,从而生成更符合用户意图的排序结果。

此方法的革新不仅体现在理论层面,更通过对多个领域标准基准测试的实证得到了验证。zerank-1拥有40亿参数,而其小型版本zerank-1-small也拥有令人惊艳的17亿参数规模,二者均展现出超越大多数现有公开及封闭模型的性能。与市场领先的种子模型如Cohere rerank-3.5及Salesforce LlamaRank 8B相比,zerank-1耗费的计算资源和使用成本几乎减半,提供了更具性价比的选择。尤其在整合多模态搜索策略中,如结合向量搜索和关键词搜索的混合检索方式,zerank-1表现出更增强的筛选和排序能力,显著提升了搜索结果的质量和用户满意度。零延迟和低成本的特点进一步使其适用于商业化大规模检索场景及实时响应需求。除了卓越的模型性能,zerank-1在实际应用中的丰富生态和友好接口也为开发者和企业带来便利。

zerank-1通过开放API广泛部署,并已上线HuggingFace平台,方便开发者快速接入、测试和集成。此外,zerank-1-small版本的加入使得轻量化部署成为可能,尤其适合对计算资源有限的设备及场景。除了核心技术外,ZeroEntropy团队力求透明公开,采用了简单明了的计费模式,每百万token仅收取0.025美元费用,降低使用门槛。在免费试用、丰富文档支持及活跃社区的辅助下,zerank-1正迅速赢得开发者的青睐与广泛合作伙伴的信任。回顾传统检索技术,BM25和基本向量搜索虽然在一定程度上满足了查询需求,但难以应对高复杂度的语义理解和排序优化问题。LLM重排序通过引入深层语言理解能力和上下文关联性分析,有效弥补了此种缺陷。

zerank-1在此基础上,结合创新训练算法与卓越调优策略,显著加强了模型的普适性和鲁棒性,适应了跨语言、跨领域、跨格式文档的多样化搜索任务。未来,零熵团队将持续推进zerank系列产品的升级迭代,拓展多模态、多任务的综合搜索解决方案,进一步推动AI驱动的信息获取技术走向深度融合与智能化。与此同时,随着对大规模数据和多样化检索需求的不断释放,zerank-1的低成本、高性能优势将持续为企业客户带来极大价值。总结来看,zerank-1不仅是一款集成先进技术的LLM重排序器,更是推动搜索技术革新的里程碑之作。它在提升搜索准确率、降低系统开销、优化用户体验等方面展现了巨大潜力。随着工业界和学术界持续关注重排序技术,zerank-1提供的解决方案无疑为搜索引擎和智能问答系统的发展树立了新的标杆。

通过开放的生态、创新的训练方式和卓越的实测表现,zerank-1引领了搜索技术向更精准、更高效、更广泛普及的方向迈进。对于期望提升信息检索能力、优化搜索体验的技术团队和企业,zerank-1无疑成为了不可错过的选择。随着该模型及相关工具的不断完善,未来的搜索世界将更加智能和便捷。