近年来,图神经网络(Graph Neural Networks, GNNs)成为机器学习领域的研究热点之一。许多研究者热切投身于该技术,期待其突破传统模型的局限,广泛应用于社交网络分析、推荐系统、药物研发等诸多领域。然而,尽管GNNs展现出一定的优势,我对其热度却持有较为谨慎的态度。这并非否定其价值,而是认为当前研究过于偏重某些方向,而忽略了其他更具潜力的领域和问题。 首先,理解一切模型的核心价值在于压缩信息是非常关键的。图作为一种数据结构,常被称为"非欧几里得"数据类型,但本质上,它只是一种特殊的方阵 - - 邻接矩阵。

在理想情况下,如果直接操作完整的邻接矩阵,我们甚至无需"嵌入"节点,因为每一行本身就是节点的向量表示。然而,现实中图多是稀疏的,导致此类矩阵大多为零,这使得图的表示和计算难度激增,更多地涉及离散数学的问题,而非传统的连续优化。 对比自然语言处理(NLP)领域,我们可以发现嵌入向量的产生同样基于矩阵压缩的思想。经典的词向量模型如Word2Vec与GloVe,本质即通过对词共现矩阵进行分解、降维,捕获词与词之间的关联信息。先进的语言模型如BERT,则是在此基础上引入上下文条件,进一步升级到高阶的共现关系矩阵,形成立体化甚至超图的复杂结构。语言模型虽然强大,但本质依然是针对巨大矩阵的有效压缩和近似。

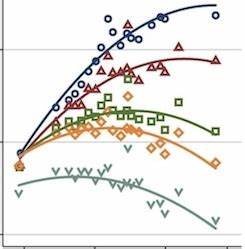

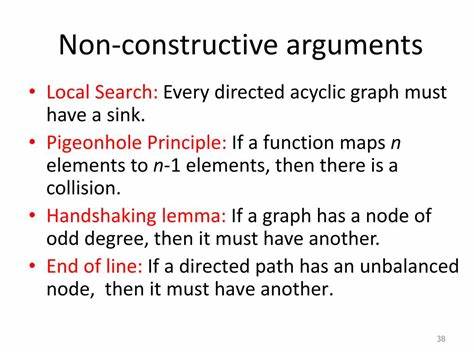

由此看来,图的嵌入本质也是在试图以更高效的方式对稀疏邻接矩阵进行压缩。 针对图数据,第一阶嵌入方法直接对邻接矩阵或其拉普拉斯矩阵进行因式分解,著名方法如Laplacian Eigenmaps和ProNE等,因其简洁高效在实际中表现不俗。而高阶方法则通过引入邻居的邻居关系乃至更远节点信息,对矩阵进行"升级",产生更丰富的表征,诸如GraRep、Node2Vec等方法便属于此类。然而,在许多应用场景下,第一阶方法的表现已能满足节点分类或图聚类等任务需求,同时计算成本远低于高阶方法,因此在实际部署中更具吸引力。 令人遗憾的是,现有的大量GNN研究中,大多采用过小且类型单一的数据集,如Cora、CiteSeer等,其中的节点数量通常在几千至几万之间,这些数据集的局限性使得算法性能难以体现和区分。更大规模、更真实的图数据集正逐渐被重视,但对这些挑战的深入研究仍待加强。

学界对于什么样的图结构更适合哪类嵌入方法,尚未形成明确共识,这也使得当前方法论的指导意义受到限制。 此外,学术界的研究氛围和动力机制对GNN领域的发展也产生了负面影响。部分研究为了追求发表和引用,倾向于在已有方法上加入细微修改,辅以花哨但效果不明的模块,缺乏严谨的对照实验和公正的参数搜索,甚至忽视了对比基线方法的深入调优。这种状况不仅浪费科研资源,也降低了真正创新的出现概率。以Node2Vec为例,其背后的一些技术点其实早已有先驱DeepWalk提出,然而由于实现效率低下,后续研究往往未深度调参,导致该线索未能被充分挖掘。 技术进步同样依赖于计算资源和实现效率的提升。

深度学习在2012年由于硬件和框架的进步才迎来爆发式增长,语言模型的崛起也得益于算法对大规模训练和微批量优化的支持。相比之下,许多GNN算法却在实现效率上仍显不足,训练一个中型图的嵌入可能耗时甚久,削弱了探索多种超参数组合的可能性,阻碍了研究创新。优秀的实现如作者开发的Nodevectors,能够把150,000节点的图嵌入时间从数十小时减少至几分钟,极大降低了实验门槛。 从架构视角看,神经网络的基础设计本身并非决定性能的终极关键。正如OpenAI的"Scaling Laws"表明,模型规模往往对性能的提升贡献更大。简单堆叠层数和参数量的扩增,往往比微调架构层次更有效。

与此同时,Transformer架构不仅在NLP,也在图神经领域崭露头角,显示出强大的泛化能力。这提醒我们,也许在过度关注复杂层设计的同时,研究者们忽视了基础计算资源的利用与优化。 图的数据结构表示技术目前仍有较大提升空间。常用的NetworkX因其数据结构基于指针链表,无法高效利用现代计算机的缓存架构,表现不佳。稀疏邻接矩阵格式如CSR适合读多写少的场景,但对于动态图的节点和边更新则不友好。边表结构则在某些查找操作上存在效率瓶颈。

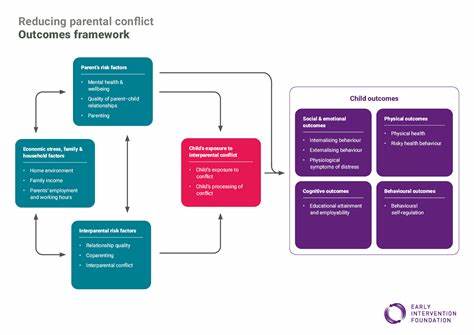

理想的图存储需综合考虑访问速度、存储效率和动态可扩展性,当前尚无完美解决方案。 未来图神经网络的发展需要更多基础理论创新和系统化的基准测试。例如,研究图结构类型与方法性能间的关系,开发面向大规模动态图的高效增量更新算法,探索诸如Poincaré嵌入等非欧几里得空间表示的潜力,都极具价值。此外,停止在陈旧小型数据集上"做花活",转向真实场景和大规模数据,将推进该领域实用化进程。 总的来看,图神经网络作为一项复杂而富有前景的技术,其现阶段的表现虽有亮点,但仍存在诸多制约因素。唯有理性审视现状,注重效率提升和理论基础,推动更大规模且多样化的测试研究,方能真正激发这项技术的潜力,推动其在实际应用中发挥更大价值。

未来的图学习研究应聚焦工具链优化、数据结构创新与核心理论问答,避免盲目追求模型复杂度,以实现健康可持续的发展态势。 。