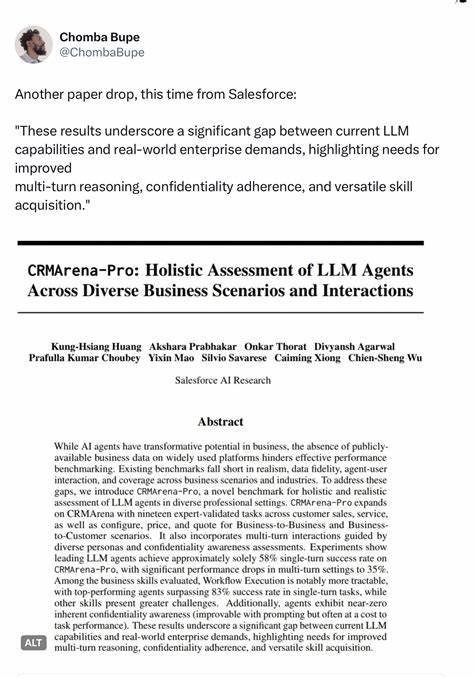

随着人工智能技术的飞速发展,特别是大型语言模型(LLM)的广泛应用,提示词工程(Prompt Engineering)成为AI开发的重要环节。如何有效管理和优化提示词,直接影响着模型输出的质量与应用体验。针对这一需求,Prompty应运而生,成为一种专门为LLM提示词设计的资产类与格式,旨在提升提示词的可观测性、可理解性和可移植性,为开发者内循环带来显著加速作用。 Prompty本质上是一种标准化的提示词资产格式,将提示词及其执行逻辑整合为单一资产。这种设计不仅方便开发者创建和管理复杂的提示词,还允许轻松追踪提示词的输入输出状态,实现更高效的调试和优化流程。通过Prompty,开发者能够在统一平台内协调多模型配置,切换不同模型环境变得简洁直观,大幅降低了跨团队协作难度。

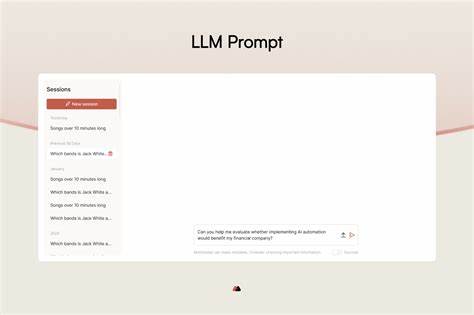

其规范化的语言规范使得提示词设计呈现出一致性和可复用性,显著减少重复劳动与人为错误。 Prompty的核心优势之一是其优秀的可观测性。传统提示词开发常面临黑盒操作、难以了解实际传递给模型的提示内容的问题。Prompty内置动态模板渲染功能,支持视觉化预览提示词内容,开发者在编辑阶段即可直观查看最终呈现给模型的完整文本,避免了因预期与实际不符带来的调试困扰。此外,Prompty支持详细的运行时输出,包括简洁和详细两种视图,使得提示词的请求与响应一目了然,极大增强了开发过程中的透明度和追踪能力。 在易用性方面,Prompty提供了与Visual Studio Code深度集成的扩展插件,使创建、预览和执行提示词流程高效便捷。

通过右键新建Prompty文件,快速启动提示词项目,利用内置的模型配置管理功能,开发者可以在用户级与工作区级别灵活定义API密钥和参数配置,方便共享或私有使用。支持的认证方式涵盖微软Azure Active Directory和OpenAI API,结合环境变量管理的多样化方案保证密钥安全,提升项目的安全合规性。 技术生态是Prompty发展的重要推动力。其已获得多个主流LLM编排框架的支持,如Prompt Flow、Langchain和Semantic Kernel,能够轻松生成针对这些框架的集成代码片段,实现提示词与应用逻辑的无缝连接。这种开放兼容的设计极大丰富了开发工具链,促进了技术生态间的协同创新。 Prompty背后的社区也极具活力。

自项目公开以来,吸引了大量开发者、研究人员和企业用户参与贡献,发布了多版本迭代稳定更新代码。该项目采用开源许可,致力于构建健康的开发规范和安全策略,为使用者提供多样化的支持渠道和文档资源,使技术传播更为顺畅。 使用Prompty,开发者能够有效管理版本迭代历史,追踪提示词在不同阶段的变更细节,这对于构建复杂、多模态或多步骤的提示工程项目尤为重要。借助动态模板和参数定义功能,提示词设计过程的灵活性得到极大提升,可以针对不同任务场景快速适配生成定制化的提示词内容。 另外,Prompty倡导的提示词资产化理念,不仅仅局限于代码层面,更是一种面向未来的大语言模型提示工程整体架构思考。通过统一标准的格式与工具链,推动提示词从零散文本信息转向结构化可执行资产,实现提示词的共享、复用与智能管理。

随着更多的智能应用场景涌现,这种资产化管理模式将成为保障AI系统稳定可靠的重要基石。 总的来说,Prompty以其规范化提示词语言、强大的集成功能、丰富的生态支持和友好的开发体验,成为引领大语言模型提示工程迈向专业化、工业化管理的重要创新产品。未来,随着人工智能技术的继续升级和应用规模的不断扩大,Prompty有望在促进提示词设计效率提升、保障模型输出质量以及加速AI系统开发迭代方面发挥更大作用。对于希望在大语言模型领域深耕的开发者和团队,掌握并使用Prompty无疑具有重要战略价值。