近期,苹果公司发布了一篇关于大型推理模型(LRM)在复杂推理任务中表现局限性的研究论文,引发了业界和公众的极大关注。这篇论文质疑了当前主流的大规模语言模型在解决类似“河内塔”等经典算法问题上的能力,指出它们在推理和记忆方面存在明显缺陷。文章一经发布,便在科技媒体和社交平台掀起热议,激发了多方回应。本文将聚焦七种对苹果论文的主要反驳观点,并深入剖析这些回应为何未能从根本上解决问题,反而暴露出目前人工智能技术尚未突破的核心障碍。 首先,有观点认为人类在处理复杂问题和长时间记忆方面同样存在困难,因此大型推理模型出现错误是可以理解的。但这种观点忽略了现代计算机技术的根本优势——它们能够稳定、准确地执行重复计算和复杂算法,而人类则难以做到这一点。

人工智能的终极目标应是超越人类的认知局限,实现计算和推理的革命性进步。然而,实际情况却是很多大型语言模型在完成简单却需要严密逻辑的任务时反而退化,难以达到预期效果。这显示出人工智能从“工具”向“类人智能”跃迁的过程中,仍存在根本性的障碍。 另一个反驳点聚焦于大型推理模型在生成答案时受输出长度的限制,导致它们无法有效完成需要大量步骤的复杂任务。确实,大型语言模型在生成长文本时可能受到“标记数”限制,这对算法类问题的完整输出构成挑战。然而苹果论文的关键实验如“河内塔”八盘任务,其最优解远未触及模型生成的长度上限,仍失败屡见不鲜。

与此相比,基于符号处理的传统人工智能系统则能完美解决这些问题,显示出当前大型语言模型的根本短板和技术瓶颈。这说明输出长度限制仅是表面问题,更深层次的是模型缺乏稳定执行复杂逻辑算法的能力。 针对论文作者身份质疑的反驳,则偏离了论文本身应关注的科学价值和实质内容。虽然苹果论文的第一作者是一名实习生,但其团队成员包括多位经验丰富的博士研究员,且全球科研界普遍认可第一作者通常为贡献最大的一方。质疑作者资历实为人身攻击,无法抹杀论文中严谨的实验设计和重要的科学发现。科研成果应以内容和数据说话,而非个人背景。

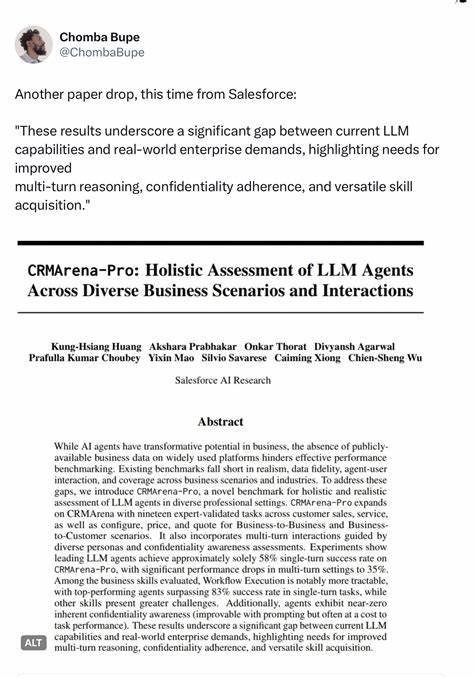

还有论点认为随着模型规模的不断扩大,这些问题必将被解决。虽然放大模型规模有一定空间能够提升性能,但苹果团队发现即使是大规模模型也只能在相对简单的六盘河内塔任务中表现较好,一旦任务复杂度提升到八盘便迅速崩溃。这说明简单依靠规模扩张无法根本解决推理模型在复杂任务上的泛化和稳定性问题。从某种意义上讲,模型增大反而使问题更加隐蔽,难以预测具体模型能达到的能力阈值,增加了研发的不确定性和风险。 部分回应提出通过“代码生成”或神经符号混合方法可以绕开问题,利用代码作为符号逻辑的载体,实现任务求解。这确实是当前研究的一个重要方向,展示了神经网络和符号系统结合的巨大潜力。

然而苹果论文的核心评测目的在于检验纯大型推理模型在不依赖外部程序调用情况下的原生推理能力。依赖代码生成或检索网络现成代码,虽然可以提升某些任务的表现,但其通用性和对未知任务的适用性依然存疑。倘若AI不能自主理解并构建解题逻辑,而总是借助现成“库代码”,那么其推理能力和灵活性就大打折扣。 对于论文只采用少量案例,且其中的河内塔测试并不完美的批评,虽然有一定合理性,但苹果团队结合了多项前期研究及类比实验,形成了彼此印证的有效证据链。学界陆续有诸多研究报告逐步揭示大型语言模型在语言理解、算法推理等领域的普遍弱点,例如模型在处理更复杂或更长输入时准确率迅速下滑,算法推理表现不稳定等问题不断被新实验证实,表明这并非孤立现象,而是当下技术的通病。 最后,不少人认为当前对大型语言模型泛化能力的质疑并非新鲜观点,相关问题早已众所周知。

确实,模型泛化能力低一直是学界难题,但苹果论文最大的价值在于它特定地以令人信服的实验体现并量化了这些限制,迫使业界和公众正视所谓“规模即智能”神话的局限。此论文通过鲜活的实例直观展现了模型实际运行中的种种不足,推动人们重新审视人工智能未来的发展战略,不再盲目依赖模型超大规模化路径,而是探寻融合神经符号、提升推理机制的新方法。 苹果论文引发的争议,不仅反映了人工智能领域当前的技术焦虑,更是行业思考未来发展方向的契机。通过深入分析七大反驳观点及其弱点,可以看到当前大型语言模型在实现真正通用人工智能的道路上还存在诸多技术瓶颈。未来的人工智能,必须结合神经网络的学习能力和符号系统的逻辑推理优势,构建更加可靠、通用且具备深层理解能力的智能体系。不能单纯依赖模型扩大,必须有系统性的方法革新和跨学科的综合探索。

综上所述,苹果推理论文以严谨实验和详实数据挑战了主流的规模主义观点,揭示了大型语言模型在复杂推理任务上的性能天花板。七大反驳虽然指明部分细节但未能破解核心难题,反映出现阶段人工智能需要反思和提升的关键方向。业界需要更多高质量、多角度的实证研究,推动实现真正具备稳定推理能力的通用智能,从而跨越现有技术壁垒,引领人工智能进入下一个发展阶段。