随着互联网的快速发展,网站安全和防护技术日益成熟,尤其是在反爬虫和反自动化访问方面,主流网站纷纷采用包括Cloudflare、DataDome、Imperva等多种先进的保护系统来防止机器人流量和恶意采集。面对这些挑战,浏览器自动化引擎的性能与隐蔽性成为破解防护机制的关键因素。浏览器引擎基准测试作为一套专业工具和方法,帮助开发者和研究人员全面评估不同浏览器自动化框架在现代网络保护环境下的表现,成为提升反检测能力和采集效率的重要利器。 浏览器引擎基准测试主要关注的是浏览器自动化引擎绕过反爬虫保护系统的成功率、资源消耗情况以及对指纹识别技术的抵抗能力。这些测试指标能有效揭示引擎在实际应用中的适用性与稳定性。例如,主流的Playwright引擎在性能和隐蔽性方面表现突出,而Selenium虽然历史悠久但在某些防护机制面前开始显得力不从心。

通过涵盖多种保护系统的综合评测,可以帮助用户选取最合适的自动化工具以实现目标需求。 现代网页防护机制对自动化访问的识别依赖多层次技术,包括IP地址异常检测、浏览器特征指纹识别、JavaScript行为分析以及reCAPTCHA等挑战验证。其中,IP地址和网络层面的代理设置尤为关键,合适的代理配置能够隐藏真实身份,降低被检测的风险。浏览器引擎基准测试中强调了代理的重要性,不同引擎对HTTP/HTTPS、SOCKS5等协议的支持情况不一,需要根据测试环境细致选择搭配的代理类型。 代理技术的发展为突破反爬虫限制提供了坚实基础。诸如Nstproxy之类的服务,凭借庞大的全球IP资源池和旋转代理设计,实现了高效、稳定的访问。

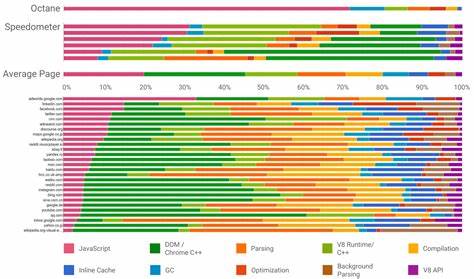

通过智能切换和多协议支持,极大提升了自动化引擎的成功率和访问速度,减少了因IP封禁带来的采集中断。代理在基准测试中的作用不仅是身份掩护,更是保证测试数据准确性的必要保障。 浏览器引擎基准测试不仅仅局限于绕过检测这一维度,更结合了性能分析,如内存占用、CPU使用率和页面加载时间等指标。低资源消耗的引擎其稳定性和扩展能力更强,适合大规模采集和自动化操作。通过对比不同引擎的性能表现,用户能够合理权衡效率和隐蔽性,以满足特定业务场景需求。 指纹抵抗能力是当前自动化浏览器引擎关注的重要方向之一。

网站通过 FingerprintJS 等开源工具采集浏览器运行环境的多项参数,组合判断访问者身份是否为机器人。浏览器引擎基准测试中,引擎对CreepJS和reCAPTCHA评分的表现成为衡量隐蔽性的关键参考。高信任分和低bot分说明引擎能有效模拟真人访问,绕过复杂验证,提升自动化行为的自然度。 值得注意的是,基准测试显示无头模式(headless)浏览器在部分环节仍容易被检测,虽然提升了运行效率,但在隐蔽性上存在隐忧。反之,有头模式虽然资源占用较高,但在反检测环境下表现更佳。由此可见,自动化策略应结合场景选择适合的运行模式。

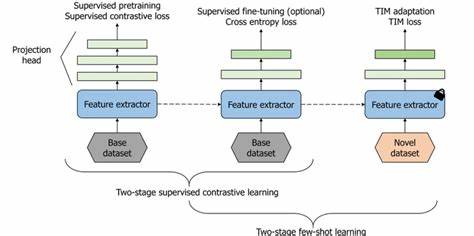

近年来,基于Playwright的衍生引擎如Camoufox、Patchright和Playwright Stealth因其灵活性和防检测能力,成为测试中的焦点。这些引擎在突破复杂反爬策略中展现了不俗的实力,实现了较高的绕过率,例如Camoufox绕过率可达83%以上,显著优于传统Selenium的不足两成。此外,针对不同浏览器内核的优化,也使这些引擎在速度和资源管理上具备竞争优势。 浏览器引擎基准测试项目的开放和模块化设计为社区贡献和扩展带来便利。开发者可以根据需求添加新的保护系统测试目标,或者实现自定义的浏览器引擎扩展,以适应更多样化和复杂的反爬虫环境。自动化报告生成和数据可视化也促使用户直观理解性能趋势,优化使用方案。

进行基准测试时,环境配置的合理性尤为关键。保证代理的干净和多样性,配置恰当的超时与重试策略,对测试结果的准确性起到决定性作用。项目文档详细介绍了如何配置环境、运行脚本、管理代理及分析输出结果,极大降低了技术入门门槛。 此外,浏览器引擎基准测试不仅适用于技术人员,也广泛服务于SEO监控、电商数据采集、市场分析等多个行业领域。随着反爬虫技术的持续升级,拥有科学的数据支撑和选择适用工具的能力,将成为数据驱动业务不可或缺的核心竞争力。 尽管基准测试展示了各种引擎各有优劣,但须强调其研究和使用前提必须合法合规,遵守相关网站的使用条款。

开发者和使用者应审慎操作,以避免侵害网站权益和法律风险。总结而言,浏览器引擎基准测试通过标准化、系统化的手段为自动化浏览器引擎在面对复杂反爬挑战时提供了详实的性能剖析和适配指南。依托先进的代理服务和多样化的测试覆盖,用户能够高效提升爬取成功率并优化资源配置。在大数据和智能化时代,掌握先进的浏览器自动化技术和防护绕过策略是数据采集与分析的技术基石。未来,随着自动化引擎与人工智能的深度融合,浏览器引擎基准测试的价值将持续提升,为安全可靠的数据采集提供坚强保障。