随着人工智能技术的飞速发展,语言模型在自然语言处理(NLP)领域扮演着越来越重要的角色。大型语言模型不仅被广泛应用于文本生成、机器翻译、自动问答等众多场景,其训练数据和训练过程也引发了学术界和业界的广泛关注。通常,虽然许多语言模型公开了其权重参数,但训练数据往往闭源且难以获取。这种情况下,如何通过模型权重近似恢复甚至推断模型的训练数据,成为近年来备受关注的新兴研究领域。 语言模型的训练数据对模型性能具有决定性影响。训练数据不仅决定了模型的知识覆盖范围,还可能暴露训练数据的隐私和版权问题。

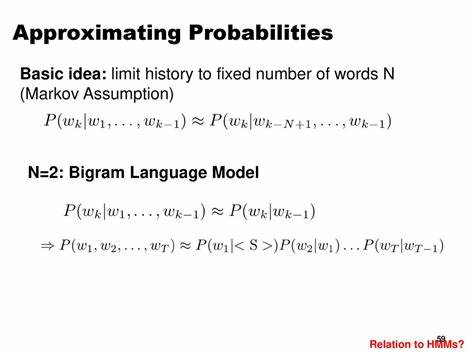

因此,理解模型权重和训练数据之间的关系对于模型解释、模型安全以及数据隐私保护均有重要价值。传统上,研究人员难以直接访问训练数据,只能通过有限的测试样本分析模型性能。而随着技术的发展,研究者开始尝试利用模型的参数信息来推测模型可能使用过的训练数据,开启了从权重反向推断训练数据的新探索。 近期一项名为《Approximating Language Model Training Data from Weights》的论文,为这一问题提供了系统的理论框架和创新的方法。论文中,作者们首次将“数据近似”问题形式化,明确了通过模型权重重建训练数据的目标和度量标准。基于这一框架,他们设计了一种基于梯度的优化策略,能够在一个庞大的公开文本语料库中选取与原始训练数据最匹配的小子集,从而实现对训练数据的有效近似。

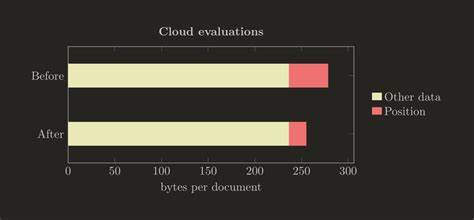

该方法的核心在于利用模型在原始训练权重和微调权重之间的梯度差异,指示哪些文本数据对模型参数的影响最大,进而筛选出最具代表性的训练样本。实验结果表明,即使在无任何真实训练数据的情况下,该方法依然能够从公开网络文档中挖掘出少量关键数据,训练出的模型性能能够接近原始模型表现。例如,在AG News文本分类任务中,随机选取的数据集只能达到约65%的分类准确率,而利用该方法筛选的训练数据则将准确率提升至80%,逼近专家手工选择数据集的88%。 此外,在针对大型语言模型的微调任务中,该技术同样展示了强大的潜力。以MSMARCO网页文档为例,微调模型的困惑度(Perplexity)由使用随机数据时的3.3显著降至2.3,而经验丰富的专家模型困惑度为2.0,这表明自动选取的数据不仅数目少且质量高,极大提升了模型表现和训练效率。 从应用层面看,这种基于权重反推训练数据的方法,既有助于模型解释性研究,揭示模型为何做出特定决策的背后依据;又为数据隐私安全提供了新的视角。

机构能够利用此技术对外发布模型权重时评估潜在数据泄露风险,强化数据保护机制。同时,研究者能够利用该方法对训练数据构成进行分析,推动公平性和偏见检测研究,确保模型不会因训练数据偏差而产生不良影响。 尽管目前该技术仍处于发展初期,面临诸如计算资源消耗大、语料库依赖程度高以及在极端微调或多任务训练下的表现尚需提升等挑战,但其创新点为语言模型研究开辟了全新方向。预计随着算法优化和硬件不断进步,未来相关技术将在自动数据恢复、模型安全审计、定制化数据生成等领域发挥更大作用。 基于权重推测训练数据的研究反映了人工智能向透明和可解释方向迈进的重要里程碑。它不仅回应了公众和监管层对数据隐私与数据溯源的关注,还支持了模型研发过程中对数据利用最大化的诉求。

从长远来看,构建一个既能保护敏感数据又支持高效模型训练的生态系统,将有效促进人工智能技术的健康发展。 总而言之,通过模型权重近似获取训练数据的方法,打破了传统训练数据不可见的局限,为理解和优化语言模型提供了强大技术支持。这不仅提升了模型性能和训练效率,还增强了模型的透明度和安全性,有望成为未来自然语言处理技术革新的重要驱动力。随着研究的深入,期待更多创新应用落地,为智能时代的数据治理和技术进步做出积极贡献。