随着人工智能技术的快速发展,语言模型作为其重要组成部分,在自然语言处理领域发挥着越来越关键的作用。无论是智能问答、文本生成还是内容推荐,语言模型都展现出卓越的语言理解和生成能力。然而,即便是最先进的语言模型,也难以避免产生"幻觉"现象 - - 即模型自信地输出错误或者不准确的信息。这种现象不仅影响了模型的可靠性,也成为人工智能更广泛应用中的一个重大挑战。理解语言模型为什么会"幻觉",对于改进模型设计、提升用户体验,以及推动AI健康发展至关重要。 语言模型幻觉的本质是什么?通俗来说,幻觉指的是语言模型在缺乏充分知识或信息的情况下,生成看似合理但事实错误的内容。

举例来说,当模型被询问某位学者的博士论文题目或者出生日期时,可能连续给出多个不正确的答案,却表现得非常自信。这种情况在很多实际应用中屡见不鲜。幻觉不仅仅是偶然的错误,而是一种系统性问题,深刻反映了训练方法、评估标准以及模型本身的限制。 从根源上讲,幻觉的产生与语言模型的训练机制密切相关。当前主流的语言模型多基于大规模的自监督学习,通过预测文本中的下一个词来学习语言规律。这种训练方式没有直接涉及真假判断,而是依赖大量文本数据中词汇和句子的统计分布。

模型并未被明确教导去区分事实的真伪,因此在面对低频事实性内容时,容易基于概率猜测生成错误答案。比如某个人的具体生日信息在训练语料中出现频率极低,模型只能通过语言模式猜测,而无法凭借真实性验证,这就导致了幻觉的产生。 此外,评估和训练目标的设计也在无形中助长了幻觉问题。现有的模型评估标准大多聚焦于准确率,以回答的正确性作为主要衡量指标。在这种激励机制下,模型倾向于"猜测"答案以争取更高的准确率分数,即使在信息不足的情况下也不愿表达不确定或拒绝回答。类似于考试中面对不会题目选择猜测而非空白回答,模型在评估中通过这种策略获得相对更好的表现。

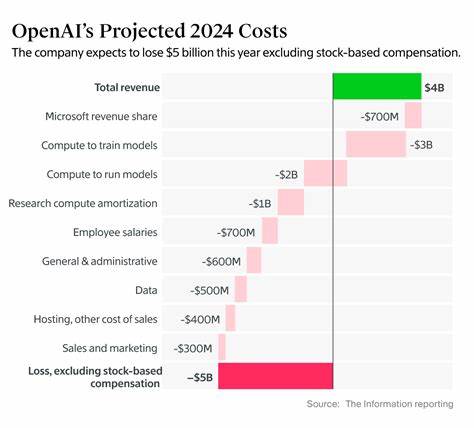

虽然这种做法短期内提升了准确率,长期来看却大幅增加了错误回答的概率,换言之,提升了幻觉的发生率。 令人感兴趣的是,有研究指出表现更好、错误率更低的模型往往是那些具有较高"谦逊度"或"自我认知能力"的模型 - - 它们愿意承认自己的无知,并选择不盲目回答。这一点从一些最新的实验数据中得到印证。以OpenAI最新发布的GPT-5为例,相较于前代模型,在保持相似或稍弱准确率的同时,错误率得到了显著降低,这得益于模型在"是否回答"这一环节上的更谨慎策略。换句话说,减少盲目猜测和增加表达不确定性的能力,是降低幻觉发生的有效路径。 那么,应该如何改善幻觉问题?首先,基础训练阶段的调整可以对幻觉率产生积极影响。

引入更多带有真实性判断标注的数据,强化监督学习环节,让模型不仅学习语言模式,更能识别真假信息,有助于减少幻觉。此外,模型训练中注重置信度和不确定性表达的机制设计也非常关键,例如在回答时可以选择"我不知道"而非"给出错误答案",从而避免错误信息的传播。 其次,模型评估体系需要进行根本性的革新。仅依靠准确率指标评判模型表现,无视错误回答与放弃回答之间的区别,将继续鼓励幻觉的发生。更合理的评价方法应当对错误答案予以更严厉的惩罚,并适当肯定模型表达不确定性的行为,给予部分积分。通过这种方式,训练目标和评估标准能够引导模型形成更健康的回答策略,从而有效控制幻觉发生。

此外,后期的模型调优和安全对齐同样不可忽视。通过人类反馈训练(RLHF)等技术,使模型在回答时更符合实际需求和伦理标准,避免产生误导性内容。同时,对模型输出进行实时检测和审查,结合知识库验证等多种手段,提升回答的可信度和准确率。 需要强调的是,语言模型的幻觉并非单纯的技术缺陷,而是深植于其统计性质和任务特性的必然产物。现实世界信息的复杂性、部分问题本质上是无解或模棱两可的,都注定模型难以做到百发百中。理解并接受这一点,有助于我们合理设定期望,转而通过合理设计和实现"谦虚"和"表达不确定性"的能力,来最大程度减少幻觉的负面影响。

总结来看,语言模型幻觉问题源于训练数据和目标设定的固有限制,模型在面对低频事实性内容时倾向于猜测以获得更高准确率,评估机制鼓励猜测而非承认不确定性,从而形成了系统性的幻觉现象。解决这一问题需要从训练数据多样化、引入真实性监督、评估标准改革以及后期对齐优化入手,建立奖励谦虚、惩罚误导的评价体系。最新模型技术已显示出减少幻觉的积极势头,但要完全根治幻觉仍需多方面共同努力。未来,随着技术的进步和理念的深化,语言模型有望实现更高水平的准确性和可靠性,更好地服务于社会和用户的需求。 。