随着人工智能技术的发展,ChatGPT等大型语言模型逐渐被应用于越来越多的领域。然而,尽管其在文字生成和语言理解方面展现了惊人的能力,但在某些专业领域,尤其是涉及精确图像生成的任务中,却存在明显的不足。特别是在绘制人体器官图示这一复杂且要求极高准确性的领域,ChatGPT表现出的能力令人失望。本文将深入探讨ChatGPT为何难以胜任这一任务,并分析背后的原因和潜在影响。 人体器官图示不仅仅是简单的图像,它们承载着丰富的医学知识,真实反映了器官之间的空间关系、生理结构和功能分布。准确的解剖图示对于医生、学生乃至普通公众理解人体结构极为重要,错误的信息甚至可能导致误解和医疗风险。

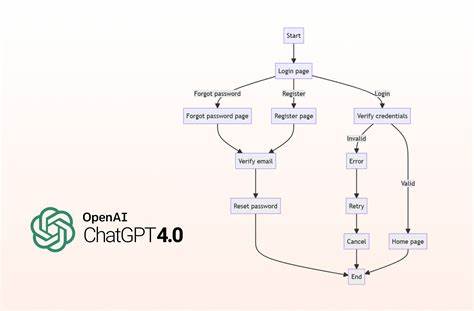

遗憾的是,ChatGPT在生成此类图示时频繁出现标注错误、结构混乱以及位置不准确等问题。这种表现并非偶发,而是一系列系统性限制导致的必然结果。 首先,ChatGPT的设计初衷是处理和生成文本信息,其核心架构基于自然语言处理技术。虽然随着多模态模型的发展,AI在生成图像领域已有提升,但ChatGPT本身并不擅长图像制作。它生成的所谓"图示"多是对文字描述的拼接和解析,而非真正的图形绘制,这直接限制了其在空间和视觉准确度上的表现。此外,语言模型基于海量文本数据训练,但这些数据中缺乏严格审核的高质量医学图像和精确的器官解剖信息,导致模型无法存储或理解复杂的视觉空间关系。

其次,人体解剖结构复杂多变,尤其是在特定生理状况下如怀孕期间,器官的位置和形态会发生显著变化。AI生成的图示往往忽略了这些动态变化。例如,很多尝试中胎儿被错误地描绘成逆位(臀位),肝脏被放置在子宫内部,甚至出现膀胱缺失、肠道位置混乱等错误。标注混乱同样严重,很多原本应该位于特定位置的标签,被随意附着在错误区域,这不仅暴露出模型对专业知识的缺乏,也反映了AI无法自主纠正空间认知的短板。 再次,生成模型存在"模式匹配"而非"理解"机制的问题。它们通过识别和复制训练数据中的模式来完成任务,却难以真正理解医学图示的实际含义和重要性。

因此,当面对涉及高精度需求的医学内容时,AI往往只能生成表面上合乎逻辑却内在错误的内容。这一点在ChatGPT制作的孕期器官图示中表现得尤为明显,即使反复优化提示词,模型依旧倾向于生成不合理的解剖结构,表明了其内在理解的不足。 除了技术层面的限制,这一现象也折射出现代社会对AI能力的误解。部分用户将生成模型视作全能的知识源,忽略了其生成内容并非经过专业审查,存在固有错误的可能。尤其是在医学和健康教育领域,错误信息的传播可能带来严重后果。缺乏医学背景的普通用户很难分辨AI生成图示的准确性,这无疑增加了错误传播的风险。

同时,也有人试图通过优化提示词或引导AI输出更准确的内容来弥补不足,但结果往往仍然令人失望。这既源于模型对负面或否定词汇的处理能力不佳,也由于语言模型对复杂三维空间结构的理解先天不足。即使借助相关医学术语和精确描述,AI仍无法真正实现解剖学图示的精准还原。 对此,我们需要从根本上认识到,现阶段的大型语言模型及其生成图像扩展技术并不适合取代专业的医学插画师或解刨学专家。医学图示的制作依赖于丰富的专业知识、严谨的科学态度以及艺术技巧,这些均难以通过目前的生成AI自动实现。 尽管如此,AI在医学领域仍有巨大潜力。

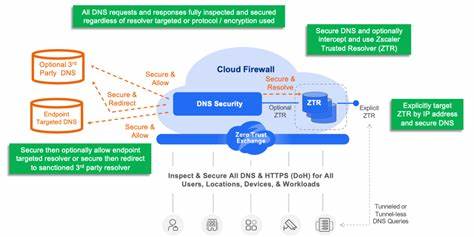

相比起生成图示,AI更适合辅助医学影像分析、数据筛查、病患信息管理等方面,尤其是在经过专业医生监督和验证的环境下,能够提升效率和准确率。未来的研究可以尝试将自然语言处理与精细的三维建模、医学影像处理技术结合,发展出更为专业和准确的辅助绘图工具,但这需要深厚的跨学科合作和整体技术的提升。 此外,针对AI生成内容的误导风险,相关机构和教育者应加强大众的媒体素养教育,帮助人们理性看待AI技术的优势及局限,避免盲目信赖。推广权威免费的医学资源,如维基百科医学版块、专业医学插画网站等,将有效减少人们因使用不准确AI图示而产生的错误认知。 总结来看,ChatGPT在绘制人体器官图示上的表现不佳,是模型架构、训练数据、功能定位及应用场景不匹配的综合体现。对于需要高度精准和专业性的医学图示创作,现有的生成式AI尚未达到所需的标准。

今后,随着AI技术的不断成熟和跨领域融合,或许能够克服这些限制,帮助医学教育和临床工作更有效地进行。但当前阶段,专业知识和人工审校仍不可替代,人们应对AI生成的医疗信息保持警惕,用审慎的态度面对其输出成果。 。