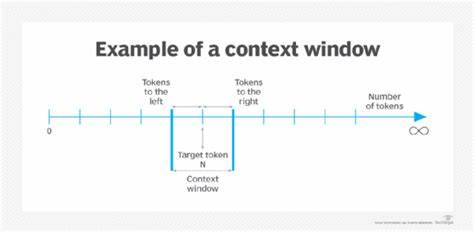

随着人工智能技术的飞速发展,尤其是在大型语言模型(LLM)领域,长上下文窗口的概念逐渐走入人们的视野。所谓长上下文窗口,指的是模型在一次调用过程中能够处理的文本输入长度,通常以令牌(token)数量衡量。近期,主流AI厂商纷纷宣布将他们的模型上下文窗口扩展到数百万令牌,甚至达到两百万令牌的规模,这使得许多人开始设想,是否只要将所有相关数据一次性提供给模型,便能够彻底解决复杂任务中的信息检索和理解难题。尽管这种思路看似简单直接,却并非万能钥匙。本文将全面探讨长上下文窗口的优势与局限,揭示在实际应用中为何仅靠扩大上下文窗口无法解决所有问题,强调信息检索与搜索技术的重要性,并展望未来人工智能发展的方向。 长上下文窗口无疑为大规模文本处理带来了便利和可能性。

对于需要整合庞大文本信息、进行综合分析与总结的应用场景,如长文档摘要、大型日志文件分析、学术论文梳理等,长上下文窗口极大提高了模型的处理能力和效率。以往分块处理文本不仅增加了人工成本,还容易产生信息割裂或遗漏,新的长上下文模型则缓解了这些痛点。然而,这样的能力提升并不等同于在所有场景下简单“扔进”所有数据即可轻松完成任务。 成本是长上下文窗口应用的首要制约因素。尽管大型模型处理上下文的能力快速增强,但模型推理的计算资源消耗和对应成本也随之攀升。举例来说,当前一些高性能的模型处理百万级令牌的成本仍高达数美元甚至更多,特别是在实时性要求较高的交互式应用中,频繁调用高成本模型不可谓不昂贵。

对于需要大量并发请求的客服系统、代码生成平台等,维持合理成本成为巨大挑战。由此可见,盲目扩大上下文窗口,带入大量冗余信息,不仅浪费计算成本,还降低了整体系统的经济效益。 延迟问题是长上下文窗口不得不面对的另一大难题。大多数基于注意力机制的语言模型,其计算时间与输入长度呈二次方增长关系,上下文长度扩大数倍,推理时延将呈指数级延长。这对用户体验尤其不利。诸如在线智能助理、编程辅助和技术支持等交互场景,用户往往期望获得秒级甚至毫秒级响应,过长的推理时间难以满足这一需求。

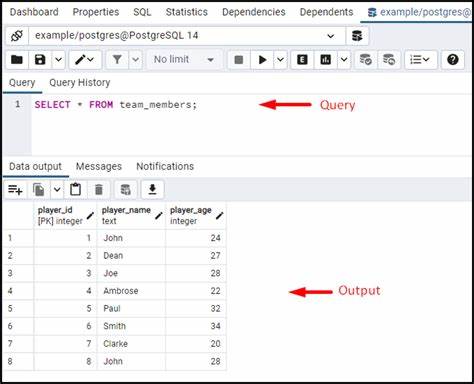

虽然模型开发商不断致力于优化模型结构与硬件加速,但推理延迟的本质限制并未完全突破。此外,长文本的处理复杂度使得模型更容易出现推理瓶颈,进一步影响平台的稳定性和响应速度。 数据规模庞大且分布稀疏的问题也使得直接利用长上下文窗口面临困境。以实际工业应用中的日志分析为例,单份日志文件可能包含数百万个令牌,涵盖大量无关紧要或重复信息。将整份日志直接输入模型,不仅带来计算压力,也因冗余信息增加了模型推理误差的风险。处理复杂度高的多步骤计算流程时,例如在多轮对话或规划执行任务中,若每一次调用都要传入庞大且杂乱的上下文信息,将使成本与延迟成倍增长,严重影响系统整体性能和用户体验。

质量表现上的挑战不容忽视。当上下文窗口中包含过多无关或相似内容时,模型的注意力机制可能“分散”,导致输出质量下降。语言模型具备高效检索特定信息的能力,但随着信息规模爆炸,找准关键细节变得更加困难。比如在代码生成中,面对多个实现风格接近但功能细微差异的代码片段,模型若缺乏精准筛选,可能输出错误或混淆的结果。这也提醒我们,简单地堆砌大量数据可能适得其反,降低最终应用的可靠性和准确率。 尽管如此,长上下文窗口在部分特定领域具备无可替代的优势。

长文档摘要、法律合同分析、多文档整合以及科研资料整理等,能够从庞大文本中高效抽取核心信息,是过去难以想象的科技进步。模型在具备足够上下文容量后,可以更全面地把握文档脉络与逻辑关系,生成更加连贯、深入的分析报告。这类应用随着上下文窗口尺度的增加,必将迎来蓬勃发展和广泛普及。 然而,信息检索与搜索技术的重要性在全局看来依然未曾削弱。因为无论上下文窗口多大,将海量数据精准过滤至最相关部分,都是提升智能系统效率的基础手段。有效的向量搜索、关键词匹配及谓词过滤技术,能够大幅缩小输入规模,确保模型仅关注真正关键的信息,避免过多冗杂数据的干扰。

由此可以降低成本、缩短延迟,并提升输出质量。未来AI应用越来越倾向于复杂的复合式系统架构,融合检索模块、规划模块及生成模块多步调用,如智能助理及自动化编程中所见。在这些多环节流程中,保持每一步输入的紧凑且高效,是实现整体性能最优化的关键。 未来人工智能的发展趋势无疑是往更智能、更高效的复合系统方向迈进。单一大模型通过极长上下文一次性解决问题的时代或许将在部分领域到来,但对于大多数多样化、复杂且交互式的实际应用而言,灵活结合信息检索、上下文管理和模块化设计依然是最现实和有效的策略。诸如RunLLM这样的前沿项目,正致力于将搜索技术与大语言模型协同优化,借助规划型智能体提升任务分解及执行能力,实现多阶段调用下成本与性能的平衡。

综上所述,长上下文窗口的扩展确实为文本理解及处理带来革命性的能力,推动人工智能触及更大规模和更复杂的问题。但它并不能替代高效的信息搜索与检索机制。过度依赖扩大上下文会引发成本激增、响应迟缓、质量波动等诸多问题。只有通过合理融合搜索技术和模型调用,设计多层次、多步骤的智能流程,才能在保证效率与效果的同时,实现真正符合实际需求的智能应用。面向未来,我们每个致力于AI技术和产品开发的实践者,都应持续完善并提升信息检索技术,精细管理上下文,并探索系统性复合解决方案,迎接智能的新纪元。