近年来,人工智能(AI)技术不断突破,尤其是在应用程序开发领域,AI驱动的代码生成工具如Replit和Lovable等应运而生,这些工具以惊人的速度和便捷性吸引着开发者和创业者。通过这类AI应用构建器,开发者们能够在极短时间内完成可运行的样品,甚至一个功能简单的原型。但是,尽管这些工具在构建内部工具和展示效果方面表现不俗,仍然存在一个不可忽视的问题 - - 代码质量欠缺,往往导致这类应用难以成为可持续发展的产品基础。AI生成的代码如果只是为了快速完成任务而牺牲了结构的合理性、可维护性和测试能力,将会带来长期的负担和风险。 首先,代码质量低下使得项目难以扩展和维护。普通的AI生成代码往往将逻辑、界面布局、样式直接混杂在同一个文件中,存在大量硬编码数值,缺少复用组件和清晰的文件分离。

这种"方便一次性完成"的写法可能在演示当天看起来完美无缺,但随着项目的推进,代码的脆弱性会逐步显现。例如,颜色和间距的硬编码会限制设计风格在多个页面间的统一性,逻辑和UI深度耦合会使得单元测试和错误排查变得异常困难。团队成员对代码的理解门槛提高,代码审查流程也会陷入瓶颈,从而阻碍产品升级和修复。 相比之下,具有良好架构设计的AI生成代码示例则展现出了截然不同的面貌。在这种代码中,样式定义、业务逻辑、UI组件各自分离成独立模块,提升了代码的可读性和可维护性。共享的主题和变量代替零散的硬编码值,使得设计决策能够全局统一调整。

函数和事件处理被解耦开来支持更完备的测试体系,国际化翻译、埋点监控等成熟的生产实践也融入代码中。这些细节无不彰显着"可持续性"的严格追求,这样的代码更接近真实团队在长期项目中的工作方式,也更符合企业实际运维需求。 为什么目前主流的AI代码生成模型尚难产出高质量、结构清晰的代码呢?原因在于训练和奖励机制的局限。大多数语言模型在学习编程时,注重的是立即的代码正确性和通过单个测试用例的能力。模型被设计成优化短期效能,比如让代码快速能跑通,解决眼前的小问题,而非考虑代码的长期维护、团队协作和架构扩展。简单来说,机器学习模型没有天然的意识去追求代码的模块化、复用性或者代码标准。

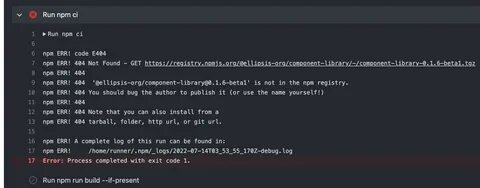

此外,模型本身的记忆容量限制,促使它倾向于将代码集中写在一个文件,减少跨文件的复杂关联,来便于应对上下文的切换。虽然这种单一文件的代码结构对模型来说更友好,但对于人类团队来说却难以合作和维护。更糟糕的是,主流的代码评测体系通常只关注"代码是否运行"、"是否通过测试用例",而不考量代码的风格规范、架构合理性和可读性。由此造成的结果是:AI产生的软件产品,在表面与短期展示上光鲜亮丽,但实际下来往往是技术负债重重的"塑料代码"。 那么,如何打破当前这一困局,实现AI代码生成的性能和代码质量的双赢呢?关键是要重新定义模型和工具的评判标准。最重要的问题是:代码是否经过精心设计,是否能让开发者在数月后依然快速理解、修改和扩展?只有量化并纳入这些"软指标",才能逐步训练和推动更符合长期软件工程原则的AI生成代码。

与此同时,AI工具必须被定位为资深开发者的辅助者,而非万能的独立撰写者。对AI代码的结构化指导、严格代码审查流程、全面测试和监控必不可少。将AI视作初级开发者,让经验丰富的工程师为其把关和引导,是缩小二者差距的必经之路。 以真实案例为例,一个由AI写就的简单订阅应用如果被仓促上线,若存在计费逻辑漏洞,最终将影响客户信任和品牌声誉。没有深刻理解代码的人无法迅速定位和修复问题,导致损害急剧扩大。这种对业务风险的放大效应进一步强调了代码质量的价值 - - 它不仅关乎代码本身,更关乎企业生命线。

展望未来,真正的AI应用构建平台将把代码质量作为核心竞争力。Woz等新兴平台正努力打造一个环境,确保生成代码遵循严格的类型安全原则,模块划分清晰,方便测试且支持多语言国际化。这样的理念是将AI与人类开发者的优势结合,打造既快速又可靠的生产级软件。真实的挑战不仅仅是让AI能快速写出有效代码,而是让代码本身具备"耐用性",成为团队可持续发展的基石。 总结来看,AI自动生成代码带来了开发效率的飞跃,但不能盲目追求表面速度和神奇效果。只有坚持高代码质量和良好架构设计的原则,才能真正把AI工具从"玩具"转变成企业级的生产利器。

随着训练模型优化、架构指导工具的普及与开发流程的完善,AI将越来越多地辅助着人类开发者,推动设计长期可维护、高度可靠的软件系统。拥抱代码质量,才是迈向稳定长久的AI应用时代的必经之路。 。