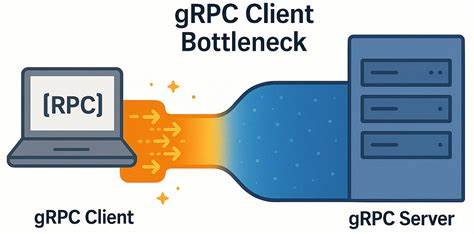

gRPC作为一种高性能、开源的远程过程调用(RPC)框架,被广泛应用于微服务通信和分布式系统中,因其基于HTTP/2协议且支持多路复用流而备受推崇。然而,即使在现代高速、低延迟的网络环境下,某些应用场景中gRPC客户端仍然会遇到无法预期的性能瓶颈,表现为吞吐量受限和客户端端响应延迟骤增。本文聚焦于这种现象背后的技术细节,结合YDB在实际生产环境中发现并解决gRPC客户端瓶颈的案例,详尽解析其产生原因及有效的规避策略,帮助开发者优化RPC通信性能。 在YDB的分布式SQL数据库系统中,gRPC承担着向客户端暴露数据库接口的核心任务。随着集群规模的缩小,团队注意到客户端请求处理能力非但没有提升,反而出现了更多资源空闲及客户端延迟持续增长的意外现象。经过系统分析,瓶颈竟然并不在服务器端或网络环境,而是隐藏在gRPC客户端的连接管理和流控机制中。

现代gRPC客户端通过多个通道(channel)与服务端通信,每个通道底层通过HTTP/2协议复用多条流,理论上能够充分利用单一TCP连接的带宽取回请求与响应。特别是在低延迟网络下,开发者往往希望单通道即可支持大量并发请求,从而简化设计并降低连接管理的复杂性。然而,gRPC实现中每条TCP连接对并发HTTP/2流数存在限制,默认最多可支持100个并发流,超过该流数的请求会进入排队状态,被延迟发送。 这一限制成为性能瓶颈的根源,尤其是在需要处理大量并发短连接请求的场景。YDB团队通过自研的微基准测试工具,以最简问答式RPC调用模拟真实负载,清晰地勾勒出单连接模式下吞吐量随并发请求(in-flight)增长呈现非线性增长趋势,且客户端延迟快速增加。大量请求排队等待实际发送,消耗了宝贵的时间资源。

测试结果显示,尽管单个请求延迟十分接近网络物理延迟,但整体吞吐并未能线性扩展,表明客户端处理存在瓶颈。通过抓包分析,发现客户端发送请求和收到响应间多出超过150微秒的空隙,定位到客户端gRPC内部对请求调度及流复用存在的阻塞。 由于gRPC默认会复用通道参数相同的连接,即使创建了多个gRPC通道,如果参数一致,底层仍然共享同一TCP连接,因此无法通过简单多通道扩展突破HTTP/2并发流限制。YDB团队尝试了在每个工作线程创建独立通道的方案,但通道参数未区分仍旧导致所有通道共用同一连接。 最终,解决方案是为每个通道设置独立的参数,避免连接复用,并启用GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL(本地子通道池)配置项,从根本上打破连接共享的限制。这样,每个通道都拥有独立的TCP连接,允许同时维持更多并发请求,不再受HTTP/2单连接流数限制的影响。

实验表明,启用多连接和本地通道池后,吞吐量在相同并发度条件下提升近6倍,客户端延迟增长速度大幅减缓,表现优异且更趋线性扩展。这对低延迟、高吞吐量的服务场景尤其重要,如金融交易、实时数据处理和分布式数据库访问等。 值得注意的是,在网络延迟相对较高(如5毫秒)的环境下,多连接带来的性能提升不再明显,因网络本身成为主要延时来源,客户端瓶颈权重下降。这也提示开发者应根据具体网络条件合理设计RPC连接策略。 除了通道管理,YDB团队在服务器端也采用了优化措施,如将工作线程PIN定向同一个NUMA节点,减少跨节点硬件访问延迟,进一步保证服务器处理效率。 客户端性能瓶颈的发现和解决,也反映出gRPC虽然在设计上具备高扩展性和灵活性,但实际应用中存在隐藏细节可能严重影响性能。

合理配置通道参数、避免连接共享陷阱、调整并发请求规模,是保障高性能gRPC应用的基础。 开发者在构建分布式系统和微服务通信时,应警惕gRPC默认行为背后的限制。过度依赖单一连接复用和忽视内部流配额,容易导致难以察觉的性能瓶颈,使系统达不到预期。与此同时,应用端合理的资源调度及隔离,结合网络测量准确评估延迟和带宽,能够助力诊断和突破瓶颈。 未来,gRPC社区亦在持续改进连接复用模型和流控机制,提升多通道协作能力,缩短客户端请求延迟。开发者可关注版本更新及官方性能最佳实践,结合自身业务需求灵活调优参数配置,最大程度发挥网络环境优势。

总结来看,gRPC客户端在低延迟环境中的性能瓶颈主要源于单连接的HTTP/2流数限制及连接复用策略不当。通过为每个工作线程独立创建带有不同参数的gRPC通道,并启用本地子通道池功能,能够有效打破瓶颈,显著提升系统吞吐量和降低响应延迟。本文所述经验为基于gRPC的分布式数据库及微服务架构提供实用的性能优化思路。期待更多开发者参与讨论与改进,共享最佳实践,共同推动gRPC生态更加高效稳定的发展。