人工智能语音助手正逐步渗透到生活的方方面面,从智能手机、智能家居控制到办公助理,它们通过语音交互为用户提供便捷服务。然而,传统的AI语音助手普遍依赖云端服务器来完成复杂的语言处理任务,这带来了一系列隐私、安全及使用成本的担忧。针对这些痛点,Evelyn作为一个本地优先的AI语音助手原型脱颖而出,展现了AI应用可以勇敢脱离云端,回归本地计算的创新愿景。 Evelyn的诞生源于开发者Ted在经历了一段重大手术康复期后的思考与实践。出于对现有云端AI助手依赖性和高昂成本的担忧,他设想打造一款能够完全在用户本地运行的智能助手。虽然Ted并非职业程序员,仅凭五个月不断学习和试错完成了这一多功能的早期原型,展现了个人开发者在AI领域探索的巨大潜能。

Evelyn目前的实现环境主要依托于macOS系统,其中包括Mac Mini M4 Pro和MacBook Pro M1等设备。选择这些强大且性能稳定的硬件平台,使得本地运行复杂的AI模型成为可能,也验证了现代硬件对于智能助手本地部署的支持。 在核心技术上,Evelyn集成了若干开源及商业工具,形成了独特的本地智能语音交互架构。转录方面,它采用了OpenAI的Whisper模型,保证了音频到文本转换的高准确率和实时性,从而提升了用户体验。为了生成自然且流畅的语音回复,Evelyn设计了多重发声引擎的降级策略,优先使用XTTS作为首选生成工具,在其性能不足时自动切换到ElevenLabs,再次失效则fallback为macOS自带的文本转语音系统,这种多层次机制保障了语音回复的稳定输出。 语言理解与生成环节则通过本地部署的开源大型语言模型(LLM)实现。

借助LM Studio,Evelyn能够访问多款本地化的语言模型,避免了一切数据上传到云端的风险。除此之外,项目中还包含一个简易的记忆模块,采用JSON格式存储对话上下文、去重与回忆功能,使得用户在多次交互后AI能够保持较为连贯和有用的对话状态,增强了助手的智能性和实用性。 此外,Evelyn设有一个基本的查询路由器模块,能够在多个本地模型与外部云模型之间切换处理请求。虽然主要追求本地运行,但在语义理解更复杂或资源不足时,将部分请求委派到云端,实现本地与云端的协作,达到性能与隐私之间的平衡。这种混合架构反映出当前AI助手发展的实际挑战与创新解决思路。 Ted在开源社区分享了他的探索过程,并上传了演示视频,让更多人了解本地优先AI助手的实现可能及体验差异。

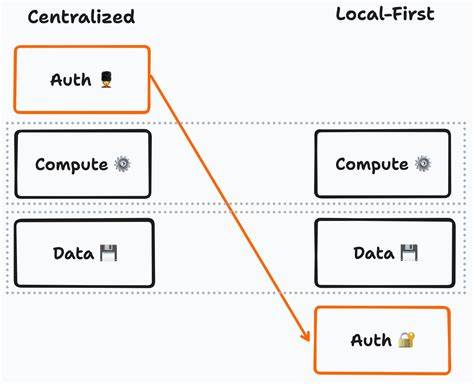

尽管项目尚处于早期阶段,功能尚不完善,但其开创性尝试和实践意义不容忽视。它不仅展示了个人开发者如何利用开源技术打造高阶智能产品,也激发了对本地智能助手未来潜力的深入思考。 对于行业来说,Evelyn的出现再次唤醒了对AI助手架构的反思。云端解决方案固然强大且便捷,但隐私泄露风险、网络依赖和使用费用问题困扰着大量用户和企业。试图将AI运行环境下沉至本地,将算法本身纳入用户控制范围,是未来AI助理发展的理想方向之一。尤其是在数据安全法规日益严格的背景下,Local-First(本地优先)设计理念具备更强的法律合规优势和用户信任潜力。

从技术角度看,实现一款完整本地运行的AI语音助手仍面临诸多挑战。硬件资源消耗、模型优化、自然语言理解的多样性与复杂性,都需要持续研发和创新。Evelyn通过在macOS平台的试验,积累了宝贵的经验。它结合了开源转录技术、多个语音合成引擎和本地化大语言模型的优势,在性能和功能平衡上取得了一定成果。 对于普通用户和开发者而言,Evelyn的实践也暗示了未来智能助手应用更自由开放的形态。相比依赖巨型云端服务,用户能够部署属于自己的AI助手,真正实现数据所有权、隐私保护及定制功能的个性化。

透过社区合作,开源代码的进一步释出与优化,类似Evelyn的项目有望逐步走向成熟,形成可供普通用户易用的产品级体验。 对未来的发展,Ted期待更多业内专家和爱好者能给予建议,如技术选型上有哪些改进空间,如何简化项目以便推广,以及本地优先AI助理在市场上的潜力和竞争态势。与此同时,他也视Evelyn为一个探索实验平台,继续在实际使用中不断完善系统性能及用户交互体验。 总的来说,Evelyn代表了人工智能领域一次勇敢的技术革新尝试。它不仅对传统云端依赖的AI助理提出了另类方案,也促进了隐私保护与技术普惠的价值传播。随着硬件性能提升及算法日益高效,本地优先的AI语音助手未来将有可能成为主流,为用户带来更安全、更灵活、更个性化的智能服务体验。

对于关心AI发展趋势的人士来说,Evelyn的探索之旅无疑值得关注和期待,它既是技术突破的里程碑,也是未来智能交互形态的重要风向标。 。