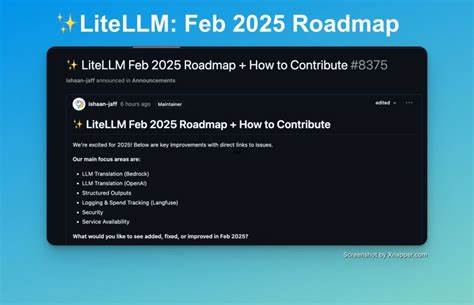

在软件开发领域,如何客观地评估代码质量和工程团队的健康状况一直是一个复杂且具有挑战性的课题。传统方法往往依赖于人工审核和主观评价,既耗时又存在偏颇。随着人工智能技术的快速发展,尤其是编程智能代理的崛起,我们迎来了将编程经验和代码质量量化测量的新可能。Armin Ronacher近期对智能代理在软件开发中的应用进行了深刻反思,他指出这种测量能力为开发者带来了前所未有的洞察力和改进空间。 早期开发者面对复杂的工具和不完善的文档时,常常只能透露一句“RTFM”(读说明书),但实际上这很可能是徒劳的,因为说明文档的不完整或错误随处可见。工程师们习惯性地归咎于“用户错误”或“技能问题”,无形中掩盖了工具和API设计本身的问题。

这种做法显然无法真正解决根源,不利于软件生态的健康发展。智能代理的出现打破了这一局面,它们可以自动尝试调用接口、编写代码甚至调试,通过观察自身与代码和工具的互动反馈来判别其中的问题和优缺点。 智能代理能够像一个不知疲倦且不带偏见的评价者,持续衡量代码的多方面表现,反映出项目的实际健康状态。更为关键的是,这种测量是高速且可重复的,远远超越了手动测试或人类审查的效率。开发团队此前需要投入大量人力引导新人熟悉代码库、验证第三方库或新技术的适应性,而智能代理可以直接从零开始尝试使用这些工具,通过失败率、错误提示、执行速度等多个维度,快速反馈技术方案的可行性和稳定性。 在选择编程语言、库或工具链时,智能代理的评估为决策提供了直接数据。

单纯依赖人工经验往往带有主观偏好,甚至流行趋势可能误导技术选型。而智能代理能够客观地给出哪些语言或库在实际任务中表现最佳的证据,从而减少决策的盲目性和风险。同时它们也能反映出生态系统的稳定程度。现今许多流行生态频繁迭代,API变化快,文档和示例常常滞后,导致人类开发者和代理都难以快速适应。智能代理的反馈量化了这一困境,敦促社区在维护稳定性和升级节奏上做出更合理的权衡。 良好的测试覆盖率被认为是衡量代码健康的重要标准。

它不仅为未来功能扩展提供安全保障,更能帮助智能代理准确理解各种函数和行为的预期结果。优秀的测试和示例代码像点亮夜路的灯,指引代理理清代码逻辑,避免盲目试探带来的效率浪费。此外,错误报告机制的完善与否在智能代理的体验中尤为关键。隐藏在深层日志中的错误信息不仅人类难以发现,智能代理也无法追踪定位,导致问题定位效率骤降。清楚直观的错误反馈同样促进了代码和工具的快速迭代和优化。 生态系统中的多余抽象是另一个智能代理指向的痛点。

过度复杂的层级结构使数据流通和重构变得艰难,也让代理在尝试适配时陷入困境。例如,设计臃肿的ORM层就被认为增加了工作量而非帮助,这种情况通过代理的使用体验变得更加明显。简洁明了的架构既有利于团队理解维护,也提升了代理等自动化工具的执行效率。 用户友好和响应速度同样不能被忽视。智能代理欣赏简洁高效的环境,响应快捷、失败率低的工具能帮助它们保持高效作业。相反,频繁崩溃或运行缓慢的环境不仅降低代理的执行频率,也加重了开发者的心理负担。

比如在Python生态中,虽然pip作为包管理器无处不在,但代理更喜欢uv这种响应迅速且能返回明确信息的工具,实用性和体验决定了工具的受宠程度。 搭建良好的开发环境对于促进智能代理工作同样至关重要。一旦复杂的环境只能在持续集成(CI)中重现,智能代理就失去了本地快速验证的便利,这种体验上的壁垒抹杀了自动化评估的潜力。配备类似Docker的容器环境,为代理模拟完整的后台服务和数据库提供了绝佳支持,使之能在本地直接操作、调试,而非依赖碍事的模拟数据或不可控的远程环境。还有一点是确保环境和代码错误易于区分,避免代理陷入无谓的重复尝试。 技术领域固有的一些不良惯性和历史遗留问题仍导致大量软件和工具在客观指标上表现一般或偏差,但因各种原因依然占据主导地位。

智能代理的引入让这些问题更加透明,也为推动合理调整提供了切实依据。不论是技术选型,还是自主开发组件,团队可以通过代理反馈把握真实的开发体验和代码质量,实现精准定位和改进。 更深层次看,智能代理对代码质量的评价不仅映射了机器的适应性,也直接反映了人类开发者的体验。代理的挫败感如同人类开发者的困境,双方需求往往高度一致。对于任何想打造良好工程文化和开发体验的组织来说,拥抱由代理驱动的量化评估,将有助于清晰认识自身软肋,科学改进流程和技术选型。 智能代理对编程生态的作用远超简单代码生成或自动化编程,其量化测量功能为描述抽象的“代码可用性”和“团队健康”带来客观标准。

它们拒绝情绪化偏见,提供可重复、数据驱动的洞察,极大提升了开发效率和决策质量。通过拥抱这一技术趋势,软件行业有望走向更透明、健康和高效的未来。Armin Ronacher对自己亲身经历的总结,以及他代理助手对Xcode工具的挫败感的“量化表达”,无疑是这一变革最生动的注脚。