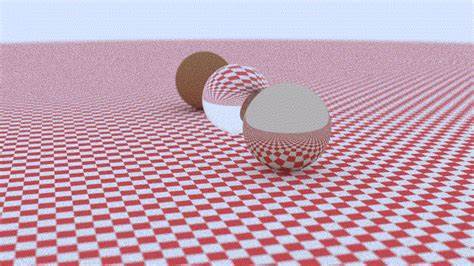

随着实时光线追踪技术的兴起,NVIDIA的RTX系列GPU备受关注,其硬件级的光线追踪加速单元(RT Cores)在处理三角形几何体时发挥了极强的性能优势。然而,近期一位开发者通过深入CUDA编程和GPU性能优化,成功实现了一个纯CUDA光线追踪器,其性能竟然能够达到甚至超过RTX基于Vulkan的实现的两倍。这一突破不仅挑战了常规认知,也为深入理解GPU架构和着色器优化带来了新的启示。本文将详细剖析这段CUDA光线追踪之旅,揭示其中的核心优化技巧,帮助读者理解如何在GPU上充分发挥计算能力,从而获得更高效的实时渲染效果。 传统RTX光线追踪依赖于硬件RT Core加速三角形BVH遍历,大幅降低了光线与复杂网格的碰撞检测时间。虽然这一点在现代游戏和复杂场景中表现优异,但在处理程序化几何体——如球体和轴对齐包围盒(AABB)时,却可能存在性能瓶颈。

原因在于RT Core被专门设计为优化三角形的遍历和交叉测试,但程序化几何的计算代价较低,导致计算单元(CUDA Cores)资源被浪费于简单的计算,RT Core却承担着复杂的BVH遍历,形成瓶颈。这种架构上的设计偏差使得某些程序化光线追踪甚至在启用RTX硬件加速后并不比纯计算单元并行处理更快。 而纯CUDA实现绕过了硬件RT Core,直接用计算单元执行整条光线追踪流程,包含BVH遍历和光线-几何体交叉测试,以“内联光线追踪”(inline ray tracing)的方式将所有计算集中于一条GPU线程中完成,最大程度地减少数据在不同着色器阶段间的传输和内存访问开销。实际测试显示,这种设计在处理仅由程序化球体组成的场景时,帧时间从RTX Vulkan实现的30毫秒降至约8毫秒,渲染速度翻倍并在某些条件下甚至超过三倍。 CUDA程序在GPU上运行拥有极大的灵活性,但同时也面临诸多陷阱。首先,递归调用是CUDA编程中的性能杀手。

每层递归都会消耗更多寄存器资源,导致寄存器溢出并转入较慢的本地内存。此外,递归通常伴随着分支和分叉,破坏了SIMT(单指令多线程)架构的并行效率。通过将递归改写为显式栈的迭代遍历,可以在寄存器中重用内存,有效降低寄存器压力,减少寄存器溢出,并提升线程并行度,实现显著的性能提升和更稳定的运行。 其次,代码内联对于CUDA性能至关重要。由于CUDA设备函数编译和链接机制限制,只有将所有设备代码写入头文件,实现完全的头文件内联,编译器才能将相关函数内联入主渲染内核,极大减少函数调用的开销以及寄存器溢出。此举在项目中曾让复杂设备函数由数百寄存器的大开销降至几十寄存器内运行,降低了寄存器压力,提升了硬件占用率和指令吞吐。

此外,数据结构设计对性能的影响不可忽视。传统面向对象的继承和虚函数调用虽然代码优雅,扩展性好,但极大地破坏了GPU核心的内存访问连续性,导致指针跳跃和缓存未命中。采用结构体数组(Structure of Arrays,SoA)重构数据,扁平化数组连续存储所有几何对象和BVH节点的属性,消除虚表指针与动态分派的开销,有效提高缓存利用率,减少全局内存访问延迟。此结构使得GPU在内核执行时能够进展高效的内存预取和线程访问一致。此外,通过将节点属性对齐为16字节(如将三个float的vec3通过增加填充提升为vec4对齐),能确保CUDA访存操作能使用更高速的向量访存指令,进一步减少内存请求次数和分裂。 计算代码中的数学函数也有细节之分。

标准C++库中的max、min以及fma函数在CUDA设备代码中往往会因条件语句和额外判断带来性能损失。相反,使用CUDA和CUDA支持的intrinsics函数如fmaxf、fminf、fmaf,能够被底层生成优化为单指令多周期的浮点融合指令,既降低指令数,又减少分支,提升整体执行效率。该做法在光线与AABB盒的碰撞检测中使得每帧的执行时间减少了近三分之一。 随机数生成是光线追踪中不可缺少的部分,原生curand库虽统计质量高,但其运行时状态和复杂度对于GPU线程极为不友好,导致寄存器消耗大、执行效率低。替换为轻量的线性同余法(LCG)加上PCG散列函数的“自制”随机数生成器,使得每个线程仅需极少变量,无需全局状态占用,显著降低寄存器负载和代码复杂度,提升采样效率,改善整体渲染速度和资源利用率。 在材质处理上,经典实现往往通过分支或多态区分不同材质类型,从而带来巨大的warp分支发散。

通过将所有材质的采样逻辑统一为无分支计算路径,将所有贡献权重进行归一化混合,大幅减少分支,保证了线程间更高的执行一致性和硬件吞吐率。同时,无分支材质混合支持复杂材质叠加,提升了灵活性和表现力。 使用CUDA现有的内存层级来合理布局数据,也带来明显收益。将所有每帧只读且线程间共享的参数置入__constant__内存,利用其对所有线程广播访问的特性,减少每线程寄存器传递和内存带宽需求,提升内核执行效率,相较传统参数传递方式减少寄存器消耗,提高了占用率和执行速度。 最后,为了减少CPU与GPU间的内存拷贝开销,利用CUDA与OpenGL的OpenGL互操作技术,渲染结果直接写入由OpenGL管理的纹理对象,避免了昂贵的CPU内存阶段,从而实现了低延迟的画面更新。此优化对于实时渲染体验提升尤为关键。

综合以上优化,结合性能分析工具如Nsight Compute的具体指标,最终实现了720p分辨率每帧约8毫秒的渲染时间,比传统RTX Vulkan实现的平均30多毫秒提升超过两倍。GPU指令流水且无过多内存阻塞,寄存器溢出和线程发散得到有效控制,带来了近乎极限的执行效率。所有代码及优化细节均开放在GitHub,方便社区学习和交流。 当然,这套CUDA光线追踪目前仍以程序化球体为主,尚未支持复杂三角形网格及完全硬件RT核心优势发挥的场景。未来发展方向包括三角形几何的支持,基于TinyBVH等快速构建库,采用波前路径追踪(Wavefront Path Tracing)架构以克服深层递归及分支瓶颈,同时探索利用OptiX等高级API进一步兼容RTX硬件加速。无论如何,此次CUDA优化征程不仅在性能上创造了奇迹,也开启了对现代GPU架构本质更深刻的理解,展示了精细底层程序设计在实时渲染中的巨大潜力。

对于图形程序员、GPU爱好者,尤其是希望突破硬件限制、亲手打造高性能渲染引擎的开发者来说,这是一条值得借鉴的道路。它证明了即便没有依赖专用硬件,纯计算单元的巧妙调度、复杂控制流的管理和高效内存组织同样能够实现卓越的光线追踪性能。掌握GPU底层原理与调优技巧,结合细致的性能分析和工具辅助,才能在现代图形编程领域占据先机,推动下一代视觉技术的发展。