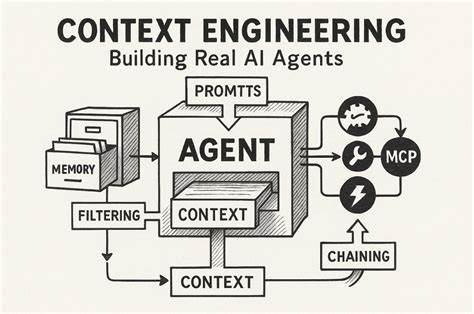

随着人工智能技术的快速发展,基于大语言模型(LLM)的智能代理逐渐成为推动智能应用落地的核心力量。如何有效构建和优化这些智能代理的上下文,成为提升其性能与实用性的关键。然而,尽管强大的模型为代理智能提供了丰富的能力,仅靠模型本身并不足以完成复杂的、多步骤的任务。上下文工程由此应运而生,成为链接模型推理能力与实际应用需求的桥梁。本文围绕人工智能代理中的上下文工程展开,结合近年来在Manus项目中的实践经验,探讨设计技巧、面临的挑战及未来趋势,帮助相关从业者构建更高效、稳健的智能代理系统。 早期自然语言处理任务依赖于模型的端到端训练和微调流程。

以BERT为代表的预训练模型虽然获得了泛化能力,但每次迁移新任务均需耗费大量时间进行微调和评估,这种周期往往令人望而却步,尤其在产品市场匹配(PMF)早期,快速迭代反馈极为重要。随着GPT-3和Flan-T5等具备强大上下文学习能力的模型出现,在上下文中引导模型无需重新训练便能执行新任务成为可能,极大地改变了构建智能代理的范式。 Manus团队基于对过去失败经验的深刻反思,选择聚焦上下文工程,而非开发端到端模型架构。这种策略使得功能改进可在数小时内完成,远快于以往数周甚至数月的迭代周期。更重要的是,上下文工程赋予产品对底层模型演进的高度适应性,即使基础模型升级,整体架构依然能够灵活“漂浮”在能力的“潮水”上,而非被限制在固定的“支柱”中。 然而,上下文工程绝非简单复制粘贴模板,它是一门实验性极强的技术科学,要求持续试验、微调甚至进行复杂的结构搜索。

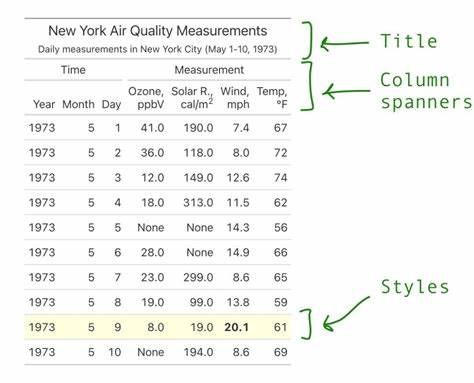

在Manus研发过程中,团队多次重构智能代理框架,通过大量经验积累,形象地称之为“随机梯度下降”,虽然方式不见得优雅,却有效驱动了上下文设计不断趋于更优。 其中,设计符合KV缓存机制是提升性能和降低推理成本的关键所在。代理系统在执行任务时通常经历多轮交互,每轮产生相应的动作和环境观察,这些历史内容组成的上下文不断增长,与后续的输出相比呈现严重的不对称关系,往往是百倍以上的输入输出比例。KV缓存能够复用相同的上下文前缀,极大地减少时间开销和资源消耗。实际案例显示,利用缓存的Token推理成本可比未缓存时降低十倍以上。因此,在上下文构建时,务必确保前缀保持稳定不变,避免在系统提示开头插入动态内容(例如精确到秒的时间戳),防止破坏KV缓存。

此外,上下文的追加应严格遵循不可变原则,禁止修改先前记录的动作或观察,同时采用确定性序列化方法,防止JSON等数据结构的键排序不稳定对缓存命中造成影响。 在管理工具调用空间时,动态增删工具的尝试初见成效,但实际应用中发现频繁变动严重影响缓存,并且会引发模型对工具状态的混淆,导致动作选择错误。Manus采用基于上下文状态机的策略,通过对动作解码过程中的token logits进行屏蔽控制,实现有条件地激活或禁止特定工具的调用。这样既保留完整工具集的定义,避免缓存失效,又能保证动作空间在当前上下文中合理约束。实现这一点需要调用所支持机制的响应预填充技术,结合统一的动作命名规则,保证模型在执行动作时具备稳定一致的语义标识。 面对现实世界中庞大且多样的数据交互,模型上下文窗口虽逐渐扩展至十几万tokens,但远不足以承载所有中间观察和长期记忆。

过长的上下文不仅会导致模型性能下降,还大幅增加计算资源消耗。传统的上下文截断和压缩不可避免导致信息遗失,从而影响智能体的决策连贯性。Manus创新性地将文件系统视作其“外部上下文”,允许智能体主动将中间状态、网页内容等写入文件,按需读取,形成一个无限扩展的持久化存储空间。这种设计不仅避免了长上下文负担,还保证了信息可恢复,不至于因过度压缩而永久丢失关键数据。未来若能在此基础上借助状态空间模型(SSM)等新型架构,实现非全注意力机制的外部记忆访问,将为智能代理带来更优的速度和效率。 在复杂多步骤任务执行中,智能体尤为容易陷入注意力分散或遗忘早期目标的困境。

Manus通过构建并不断更新一个任务待办清单(todo.md),将核心目标以自然语言形式不断“重新朗诵”到上下文尾部。这种技巧巧妙地操作了模型注意力分布,强化了对全局计划的关注,避免任务执行中的“信息迷失”现象,有效提升了多步决策的稳定性。 错误和失败在智能代理操作中时常出现。很多尝试倾向于隐藏或清理错误信息,期望保持上下文的整洁和“完美”,但Manus实践证明,保留失败行动和错误反馈能够让模型在后续决策中自行调整概率分布,降低犯同类错误的可能性。换言之,错误的显式保留是智能体真正体现“学习”和“适应”能力的体现。在真实环境下,容错与错误恢复能力是衡量智能代理成熟程度的重要指标,对应的研究和评测尚有待加强。

另一个常见且容易被忽视的问题是“少样本示例”引发的行为模式固化。语言模型善于模仿上下文示例的行为,因此示例集过于同质化,将导致模型固守狭窄路径,缺乏多样性和灵活性。Manus通过引入结构化的变化,如调整序列格式、变换措辞、轻微扰动内容顺序,打破示例行为的刻板模式,提高模型在重复任务间的广度与鲁棒性。这种对上下文多样性的管理,是防止智能体陷入重复路径和幻觉的有效手段。 总体来看,上下文工程作为智能代理系统的核心环节,承担着连接底层模型能力与实际智能行为之间的纽带。尽管当前模型在性能和能力上不断突破,但合理的上下文设计依然是决定智能体响应速度、任务成功率和可扩展性的根本因素。

Manus团队通过反复迭代、实战检验积累了宝贵经验,并希望这些原则与方法能为更多智能代理开发者提供借鉴,缩短试错周期,加速智能体落地应用。 在未来,随着模型规模的持续扩大和推理机制的演进,上下文工程将结合更加灵活的存储系统、高效的内存访问手段以及精巧的注意力操控策略,推动智能代理进入更为智能和高效的阶段。只有踏实做好每一段上下文,才能让人工智能代理在人类生活和工作中发挥更大价值。面对智能体的无限可能,上下文工程是那条不可或缺的基石,值得肩负重任的开发者们持续深耕探索。