随着人工智能技术的飞速发展,语音交互系统正在变得愈发普及和重要。基于语音的实时对话AI不仅提升了用户体验,更为各种应用场景提供了极大的便利。OpenAI的实时API作为目前领先的AI接口之一,能够为开发者带来强大的实时语音交互能力。本文将深入介绍如何使用Rust语言实现OpenAI的实时API,打造一个高效、稳定且跨平台的实时语音交互应用。 Rust因其安全性、高性能以及现代化的编程体验,在系统开发领域获得了广泛认可。将Rust应用于实现OpenAI实时API,可以充分利用其性能优势和并发处理能力,满足语音流数据的高频率传输与处理需求。

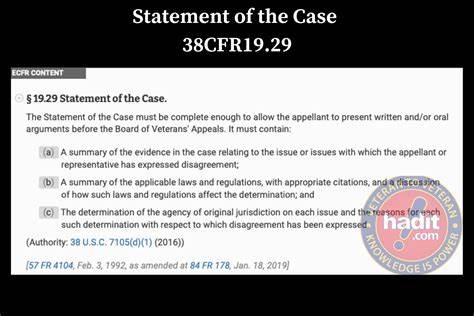

此外,Rust生态中的相关音频处理库与WebSocket支持,使得整个开发过程更加顺畅可靠。 实现一个基于Rust的OpenAI实时API应用,核心在于建立稳定的WebSocket连接,实现双向实时音频流的传输,并对接语音检测与播放机制。项目通常包括多个关键模块:音频输入采集模块负责从麦克风获取音频,采用CPAL(跨平台音频库)处理不同操作系统的设备兼容;音频输出模块管理播放AI反馈的语音;WebSocket模块维护与OpenAI服务的实时通信;音频转换模块确保采样率的自动适配,通常标准化到24kHz以满足API要求。 自动语音检测(VAD)是实时语音交互的核心。Rust实现中,VAD逻辑通常由服务器端完成,客户端只需负责音频数据及时传输,确保在用户停止讲话后准确触发AI响应。TurnDetection结构体中可设置灵敏度、前缀预留时间和静默检测参数,提升对话的自然流畅性与交互体验。

在开发流程上,首先需要拥有支持OpenAI实时API访问权限的API密钥,配合Rust 1.70及以上版本的编译器。通过Git克隆项目代码库,配置.env文件存放密钥后,借助Cargo指令运行程序,便可启动完整上行与下行音频通道。程序启动时会自动检测并显示使用的音频输入输出设备,保证跨平台兼容性,涵盖Windows、macOS与Linux系统。 实时语音数据通过WebSocket持续传输到OpenAI的后端处理,AI模型基于音频和文本混合输入进行推理,随后返回音频流和转录文本。整个过程实现了无缝、低延迟的语音双向交流,支持用户自然对话体验。应用内置对话缓存与缓冲机制,保障长时间持续交互时音频数据的完整和稳定播放,无需担心响应中断或延迟。

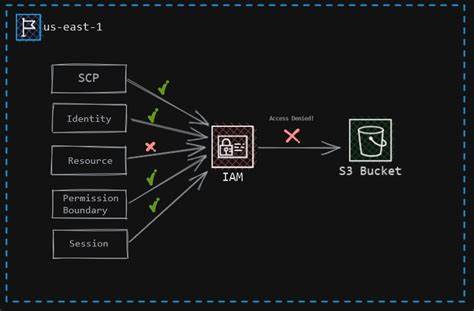

在实际使用中,开发者还需关注诸多细节。例如音频设备权限管理,尤其是在macOS和Windows系统上的安全策略限制;避免音频反馈环路的设计,推荐使用耳机以降低回声风险;以及根据用户硬件性能调节音频采样率和处理负载,确保流畅体验。 功能性上,项目支持多种AI声音选项,用户可以根据需求选择包括Alloy、Echo、Fable等不同音色,增加对话的个性化和趣味性。对话指令配置灵活,允许开发者预编写指令引导AI回复风格,满足多样化场景需求,例如客服助理、教学辅导或智能家居控制。 从架构设计角度看,模块划分清晰且层次分明。音频流经采集、重采样、编码后注入WebSocket连接,而返回的音频流经过解码与重采样,最终驱动扬声器播放。

两条流线路实现严格同步,确保对话的实时性和连贯性。此外,无界限缓冲队列的设计在处理长时间响应时尤为关键,避免因容量限制导致音讯丢失。 针对开发者常见问题,项目提供详细排查建议。包括API密钥授权异常可能导致403错误,网络连接不稳引发的断线问题,以及音频设备未能正确识别或权限被阻止时的解决方案。跨平台开发时还需考虑系统各异的声音接口实现,如PulseAudio与ALSA在Linux系统的适配。 OpenAI实时API配合Rust语言的融合,不仅展现了现代软件开发的高效与灵活,更为实时AI语音交互树立了新的标杆。

该实现为学习和研究提供了极佳示范,易于扩展与定制,开发者可基于此框架,结合业务需求不断迭代,构建专业级的智能语音应用。 总结而言,利用Rust语言实现OpenAI实时API是一项兼具挑战与机遇的现代工程实践。它涵盖了音频底层采集处理、异步网络通信、多线程并发编程及AI模型交互等多方面知识。通过此次技术的深入融合,可以极大提升语音交互系统的响应效率与交互体验。期待未来有更多开发者基于此框架,激发创新潜能,推动智能语音技术迈向更广阔的应用前景。 。