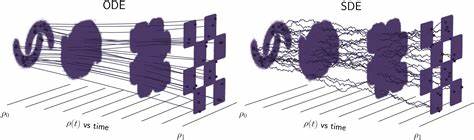

随着人工智能技术的飞速发展,语音交互已经成为人机界面中不可或缺的重要环节。延迟流建模(Delayed Streams Modeling,简称DSM)作为一种创新方法,正在彻底改变传统的语音识别和语音合成技术。Kyutai实验室基于这一理念,推出了领先的Kyutai语音识别(STT,Speech-To-Text)和语音合成(TTS,Text-To-Speech)模型,兼具实时性与精确度,满足了当今多样化应用的需求。延迟流建模技术的核心在于打破传统序列到序列(sequence-to-sequence)模型在流式处理中的时延瓶颈,通过合理设计延迟机制,使模型既能保证输出的连贯性,又能实现高效的流式处理。简单来说,DSM为实时音频数据到文本或者文本到声音的转换提供了更加流畅和性能均衡的解决方案。Kyutai的两大旗舰产品,语音识别系统和语音合成系统,均基于这一模型架构,分别面向不同的应用场景,在性能和实用性上达到了行业领先水平。

Kyutai语音识别模型以其丰富的参数规模和不同的延迟配置,适应了从多语言支持到高精度需求的广泛场景。1亿参数的英法双语模型拥有半秒的低延迟与智能语音活动检测(VAD)功能,可以灵敏识别语音的起止,极大地优化了语音交互体验。与此同时,26亿参数的纯英语模型虽然延迟增加至2.5秒,却在语义理解和复杂环境下的识别表现上更为出色。该系统采用分块音频处理设计,能够有效支持流式推理,实现边说边转写,而无需等待完整语音结束。除此之外,Kyutai STT支持高并发批处理优势,凭借先进硬件如NVIDIA H100显卡,一次可同时处理数百个语音流,满足大规模语音服务的需求。在实际应用中,这种批量处理与低延迟结合的能力,使得实时语音助手、会议转录、在线教育等场景得以流畅实现。

用户不仅能获得准确的文字结果,还能够体验到紧贴语音节奏的实时反馈,提升交互自然度。与此相辅相成的是Kyutai的语音合成技术。基于相似的模型架构,Kyutai TTS致力于输出高度自然、流畅且富有情感的合成语音,支持多种实现方式以适应开发与生产环境。研究人员和开发者可以利用PyTorch版本进行深入调试和二次开发,灵活探索语音合成的各种可能性。生产环境则可选择基于Rust的服务器版本,以稳定高效的websocket流式服务形式运行,满足工业级实时语音合成需求。此外,得益于苹果MLX框架的支持,Kyutai TTS也可在iPhone和Mac设备上实现轻量级本地推理,极大降低了对云端服务的依赖,提升了用户隐私保护与响应速度。

值得一提的是,Kyutai语音技术链条中设计了精细的语音时间点标注功能。通过返回词级时间戳,系统不仅提供了文本转写结果,同时也为后续分析、字幕制作及交互设计提供了精确的时间参考。这一功能对实时字幕生成、声音与视频同步以及多模态交互场景尤为关键。技术实现上,Kyutai团队采用跨语言技术栈,包括Python主导的研究代码、Rust语言驱动的生产后台以及Jupyter Notebook支持的数据探索,这种多语言融合确保了研发的高效性和系统的稳定性。除此之外,Kyutai还提供完善的开发工具链和预提交配置,极大方便了社区和企业用户的快速集成。开源策略和灵活许可方式也促使该技术生态快速壮大,使开发者能在MIT和Apache许可条款下安心自由地使用和定制。

展望未来,延迟流建模有望广泛应用于游戏语音交互、智能家居助手、多语言在线翻译以及辅助医疗等关键领域。通过不断优化模型结构和硬件适配,Kyutai的STT和TTS方案将进一步推动语音AI的实时交互水平,突破传统语音识别合成延迟和准确率的限制。与此同时,结合语义VAD与大规模并发处理,Kyutai技术为构建更加智能、高效且人性化的语音应用奠定了坚实基础。总而言之,延迟流建模作为一个创新范式,赋能Kyutai语音识别与合成模型在实时性、准确性和多样化实现层面实现平衡与突破。Kyutai的产品不仅展示了技术的前沿性能表现,也通过多平台、多语言的全面覆盖,满足了学术研究和商业生产的多重需求。未来随着智能设备的普及和语音交互场景的不断丰富,基于延迟流建模的Kyutai STT和TTS无疑将成为推动语音AI技术发展的重要驱动力,助力实现真正自然流畅的人机语音交流体验。

。