随着计算技术的飞速进步,传统内存架构面临诸多瓶颈,无法满足现代数据密集型应用的需求。尤其是在人工智能训练、云原生应用和大规模分布式系统中,内存资源的充分利用与高效调度成为亟待解决的问题。远程内存(Far Memory)作为一种创新的内存扩展和管理思路,正逐渐走入业界视野,带来对内存层级结构以及资源调度的新一轮思考和变革。 远程内存的核心理念是突破本地硬件内存的限制,通过软件定义和分布式技术,实现跨机器、跨节点的内存共享与弹性扩展。它将传统的内存层次结构从仅局限于本地缓存和内存,拓展到更远端的内存空间,甚至可以利用其他机器中待用的内存资源,形成一个统一且动态调整的内存池。这样的设计不仅有效提升了内存的资源利用率,还赋予应用程序更大的弹性,避免因本地内存不足而导致的内存溢出或性能瓶颈。

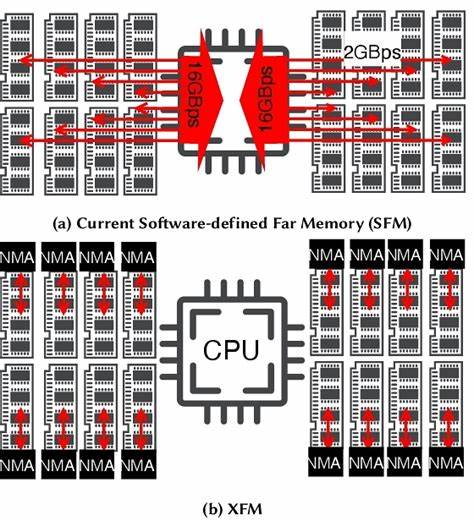

从技术实现角度来看,远程内存并非单一技术,而是多种技术的融合。它包含了软件层面上的优化方案,如基于操作系统交换空间(swap)的内存压缩、垃圾回收、应用线程调度机制的调整;也包含了硬件层面的支持,比如高速网络技术(Infiniband、RoCE)、远程直接内存存取(RDMA)以及硬件加密和校验机制。这些技术协调配合,确保了数据在远程节点间的快速传输、访问一致性和系统整体的稳定性。 具体来说,学术界和工业界推出的多项前沿研究充分展示了远程内存的潜力。比如Lagar-Cavilla团队提出的软件定义远程内存方案,利用本地Linux交换机制优化冷数据的内存压缩,延缓了热点内存的压力。而Gu等人则探索了基于Infiniband网络的远程交换方案,在硬件层面对冷页进行预测性迁移,提升内存利用率。

Dragojević等人的FaRM系统则结合了远程事务性内存和RDMA,实现了具备分布式锁机制的远程内存访问,确保跨节点操作的原子性。而Ruan团队提出的AIFM架构则在软件运行环境层面深入调整,让应用程序线程灵活切换等待,降低远程内存访问的阻塞和延迟。 这些方案各有侧重,但共同目标是应对现代大规模仓库级计算机中普遍存在的内存资源利用率低、硬件部署成本高及系统复杂性增加的挑战。企业级机房和云计算平台中,许多服务器的内存利用率常年保持在40%至60%之间,造成大量内存资源空闲而得不到有效利用。与此同时,服务实例之间互相隔离的资源管理模型(如容器化的Pod资源分配)加剧了内存的碎片化和浪费,导致部分应用出现内存不足(OOM)却无法借用其他服务空闲资源的尴尬局面。 远程内存提出的解决办法是构建一个跨机器共享的内存“流体基质”,让程序不再拘泥于本地物理内存,而是通过统一且智能的运行时系统,动态调度和移动内存数据。

应用程序代码依然保持原有编写方式,但底层运行时会根据内存冷热状态和访问模式,将“冷”数据压缩后迁移至远程节点,热数据则保留在本地快速访问。系统随需应变,支持内存的自动扩展和弹性溢出,极大降低因内存不均衡分配带来的性能下降和错误风险。 这一理念与传统的内存层级结构形成鲜明对比。以往内存体系往往分为高速缓存(cache)、主内存(RAM)、闪存以及存储设备等多级,数据在各级存储介质之间迁移。远程内存则引入了更为丰富的层级,“远端内存”成为其中不可或缺的一环。它既不像硬盘缓存那样慢,也不完全依赖本地物理内存,能够灵活利用网络联通的其他计算资源,形成一个弹性拓展的内存阶梯。

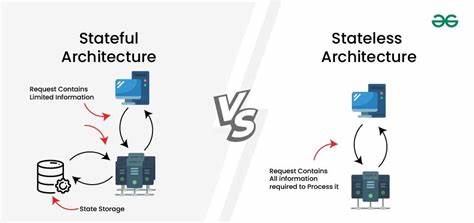

从应用开发的角度看,远程内存倡导构建“分布式单体(Distributed Monolith)”的设计思想。这里的“单体”并不是简单地回归传统的紧密耦合架构,而是强调通过统一的运行时跨越边界,实现共享内存的抽象与使用。这样开发者无需关注服务划分和资源隔离的细节,代码逻辑专注于业务功能,运行时负责调度和优化资源分配。通过引入类似Erlang的语言运行时特性,如高效的调度器、轻量级线程(green threads),以及透明的节点间通信机制,远程内存应用能够更自然地实现跨机器内存访问和状态共享。 在实际场景中,这种技术的优势尤为显著。例如,一个Python web应用中,当访问量激增时,传统系统往往因为数据库和应用服务器内存不足出现崩溃。

借助远程内存,应用的查询和缓存部分数据可以自动迁移至远程内存节点,减少本地内存压力,并通过调度机制优化任务执行位置。这不仅提升了应用的鲁棒性,也有效避免了因流量波动带来的资源浪费和服务中断。 然而,远程内存的实现并非没有挑战。最大的技术瓶颈在于数据访问的延迟和通信开销。操作系统传统的交换机制以页为单位搬移数据,然而跨节点网络连接的延时和带宽限制使得4KB页粒度的滑动访问会引发性能急剧下降。对象级访问不对齐、频繁的指针跳转导致大量无用数据也被调入,形成显著的读放大效应。

此外,远程内存需要处理内存地址映射、页表同步、数据加密与完整性校验等问题,这些均带来额外的系统开销。 对比过去的NUMA架构,远程内存的网络访问延迟和成本更高,要求更精细的内存布局和访问预判。当前主流研究和实践尝试通过内存压缩、冷热数据分层管理、异步线程切换等方法缓解这些困难。未来,随着网络技术的进一步发展,尤其是高速低延迟网络的普及,远程内存的性能瓶颈有望逐步破解,实现真正的跨节点内存弹性调度。 远程内存的发展不仅仅是技术升级,更是在理念上的一次革新。它重构了内存作为计算资源的分布与管理方式,将单机孤岛转变为协同共享的动态资源池。

对人工智能训练的大规模集群、容器云平台及复杂的分布式计算应用来说,远程内存帮助打破了以往硬件资源边界,实现更高效的成本利用和弹性扩展。 总的来看,远程内存作为未来大规模计算体系中的关键技术路径,正在逐渐从理论和实验走向实际应用。它既依托硬件创新,也依赖软件层的深度协作,推动计算资源的极致利用。面对不断增长的数据处理需求和多变的应用场景,拥有灵活、智能且可扩展的内存管理能力,已经成为现代计算基础架构不可或缺的重要组成。因此,理解远程内存的原理与实践,以及积极探索适应其的应用设计,是迈向未来计算新时代的关键一步。