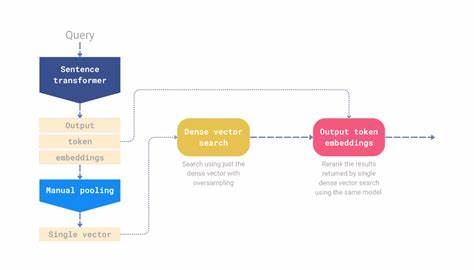

随着大数据时代的到来,信息检索技术日益重要,尤其是在自然语言处理和搜索引擎领域,如何更精准、更快速地匹配用户查询与海量文档成为关键。传统基于单一固定维度向量的检索方式虽简洁高效,但难以捕捉文本中微妙的词义差异,限制了搜索质量。FastPlaid作为一款基于Rust语言构建的最新开源多向量搜索引擎,采用每词(Per-Token)晚期交互(Late Interaction)机制,成功弥补了这一不足,实现了分词级别的精细对齐和高性能检索,是当前多向量密集搜索领域的重要进展之一。FastPlaid的设计理念根植于对机器学习模型特别是语义检索模型特性的深刻理解,传统向量检索通常将文档或查询编码成单一向量,整体匹配忽略了每个词的具体语义贡献,特别是在长文本或复杂表达中,这种粗糙的匹配容易造成相关性降低。而FastPlaid借鉴了ColBERT与ColPali模型的多向量表示方式,将文档和查询拆分为若干词向量,逐词计算相似度,并在检索后期实行融合评分,称之为晚期交互。这样做不仅能更有效捕捉细粒度的语义差异,还能避免早期交互中计算复杂度激增的问题。

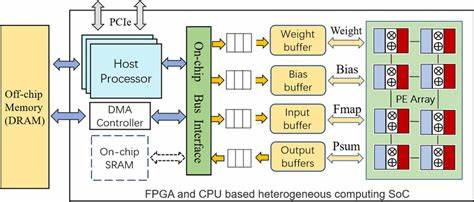

FastPlaid的核心优势还在于其高性能架构。项目采用Rust语言开发,充分利用Rust的内存安全和并发优势,配合GPU计算优化,确保在大规模数据上依然能保持快速响应和高吞吐。与原版PLAID引擎相比,FastPlaid在多个公开数据集上展示了多倍速的查询性能提升,尤其是通过去除JIT编译延迟,实现了稳定一致的首次运行表现。使用FastPlaid非常方便,用户只需通过Python接口即可完成索引的创建与查询操作,支持处理数千至数十万条文档的每词多向量嵌入。索引构建依赖k-means聚类算法,将大量词向量有效分组,提升搜索时召回率与效率。查询时,FastPlaid根据指定的检索参数执行倒排文件探测与精排得分,平衡速度与准确度。

值得注意的是,FastPlaid索引是不可变的,不支持增删改操作,若需更新数据必须重新构建索引。这样的设计降低了系统复杂度,便于保持检索性能稳定。性能方面,FastPlaid在诸如Arguana、FiQA、NFCorpus、Quora等多个主流检索数据集测试中表现优异,能够达到与原版模型相当的NDCG@10精度,同时索引构建时间和查询每秒数均有显著提升,部分场景下加速超过五倍。这使得FastPlaid非常适合实时性要求较高且数据规模巨大的应用场景,如智能搜索引擎、问答系统、法律文档检索以及学术论文搜索等。FastPlaid适配了各种硬件环境,既支持高性能GPU加速,也兼容CPU执行,为开发者提供灵活的部署方案。此外,其支持多GPU自动并行处理,极大提升了分布式检索能力。

作为一个活跃的开源项目,FastPlaid不仅代码质量高,还附带全面文档和示例,方便用户快速上手。开发社区持续推动功能完善和性能优化,未来还计划增加动态索引更新和更多模型支持。总结来看,FastPlaid代表了多向量语义检索的前沿方向。通过结合Rust的高效性与每词晚期交互技术,极大提升了信息检索的粒度与效率。对于从事大规模文本检索、智能问答或相关领域的工程师和研究人员,FastPlaid提供了一个强大、可扩展且实用的工具选择。持续关注并合理应用该引擎,可以显著改善搜索系统的用户体验和业务价值。

。