近年来,人工智能技术特别是大型语言模型(LLM)的崛起,对各行各业产生了深远影响。学术出版领域也无法置身事外,一项由美国与德国研究团队合作完成的研究,通过对超过1500万篇生物医学领域论文摘要的深入分析,揭示了人工智能技术在科学论文写作中的广泛渗透。这项发表于《Science Advances》杂志的研究,不仅展现了AI语言模型在学术写作领域的实际应用情况,也引发了对学术诚信与研究质量的新一轮讨论。 自2022年底ChatGPT等先进语言模型推出以来,这些工具因其近似人类的写作能力迅速在全球范围内流行,尤其吸引了科研人员借助其提升写作效率和质量。但是,同时也带来了学术界对于“作者身份”和“原创性”的担忧。研究人员面临的一个重要问题是,如何识别哪些论文部分是由人工智能生成或辅助完成,从而保护科学成果的严谨性和透明度。

为了规避传统AI文本检测存在的模型偏差,这项研究创新性地采用了“前后对比分析”方法——对比ChatGPT发布前后的论文词汇使用变化。通过对关键词的频率升降进行统计,研究发现自AI语言模型普及以来,科学文献中的“风格词汇”使用显著增加,诸如“showcasing”“pivotal”“grappling”等具有明显人工智能风格的词汇频率激增。同时,2024年论文中过度使用动词和形容词的现象愈发突出,相比此前以名词为主的学术写作风格,呈现出更加“流畅”和“修饰性强”的表达特点。 统计数据显示,十三点五个百分点的2024年发表的科研文章,很大程度上经历了AI工具的文字加工。这一数字揭示了人工智能在科学交流领域的渗透速度及普及程度,也显示研究者对AI协助写作持更加开放乃至依赖的态度。 不同学科、国家和期刊对AI辅助写作的接受度存在较大差异。

生命科学领域尤其是生物医药领域,往往在论文写作中更早期地反映出AI写作风格。而在其他社会科学和工程技术领域,这一趋势略显滞后。地理分布上,欧美发达国家科研机构利用AI工具的程度普遍较高,而发展中国家尚处于适应和初步尝试阶段。 这一发现引发了对学术伦理的广泛关注。尽管AI的确为学术写作带来效率和表达水平的提升,但学术界同时担忧过度依赖可能削弱原创思考及独立分析能力。AI生成内容的准确性、来源透明度以及潜在误导问题也成为审稿环节亟需解决的难题。

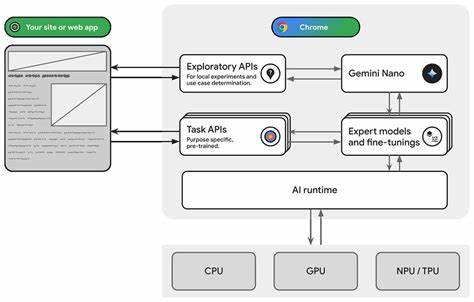

研究团队通过详细词汇和语法风格的对比,提出了基于语言特征的“AI指纹”识别方法,这为未来学术出版界鉴定AI成分提供了新的技术手段。 对学术期刊编辑部来说,如何制定合理的AI使用规范,平衡技术创新与学术诚信,是摆在面前的难题。一方面需要鼓励利用新工具提高写作质量与传播效率,另一方面也必须加强对内容原创性的审查,防止“AI作家”的泛滥导致学术水准下降。 此外,随着人工智能文本生成技术不断进步,简单的词汇频次分析可能不足以捕捉复杂的AI创作痕迹。未来研究需要结合机器学习和自然语言处理技术,发展更精准的检测系统。同时,人工智能研究领域应加强模型透明度和责任机制,促进AI工具在学术写作中的规范化运用。

从学术研究者的角度,掌握AI辅助写作工具的合理使用方法,既是提升工作效率的重要途径,也是维持学术诚信的自律要求。正确引导创新技术服务于科研成果的传播,有助于推动全球知识共享与科学进步。 整体而言,这项研究引发了学术界对于人工智能写作介入的新视野,既警醒了人工智能泛滥可能带来的风险,也展现了技术变革在推动学术传播现代化中的巨大潜力。未来如何在便利与规范之间找到平衡,将是所有科研工作者、编辑出版机构和政策制定者共同面对的重大课题。