随着互联网技术的迅速发展,系统间的异步通信需求日益增长。传统的消息队列系统如Kafka和RabbitMQ虽然功能强大,但环境复杂、维护成本高,使得开发者们寻求更简洁轻量的解决方案。HTTP Feeds作为一种基于HTTP的事件轮询最低限度规范,正是在这样的背景下诞生,为异步事件流传输和数据复制提供了全新的思路。HTTP Feeds采用了统一的CloudEvents格式,通过简单的HTTP GET请求实现事件的拉取和订阅,降低了技术门槛,适合多种应用场景。HTTP Feeds的核心是一个HTTP GET端点,客户端通过调用该端点获取按时间顺序排列的事件批次。返回的事件组采用标准的CloudEvents批量JSON格式,即application/cloudevents-batch+json,确保了事件数据在不同系统间的兼容性和通用性。

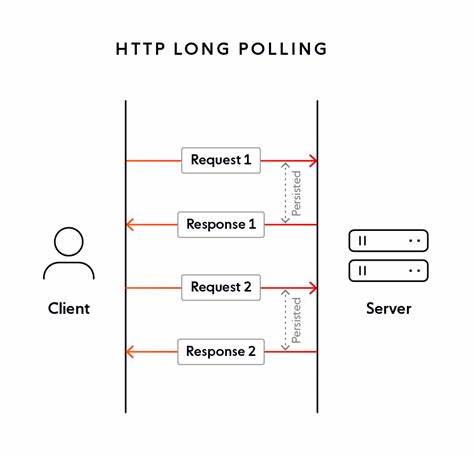

客户端可以通过lastEventId参数指定上一个已处理事件的ID,从而实现对事件流的连续消费,此机制支持无限轮询,确保实时数据同步。通过该参数,客户端能够准确地“滚动”至事件流中的最新位置,避免重复处理。HTTP Feeds的设计简洁明了,但支持多种轮询方式,其中包括简单的轮询和长轮询。简单轮询中,客户端持续循环调用服务端接口,若接口返回空数组,则说明暂时没有新事件,客户端等待一段时间后再次请求。该模式实现容易,适用于事件量较小或实时性要求中等的场景。相比之下,长轮询则更为高效。

通过timeout参数,客户端告知服务端最长等待时间。若无新事件,服务端将保持连接直至超时或有事件产生再返回响应。长轮询极大地降低了延迟,提升了实时感,但对服务器的并发连接数提出了更高要求。HTTP Feeds不仅能够传递单一类型事件,常见应用还涵盖了不同事件类型于同一端点,形成围绕特定业务领域的事件流。若将事件流视作可变数据集合的快照,HTTP Feeds还能充当“聚合视图”,将实体对象(aggregate)及其变更全量地推送到订阅方,支持本地读模型的构建及近实时的数据同步。维护事件流大小和效率的关键在于压缩(compaction)和删除机制。

由于每个实体的更新都会插入新事件,事件流会不断膨胀,对新订阅者和存储造成压力。通过合并或删除重复或过时的事件,系统能保持事件流的精简与高可用性。尤其在满足法规需求时,某些实体可能因合规风险需彻底删除,此时服务器会发布带有特定method字段的DELETE事件,指示客户系统相应移除本地存储数据。HTTP Feeds采用CloudEvents标准的属性字段,如specversion、id、type、source、time和subject,确保事件结构统一且便于跨平台适配。事件ID的设计通常基于严格排序策略,以支持顺序查询。UUIDv6、数据库序列号等都是常见的实现参与者,确保事件顺序和稳定性。

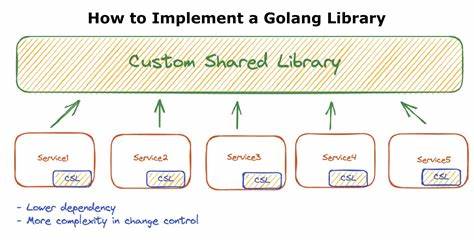

安全性方面,HTTP Feeds支持多种HTTP身份验证方案,包括Basic和Bearer认证。服务端还可能根据身份过滤事件内容,虽影响缓存策略,但极大提升了数据访问的灵活性和安全尺度。在性能优化方面,HTTP Feeds服务器能通过事件通知机制、变更数据捕获触发器以及高频数据库轮询来确保事件及时推送,降低轮询延迟。另一方面,长连接带来的服务器资源压力需要合理容量规划及连接管理机制支持。HTTP Feeds不仅适合事件驱动架构中异步消息传递的场景,也为数据复制、本地缓存更新及跨系统事件广播提供便捷手段。对于不希望引入额外消息中间件的组织,HTTP Feeds简化了架构设计,同时仍实现了可靠的事件传输和系统解耦。

社区内已有多个开源实现和示例项目,如基于Spring Boot的服务器端框架与AWS无服务器示例等,为开发者快速入门和定制带来便利。HTTP Feeds这一规范的出现,展示了在现代分布式系统中,充分利用HTTP协议及现有Web标准实现高效事件轮询的可能性。它为开发者提供了一个简单、可扩展且通用的事件订阅解决方案,帮助不同系统实现低延迟、高一致性的异步数据同步和互动。面对快速变化的业务需求和云原生应用的兴起,HTTP Feeds凭借其灵活性、轻量性和标准化优势,有望成为连接异构系统的重要桥梁,促进系统间的松耦合协同和数据一致性。总之,HTTP Feeds是一种结合了现代事件驱动理念与经典HTTP通信优势的强大工具,它将进一步推动技术社区对于无代理消息传递模式的探索和实践,为未来构建更简单高效的分布式系统奠定基础。