随着人工智能技术的迅猛发展,语言模型(LLM)在各类应用中的广泛应用已经成为推动数字化变革的重要力量。然而,LLM的集成不仅带来了功能的丰富,也引发了对使用成本和管理效率的关注。为了帮助开发者更加清晰地了解和控制语言模型的使用情况,微软最新推出了Dev Proxy v0.28版本,该版本引入了显著的创新点,如LLM使用量和成本追踪插件OpenAITelemetryPlugin、本地AI运行时Foundry Local的集成支持以及针对.NET Aspire框架的专属扩展,旨在提升开发者体验和应用性能,同时实现开源工具的灵活拓展。Dev Proxy作为一款桥接开发者与各种语言模型服务的轻量级代理工具,其核心作用在于简化跨平台、多模型环境下的API调用管理和模拟测试。此次更新不仅在功能上大幅增强,更高度关注可视化和成本效益,为构建智能应用提供可靠保障。新版本中最引人瞩目的功能是OpenAITelemetryPlugin。

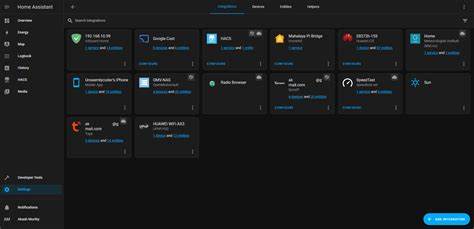

这一插件能够自动拦截应用中发起的LLM请求,详细记录所使用的模型种类以及令牌数量(包括提示词、完成部分及总计),并结合当前模型的定价信息,实时估算每次请求产生的成本。凭借此插件,开发者可以直观分析各模型调用的使用频率和费用分布,进而做出更合理的调用策略,从而有效控制AI使用预算。OpenAITelemetryPlugin的数据可通过专业的可视化解决方案如OpenLIT或.NET Aspire的开放遥测(Open Telemetry)仪表盘展示,为团队协作提供数据支持,也便于产品经理和财务人员洞察AI成本结构,实现透明管理。除此之外,Dev Proxy v0.28对OpenAI兼容负载进行了显著扩展,支持多种新的完成类型请求,满足多样化AI场景需求。针对API开发领域,TypeSpec文件的生成逻辑进行了优化,尤其是PATCH操作支持的完善,使API定义更加精确符合TypeSpec 1.0标准。此外,配置文件全面支持JSONC格式,允许开发者在配置中写入注释,极大提升配置共享和维护的便利性。

并发请求时的日志处理问题也得到解决,日志信息更为集中且条理清晰,方便排查异常与调试过程。为了降低云服务依赖带来的成本压力和提升开发效率,Dev Proxy实现了与微软Foundry Local的本地AI运行时集成。通过配置本地模型如“Phi-4-mini-instruct-generic-gpu”,开发者不仅能享受高性能响应体验,同时能够在脱网环境完成开发和测试,这为企业在数据安全及合规方面提供新选择。预计未来版本将进一步强化该本地集成能力,将Foundry Local作为默认的语言模型方案,使得本地AI解决方案更加普及。在生态系统支持方面,Dev Proxy为.NET Aspire应用提供了预览版扩展,通过极简编码接口实现快速集成。配合Docker容器的灵活部署,团队成员可以轻松共享开发环境,保证应用一致性和便捷维护。

并且,CRUD API插件的跨域请求(CORS)及JSON响应机制也得到了增强,进一步完善了前端与后端的数据交互体验。此次更新也做出了两处破坏性变更,首先是移除了过时的GraphConnectorNotificationPlugin,响应微软团队应用中关于Graph连接器的使用退潮;其次,调整了devproxy的JWT创建命令中参数名称,将单数“–audience”改为复数“–audiences”,以准确体现多受众支持,提升命令行工具的易用性与表达一致性。Dev Proxy Toolkit作为配合主程序使用的Visual Studio Code扩展工具也迎来了0.24.0版本升级,新增发现URL功能并同步引入OpenAITelemetryPlugin相关的配置片段和命令,进一步简化配置文件的编写,提高开发效率。整体来看,Dev Proxy v0.28不仅是对语言模型调用管理工具的功能完善,更是打造了一个支持成本洞察、本地化开发及多平台灵活应用的综合方案。它帮助开发者在AI时代更好地掌控技术资源,优化应用性能,且有效降低开发与运营的财务风险。随着开源社区的活跃及微软对Foundry Local的持续投入,Dev Proxy生态无疑将成为推动AI应用落地的关键基础设施。

未来,随着版本不断迭代与创新功能诞生,期待Dev Proxy为更多开发者带来更加高效、智能和经济的语言模型集成体验。对于关注AI开发成本管理和本地部署技术的企业与开发者而言,迅速掌握并应用Dev Proxy v0.28的新特性,将极大提升项目的执行力和竞争优势。