随着人工智能技术的迅猛发展,语音克隆逐渐成为数字内容创作领域的重要工具。尤其是在短视频平台上,诸如全栈彼得这样的账号,通过语音克隆技术将不同角色的声音巧妙结合,向观众呈现生动有趣的编程教学视频,吸引了大量关注。语音克隆短视频不仅提升了内容的趣味性和专业性,也为创作者带来了更高的效率和创作自由度。本文将深入解读语音克隆技术的工作原理,分析全栈彼得等账号如何制作这类优质内容,并探讨可行的技术路径和工具选择,助力有志于此的创作者了解并应用这一前沿技术。语音克隆是指通过机器学习算法,将特定人物的声音特征提取出来,生成与其声音高度相似的语音合成内容。通常需要大量高质量的语音样本作为训练数据,深度神经网络通过对声音的频谱、语调、语速等多维特征进行拟合,实现对目标声音的精准模拟。

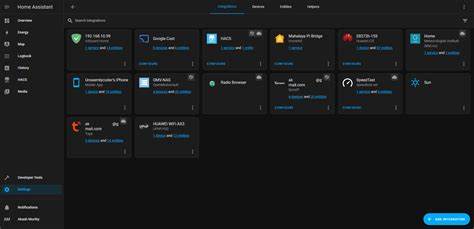

近年来,随着深度学习模型的优化及算力的提升,语音克隆技术的自然度和稳定性大大增强,已经能够生成几乎难以辨认真假声音的合成内容。全栈彼得等账号的声音表现往往是多角色配音,如彼得和斯图威两个经典动画角色。他们通过虚拟合成声音,让教学内容更具故事性和亲和力,吸引用户停留和互动。在制作过程中,首先需要采集足够的目标人物声音原始素材,这些素材必须清晰且覆盖多种语音场景,以便模型更全面地学习声音特性。采集完成后,利用先进的语音克隆平台进行模型训练,常见的选择包括ElevenLabs、Respeecher、Replica Studios等。这些平台提供了不同程度的自定义功能,可以调整声音的情绪、语气甚至口音,满足内容呈现的丰富需求。

关于ElevenLabs,这是一款目前市场上广受欢迎的语音合成工具,因其出色的音质和使用便捷性备受推崇。它支持快速训练并生成高保真度的语音内容,适合各类创作者进行声音克隆。ElevenLabs的付费模式相对合理,许多中小型创作者可以负担得起,但在大批量视频制作时,费用可能成倍增长,因此需要根据具体需求权衡成本与效果。此外,对于语音克隆的技术实现,还可以选择开源方案,如基于Tacotron2或VITS的深度学习模型。这些开源模型需要较强的技术背景和硬件支持,但能够完全控制训练过程和合成效果,避免对第三方平台的依赖,并且长期来看有助于降低成本。全栈彼得的短视频创作流程大致包括几个关键环节。

内容策划阶段通过脚本编写确定所需配音文本和角色分配。然后通过语音采集或调用语音克隆模型生成对应角色的合成语音。音频与视频画面进行同步编辑,调整角色对白节奏,使整体视频流畅自然。最后上传至社交平台并进行推广和互动。值得一提的是,语音合成的质量不仅仅取决于模型本身,还受录音设备、音频预处理方法以及后期混音技术影响。为了避免“机械感”或不自然的停顿,优秀的创作者往往结合人工后期调节,对声音进行细致打磨。

此外,最近几年,语音克隆技术的法律和伦理问题也逐渐受到关注。未经授权复制和仿制他人声音可能引发版权与隐私风险。负责任的内容生产者应确保声音权属合法,并在内容发布时明确说明使用了合成技术,以维护行业健康发展。除了全栈彼得,市场上也涌现出大量针对特定语言和文化背景的语音克隆账号。例如面向印度受众的全栈拉朱,利用本地语言和口音,将复杂技术知识以亲切方式传播。这表明语音克隆技术具备强大适应性,能够跨文化满足个性化内容需求。

将来的语音克隆将不仅限于简单的声音复制,还能融入更加多样化的情绪表达和交互体验。借助自然语言处理和情感识别技术,虚拟角色将在教学、娱乐甚至心理辅导等领域发挥更大价值。对于希望涉足语音克隆短视频的创作者,具备基础的编程知识和音视频编辑技能是重要的起点。掌握Python和深度学习库,了解文本转语音技术原理,结合市场主流的语音合成平台,能够快速搭建起属于自己的语音克隆工具链。同时,也建议关注技术社区和开源项目,不断学习和探索新兴算法与应用场景。总的来说,语音克隆短视频已经成为内容创作的创新利器,极大丰富了表达方式和用户体验。

全栈彼得等账号的成功,正是利用先进技术与创意融合的典范。未来随着技术门槛的降低和工具的普及,更多创作者将能够灵活运用语音克隆,打造个性化且高质量的数字视频内容。掌握并善用语音克隆技术,将在数字内容创新的浪潮中占据先机,开启无限可能。