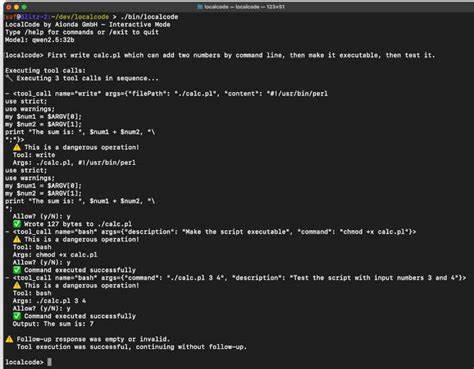

LocalCode是一个令人耳目一新的项目:一个以Perl为主、面向本地运行模型的AI代码代理,专注于在离线环境中为开发者提供自动生成和管理代码的能力。它并非云端黑箱服务,而是一个透明、可审计、工具链式的代理框架,能够与本地运行的Ollama模型交互,执行文件读写、命令执行、网页检索等操作,同时在执行"危险"操作时主动请求用户授权。这种本地优先的设计满足了对隐私和代码所有权高度敏感的场景,是对当下以云为主AI工具生态的重要补充。LocalCode的核心思想是用少量代码和明确的工具接口把语言模型变成一个可控、有追踪能力的编码助手,从而把AI的创作能力嵌入到日常开发流程中。 LocalCode绝大部分实现基于Perl,项目代码量在千行级别,便于审阅和扩展。它作为一个Agentic wrapper,封装了一系列工具(tools),这些工具负责完成诸如文件读写、搜索、执行Shell命令、网页检索与解析等具体任务。

每次代理需要执行外部操作时,都会通过这些工具进行,并记录所有行为细节,让使用者可以看到它在背后为达成目标所调用的步骤。透明性是LocalCode的一个核心卖点:当你让它生成或修改代码时,它不仅给出最后产出,还会展示所调用的工具、工具返回的内容、以及它在"思考"过程中做出的决策和后续动作建议。 在安全与权限方面,LocalCode采用了一个简单明了的权限分级机制:把工具分为SAFE(自动允许)、DANGEROUS(需要用户确认)、BLOCKED(永不允许)三类。比如读取文件、基于grep的搜索、网络检索等通常属于SAFE类,而写文件或执行Shell命令被标记为DANGEROUS,需要用户明确授权后才会执行。这样的设计既提升了自动化能力,又在默认设置下避免了不受控的破坏性操作。对于团队或个人用户,这种权限系统既保护了主机安全,也保证了在需要进行危险操作时拥有可追溯的授权记录。

LocalCode提供了丰富的工具列表,开发者可以通过代码或TUI命令查看和使用这些工具。典型注册工具包括read(安全读取文件)、write(写文件并需要授权)、exec(执行命令并需要授权)、search(安全搜索文件内容)、websearch(使用DuckDuckGo进行网页搜索)、webopen(打开并解析网页)、webfind(在网页内容中查找)、bash、grep、edit、list、glob、patch、webfetch、webget、todowrite、todoread、task等。工具注册时附带的标志位(0为SAFE、1为DANGEROUS)决定了调用时是否会触发权限请求。通过工具接口,LocalCode将复杂的外部交互统一成可管理、可追踪的操作序列,便于审计与回放。 使用体验方面,LocalCode既支持交互式命令行模式,也支持直接传入提示或处理文件的批量模式。典型的交互方式是启动localcode进入REPL,你可以输入自然语言指令让代理完成任务。

官方示例展示了它的生成能力:你可以让它"First write calc.pl which can add two numbers by command line, then make it executable, then test it." LocalCode会据此生成calc.pl脚本、设置执行权限并运行测试,然后把每一步的操作日志展示给用户。尽管LocalCode本身是用Perl实现的,但生成的代码并不限于Perl,用户可以让它输出Python、JavaScript、HTML等不同语言或环境的程序,灵活性很高。 LocalCode依赖Ollama作为本地模型引擎,启动时会从Ollama获取可用模型列表并允许用户切换。它支持像gpt-oss:20b这类开源模型,如果本地环境足够强大,也可以运行更大规模的模型如GPT-OSS 120B。通过命令行开关可以直接指定模型,如--set-model "gpt-oss:20b"。此外,LocalCode还提供测试模式,方便验证网页检索等功能的可用性:例如localcode --test-mode "websearch Stuttgart"或localcode --test-mode "webopen https://example.com"等,能在不进入交互模式的情况下对工具能力进行快速检测。

对于安装与运行,LocalCode的依赖多数为在常见Perl环境中容易满足的模块或工具:Perl 5.10以上、Ollama本地服务、Term::ReadLine::Gnu、YAML::Tiny、JSON、LWP::UserAgent、URI::Escape、File::Spec、File::Path,以及系统层面的curl等。对于已经在Unix-like环境中开发的用户来说,安装门槛很低。由于代码量小,审阅和定制也较为方便,特别适合那些希望把AI能力嵌入到本地开发环境并保留最大程度控制权的工程团队。 LocalCode在交互式使用上还内置了若干便捷命令,便于日常操作与会话管理。包括/models列出可用模型、/model <name>切换模型、/current显示当前模型、/permissions查看权限设置、/save和/load用于保存与加载会话、/sessions列出保存的会话、/history显示统一的聊天与命令历史、/version查看版本、/clear清空当前会话、/help获取帮助、/exit退出。通过这些命令,用户可以把一次交互式的开发过程保存为会话,以便复用或审计,从而形成可重复的AI驱动开发流程。

LocalCode的透明性还体现在它记录"思考字段"和后续动作建议上。模型在决定下一步要调用哪个工具、如何修改代码或是否需要更多输入时,会把这些中间状态和理由写入会话日志并展示给用户。这样的可解释性不仅对调试模型决策有帮助,而且能让开发者更容易接受和调整自动化操作。例如在生成复杂功能时,LocalCode可能先提出设计草案,随后询问用户是否接受该草案,再依据用户确认执行代码生成和测试步骤。 从实践角度看,LocalCode可以用于多种场景。快速原型开发是其一:开发者可以用简短自然语言描述功能需求,让代理生成脚手架代码、配置脚本和测试用例,从而快速搭建可运行的原型。

代码重构与补丁生成是其二:通过读取项目文件并使用搜索与patch工具,代理能够提出并应用改动,同时在危险操作前请求确认。教育与示范也是重要应用:LocalCode可以把复杂任务拆解成可理解的步骤并生成注释丰富的示例代码,供学习者研究与修改。 当然,LocalCode并非没有局限。由于其依赖于本地模型的能力,实际表现取决于所使用模型的质量与主机资源。较小的本地模型在理解复杂上下文或生成高质量代码方面可能不及云端大型模型。另一个限制是对高风险操作的策略设计:尽管有权限分级,但权限过度保守可能限制自动化效率,而过于宽松又会带来安全风险,因此需要合理的配置和使用者的谨慎判断。

最后,目前项目仍处于早期成熟阶段,尽管宣称"生产就绪",但在企业级集成、团队权限管理与长期稳定性方面还需要社区推动与持续改进。 在对比其他AI编码代理时,LocalCode的最大竞争力在于本地优先与Perl实现带来的可审计性。相比完全依赖云API的工具,它不会把代码或敏感上下文发送到第三方服务器,对于有合规或隐私需求的机构具有天然优势。相比那些封装复杂、难以理解的中间件,LocalCode的轻量级Perl实现便于开发者直接阅读源码并在必要时进行修改,这对于想要完全掌控AI辅助流程的团队来说非常重要。此外,LocalCode把外部操作抽象为明确定义的工具,结合权限系统与记录机制,为构建可靠的自动化开发工作流提供了坚实基础。 对于想要上手的开发者,建议从以下思路入手:首先在本地环境安装并启动Ollama模型,确保模型可用;其次按照依赖清单准备Perl模块与命令行工具;第三运行localcode进入交互模式,先尝试安全类操作如文件读取与websearch,熟悉工具调用与会话日志;然后在受控环境下尝试DANGEROUS操作,并关注权限提示与回滚策略;最后结合项目需要定制或扩展工具集,利用LocalCode的可编程接口把AI能力嵌入到CI/CD或个人开发流程中。

通过逐步尝试与配置,可以在保证安全的前提下最大化自动化收益。 社区与开源生态对LocalCode的未来发展至关重要。由于项目源代码简洁且大部分用Perl实现,有经验的开发者可以快速参与贡献,例如扩展工具插件、增强权限策略、优化模型适配层或改进多模型支持。文档、示例与模板的积累也会加速其在实战中的应用覆盖范围,尤其是对面向特定语言或框架的代码生成能力进行模板化封装。此外,与其他本地模型引擎或语言适配层的互操作性改进,将使LocalCode更容易嵌入现有开发链路中。 总的来看,LocalCode为本地AI编码代理提供了一条可行路径:以轻量、可审计和可控为核心特性,结合Ollama本地模型实现强大的离线编码能力。

它既是对云端AI工具的有力补充,也是对隐私驱动开发需求的直接回应。对于注重数据主权、需要在本地运行模型的开发者与团队,LocalCode提供了一个可以立刻部署并开始试用的选择。未来随着模型能力提升和社区生态扩展,LocalCode有潜力在自动化编程、代码审查与教育训练等多个领域发挥更大作用,成为本地AI开发工具箱中的重要组成部分。 。