在互联网应用的早期,工作单元通常围绕函数调用、数据库查询或HTTP请求展开,尤其是API的设计和微服务架构的兴起,使得服务之间通过结构化接口和明确的合约进行通信。借助这样的技术基础,网络流量在传输层和应用层被精确路由与管理,确保系统的安全性和可靠性。这一模式支撑了近二十年来软件开发和运维的主流思路。然而,随着人工智能特别是大型语言模型(LLM)的快速发展,应用系统的核心工作单元正在发生根本变化,开始向“提示”转移。传统意义上的API调用逐渐被开放式的语义指令所替代,提示作为自然语言表达的命令,成为AI系统理解用户需求并作出响应的直接载体。提示并非结构化的数据或版本化的接口,它允许用户以自由、多样且灵活的方式,向模型提出生成摘要、撰写代码、制定计划乃至创造图表等复杂任务的请求。

由于多样性和不可预知性,所有类型的请求往往都汇聚至相同的接口端点,譬如通用的/v1/chat/completions,这让传统基于路径或协议语义的路由策略难以发挥效用。由此,开发者和基础设施设计者面临全新挑战:如何准确识别和理解每条提示背后的真实意图?如何基于意图将请求路由至最合适的模型或智能代理?如何保证安全性,防止恶意或绕过限制的请求?更为关键的是,如何在规模化的系统中实施高效管理和监控?这一系列问题促使业界开始提出一种新的网络层级概念——所谓的“第八层”(Layer 8),它不同于传统OSI七层模型的技术定义,而是一种借助语义和意图驱动的抽象层。在第七层,我们通过URL路径、请求头等结构化信息进行应用层路由,而第八层则基于提示中隐含的目标和任务意图做出智能判断和分发。这样,系统能够实现意图推理、模型选择、策略应用以及根据任务层面的需求进行统一的监控与审计。针对开发者而言,这种转变意味着工作流程的彻底变化。传统上,开发者调试API接口,关注的是请求响应状态码和路径设计,而在AI时代,关注点转向理解每条提示的语义内容及其目标任务。

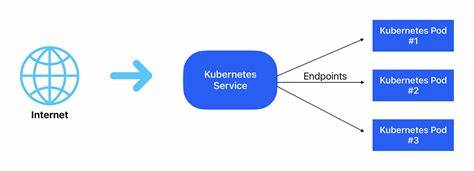

不同类别的提示可能被路由到不同的模型以满足质量、成本、延迟等多维度需求。比如,创意写作类的任务可能优先调用高性能的GPT-4模型,摘要生成则可转至更轻量的Claude模型,而对质量要求较低的任务则可能选择本地模型以节约成本。为实现这些智能调度,基础设施层必须具有意图感知和自然语言理解能力,能够在请求到达边缘时便精准识别提示的类型和目标,动态调整路由策略和资源分配。这不仅有助于提升系统的可靠性和响应效率,也为多模型混合使用和智能代理协作奠定坚实基础。与传统负载均衡器在API扩展中的角色类似,第八层路由器将成为AI应用规模化和性能保障的关键利器。以Arch为代表的新型代理服务器,正借助其深度集成的智能路由和统一观察能力,简化多模型、多代理系统的开发门槛,同时赋能开发者快速上线复杂的智能应用。

展望未来,提示作为新的工作单元,不仅改变了技术架构,也对产品设计、团队协作乃至用户体验产生深远影响。应用开发者必须更加关注提示的设计艺术,既要确保语义清晰,又要避免模棱两可和潜在的安全隐患。同时,平台提供者也需构建开放、透明、高度可观测的环境,让提示的执行过程可追踪、可分析,以不断优化系统性能和防护能力。总之,提示正在引领一场基础设施和开发范式的革命,从面向接口的传统世界迈向以语义和意图为核心的智能新时代。抓住这一趋势,将使开发者和企业在AI浪潮中抢占先机,构建更具创新力和适应性的智能应用,迎接前所未有的数字未来。