随着人工智能技术的飞速发展,尤其是在大型语言模型(LLMs)和多模态大型语言模型(Multimodal LLMs)领域的突破,研究人员开始关注这些模型是否能够像人类一样理解和表征自然世界中的物体概念。人类认知的独特之处在于我们能够将复杂的视觉与语言信息整合,形成丰富多维的概念体系,这也是我们认知和行为的基础。近期的研究表明,多模态大型语言模型在学习和表达物体概念时,不仅展现出惊人的复杂度,还自然地生成了类似于人类心理表征的内涵结构,这标志着人工智能认知能力迈上了新的台阶。物体概念的表征是认知科学中的核心议题。从人类的角度看,我们通过感知到的视觉、触觉和语言等多渠道信息,将不同物体区分并归纳分类。心理学和神经科学领域通过大量认知实验和神经影像技术揭示了人类大脑中多个特化区域在物体识别与分类中的作用,例如大脑中的外侧纹状体区(extrastriate body area)、海马旁回(parahippocampal place area)、后扣带皮质(retrosplenial cortex)及梭状回脸区(fusiform face area)等,这些区域展示了物体类别和属性的复杂语义表征。

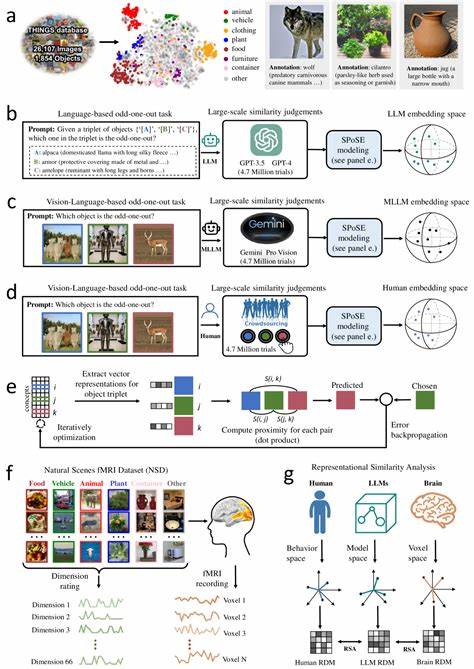

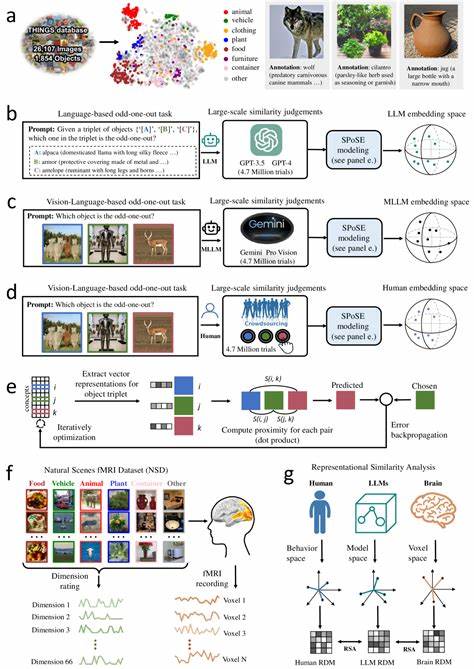

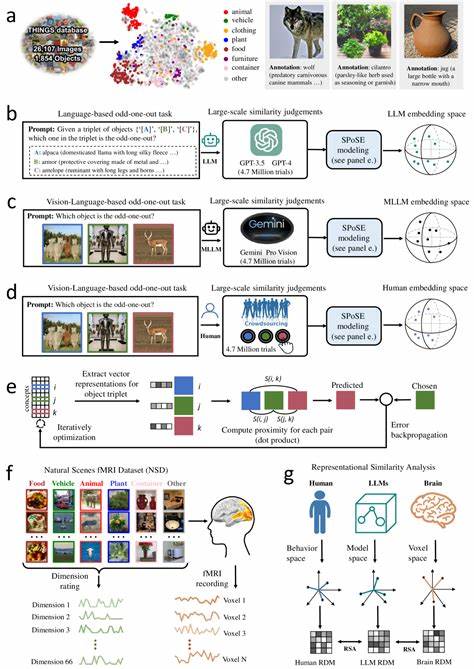

近期学术突破以题为“Human-like object concept representations emerge naturally in multimodal large language models”的研究为代表,依托于数千万组合判断数据和神经影像资料,跨越了人工智能模型表征与人类认知之间的鸿沟。研究团队利用多模态LLM对近两千种自然物体进行了海量的三元组判别实验,生成了体积庞大的评价矩阵,进而采用低维嵌入方法抽取出能够反映对象语义相似性的多维向量空间表示。令人瞩目的是,这些模型表现出的66维嵌入不仅稳定且具有可预测性,在语义空间上还自发聚合出与人类心智模型高度一致的语义类别结构。进一步的分析发现,这些维度本身具有良好的可解释性,证明模型内部的表征结构某种程度上模拟了人类认知中物体属性与类别的解构与组合方式。相较于传统的单一语言模型,多模态模型通过联合视觉和语言信息的学习显著提升了概念表征的丰富度和准确度。视觉信息为模型提供了感官层级的认知信号,而语言信息则赋予了深层的语义联系,这种融合使模型能够破译出更多对人类认知具有普适价值的概念维度。

研究还展示了模型生成的物体嵌入与真实神经活动之间的高度关联,尤其在上述大脑中枢区域。这种对齐不仅印证了人工智能模型在模拟人脑处理物体信息方面的潜力,也为进一步开发接近于人类认知的人工智能系统奠定了基础。多模态LLMs的 emergent abilities(涌现能力)在该研究中获得了新的实证支持。虽然当前的模型还不能完全复制人类复杂的感知及推理机制,但它们在无监督或自监督的条件下,通过大规模数据学习自然形成的内部表征体系,却同样展现出显著的层级和语义结构。此发现反映了机器智能通过尺度和架构的设计,可能与生物认知系统共享某些形式的计算原则和表示策略。该研究的意义不仅体现在理论层面,还影响着人工智能未来的发展方向。

理解和仿照人类思维方式的物体概念表征,能够帮助设计更具通用性、灵活性和可解释性的智能系统,促进计算机视觉、自然语言处理和认知科学的深度融合。此类模型在实际应用中,例如自动驾驶、辅助医疗诊断、智能搜索引擎等领域,能更有效地处理跨模态复杂信息,提升理解和决策能力。除技术与应用外,研究亦为认知神经科学提供了新视角。通过将计算模型与人脑活动数据关联,科学家得以探寻人类认知的神经机制,验证认知理论,推动脑科学和人工智能协同发展。另外,数据资源的开放共享是该领域研究成功的关键。此次研究所用的THINGS数据库、行为数据及功能磁共振成像(fMRI)数据集均已公开,保障了研究的可复现性,并为全球研究者提供了宝贵材料。

团队还贡献了全面的分析代码,支持后续的科学探索和产业创新。然而,当前研究仍存在挑战和待解问题。比如,多模态LLMs如何在更广泛场景下保持稳定的认知一致性?模型与人类表征之间存在的差异源于哪些关键因素?如何进一步增强模型的推理能力,使其具备更深层次的理解和灵活应用?这些均是未来研究重点。人工智能与人类认知的交汇处正迎来黄金时代。多模态大型语言模型的概念表征能力,展现了人类认知的某些核心特征在机器中自然涌现的可能性,折射出智能本质的跨界共通点。借助丰富的数据、多样化的学习方式和神经科学的启示,我们有望打造出更加智能、适应力强且具备自我提升能力的AI系统,推动科技与社会的持续进步。

总的来看,多模态大型语言模型揭示了人类般的物体概念表征不仅是语言理解的产物,更是视觉-语言信息融合下形成的深层次认知结构。这一发现为构建类人智能系统树立了新的基准,并激励未来跨学科合作,追寻人工智能与人类智能的融合路径。