随着人工智能技术的飞速发展,如何有效管理和调用大型语言模型(LLM)成为众多开发者和企业关注的焦点。Model Context Protocol(简称MCP)作为一项标准化协议,为多轮对话和AI模型交互提供了统一接口,简化了复杂系统的搭建。而对于Ruby on Rails开发者而言,mcp_on_ruby库的出现,为传统的Rails REST API注入了新的活力,让构建符合MCP标准的服务器变得更加简单高效。Ruby生态系统一直以来以其优雅简洁著称,而mcp_on_ruby正是对此的完美呼应。它不仅支持多厂商的AI模型接入,如OpenAI和Anthropic,更加全面实现了MCP规范,包含会话管理、消息流处理和文件上传等关键特性。通过该库,开发者能够轻松创建会话上下文,管理对话历史,实时接收模型生成的响应,从而极大提升用户体验和系统响应效率。

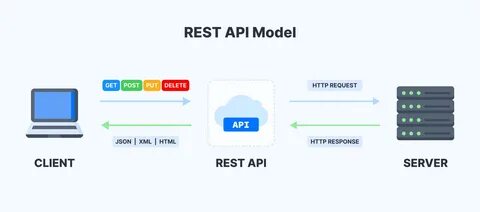

部署mcp_on_ruby非常灵活。它支持多种存储后端,包括内存存储、Redis及ActiveRecord数据库存储。对于使用Rails的应用,ActiveRecord存储尤其友好,因为它可以直接利用已有数据库,且自动创建必要的表和索引,保证数据持久性和访问性能。MCP服务器为API设计了丰富的RESTful端点。这些端点涵盖了从列出可用语言模型(引擎)、创建和管理对话上下文,到添加消息、生成文本回应,再到文件上传和工具调用。这样的设计使得系统各部分职责分明,调用过程清晰且易扩展。

通过这些接口,前端应用或其他服务能够方便地接入后端AI能力,实现多场景对话、数据引用和调用外部功能等复杂交互。在安全性方面,mcp_on_ruby提供了完善的认证机制支持,包括基于JWT的身份验证。开发者可以根据环境灵活配置认证策略,比如生产环境启用认证保障系统安全,而开发和测试环境则可选择简化配置,方便开发调试。此外,mcp_on_ruby支持流式响应输出,这对于构建动态、实时更新的用户界面尤为重要。利用流式API,客户端能够在服务器生成内容的同时即时显示,极大提升用户交互的流畅度和响应速度。对于Rails开发者,集成过程非常直观。

只需要在初始化器中配置相关参数,包括AI服务提供商密钥、存储选项及验证设置,即可启动MCP服务器。再通过路由挂载,便能将MCP服务无缝嵌入现有项目,与业务逻辑自然耦合。这种集成模式不仅提高了开发效率,还降低了维护门槛,适合持续迭代和功能拓展。真实项目中,结合Redis作为存储后端,可以进一步强化数据持久化和分布式访问能力。Redis在高速读写及扩展性方面表现出色,适合大型系统对会话上下文的快速访问需求。同时,mcp_on_ruby的模块化设计允许开发者根据业务特点自定义存储层,实现个性化优化。

面对多样化的AI模型需求,mcp_on_ruby提供了灵活的Provider配置。开发者可根据实际应用切换或同时启用多家API供应商,实现负载均衡或基于场景选择最佳模型。这不仅提升了系统的可靠性,也为进一步引入更多先进模型和算法打开了大门。此外,mcp_on_ruby支持文件上传和工具调用,让对话系统能够超越简单文本交互,利用附件、文档等多媒体资源,或执行特定功能(如天气查询、数据检索等)。这种能力极大丰富了AI应用场景,为用户提供更加智能和个性化的服务体验。从开发测试到生产部署,mcp_on_ruby的完整测试套件保障了系统稳定性和安全性。

开发者可以放心构建高质量的MCP服务器,同时社区活跃,持续推动功能完善和性能提升。在未来的迭代计划中,项目团队还将完善错误处理机制、引入速率限制、防止滥用等功能,更进一步强化服务的健壮性和可用性。综上所述,将Rails REST API转变为基于mcp_on_ruby的Model Context Protocol服务器,是一个顺应AI时代发展趋势的明智选择。它不仅为传统Rails应用带来了强大且标准化的AI对话能力,还通过灵活的存储方案和丰富的特性支持,为构建高效、可扩展和安全的智能应用奠定了坚实基础。未来,无论是构建聊天机器人、智能客服,还是多轮复杂对话系统,mcp_on_ruby都能成为Ruby开发者不可或缺的利器。随着AI技术不断进步,利用MCP标准化接口确保系统的开放性和兼容性,将极大提升应用的生命力和创新潜力。

使用mcp_on_ruby不仅能够快速实现功能,更能有效管理复杂上下文,为用户带来流畅自然的交互体验。对于希望在Ruby环境中深度剖析和掌控AI模型调用的开发者来说,mcp_on_ruby提供了极具吸引力的技术平台和实践范例,值得大力推荐和长期关注。