随着人工智能技术的快速发展,机器学习模型在各行各业中的应用日益广泛。面对日益复杂的模型开发和生产部署需求,MLOps作为连接数据科学与工程实施的关键桥梁,显得尤为重要。AWS SageMaker作为云端领先的机器学习开发平台,其强大的功能和灵活的架构为构建成熟的MLOps体系提供了坚实基础。本文将结合作者多年在实际项目中的经验,深入探讨使用SageMaker实施MLOps所积累的实践经验,涵盖从代码管理、项目模板、自动化流水线、模型注册,到测试及监控等全流程关键环节,供有志于构建高效机器学习运维体系的团队参考。 完善的MLOps流程架构是企业实现机器学习规模化应用的基石。不同组织虽有各自的模型成熟度框架,但经过多方综合分析,成熟的MLOps基本应包括标准化开发环境、项目模板自动集成、持续训练与部署自动流水线、集中模型注册管理、自动测试机制以及全面监控体系。

值得注意的是,自动化模型重新训练和特征仓库功能虽在某些大厂的模型成熟度框架中被提及,但根据作者的实际经验,这两项并非所有企业的默认需求。 本文提出的MLOps解决方案分为基线场景与高级场景两大类。基线场景适用于完成开发、训练及测试后即快速上线的模型,通常用于批处理或内部应用场景。高级场景则引入了生产环境的双端点部署策略,如蓝绿部署、金丝雀发布等,以保障上线模型的质量与安全性。针对不同场景,MLOps设计理念与流程构建略有侧重但互为补充。 在代码管理方面,Git依旧扮演着核心角色。

建议所有机器学习模型代码库采用双主分支策略,即生产分支与开发分支。研发阶段,数据科学家应基于“feature-”前缀创建特性分支,完成功能开发后合并至开发分支,触发开发环境模型更新。产品准备充分后再将开发分支合入生产分支,实现正式上线部署。此策略清晰划分开发和生产代码状态,降低因代码混乱带来的风险。 项目模板的使用能够极大地提升数据科学家的工作效率,减少重复构建流程的时间。SageMaker Projects作为AWS特别提供的功能模块,支持基于多样的项目模板快速启动新模型开发。

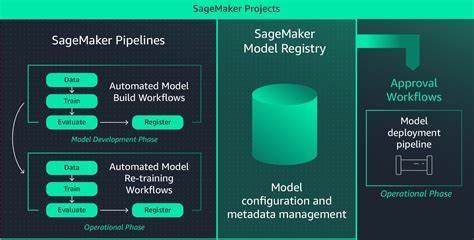

项目创建后会自动配置代码仓库、分支以及模型注册资源,为流水线自动化打下良好基础。对不同场景而言,基础场景需建立对应的模型组(生产、开发、特性),而高级场景则引入冠军与挑战者模型组以实现生产对比测试。利用Lambda函数联合Terraform和CloudFormation,能实现项目生命周期自动化管理,降低运维复杂度。 构建自动化机器学习流水线是MLOps的核心环节之一。基于SageMaker Pipeline,流水线流程涵盖数据准备、模型训练、模型注册及部署触发。数据科学家可在本地或云端执行流水线代码,实现灵活开发与测试。

模型注册后通过审批机制决定是否推向开发环境或生产环境。基于EventBridge事件规则和Lambda函数的自动部署方式提升了响应速度与成本效益。高级场景的双模型生产部署则通过复制模型到冠军和挑战者模型组,分别管理并触发相应端点的发布流程。 值得关注的是,若采用MLflow作为模型跟踪服务器,其受限于AWS管理版本并未开放全部事件监听功能,这导致需构建自定义部署触发机制。推荐结合SageMaker模型注册审批逻辑,或基于MLflow模型别名手动开发事件监听,保证多端点部署的顺畅与自动化。 模型注册中心是MLOps不可或缺的组成部分。

无论是使用SageMaker Model Registry还是MLflow,捕获完整的模型元数据尤为关键。包括训练数据集版本、代码提交ID、超参数配置、模型性能指标等信息,有助于实现模型可追溯、复现及合规管理要求。高效的模型版本管理机制支持模型快速轮换及风险控制。 模型测试环节不仅检查模型预测性能,也评估数据质量。SageMaker Pipelines提供QualityCheck步骤辅助性能检测,但需针对业务需求定制集成与负载测试方案。基于EventBridge事件和Lambda函数,结合DynamoDB存储测试配置,可以实现端点更新后自动触发测试,并通过Slack或其他通知方式实时反馈结果。

此种灵活机制能为上线模型提供多重保障。 监控是保障MLOps体系稳定运行的最后一道防线。SageMaker Model Monitor支持数据分布漂移和模型质量监测,但其依赖地面真实标签,因此在无标签场景下受限。此外,它对非结构化数据的支持不足,且监控周期存在固定时间间隔,无法实现实时告警。针对简单的技术指标监控,如CPU与内存使用率,则可充分利用CloudWatch Endpoint Instance Metrics。综合来看,结合多种监控策略方能满足不断增长的生产需求。

最后,利用AWS SageMaker实施MLOps不仅能规范机器学习模型的开发与生产流程,更能借助云服务的弹性与集成优势,加速企业人工智能应用的落地与迭代。通过合理设计git分支策略、项目模板、流水线自动化与模型注册管理,并辅以针对性测试与监控措施,构建成熟的MLOps体系,企业才能在竞争激烈的AI领域持续保持领先。作者在多次客户项目实践中,深入理解各环节痛点,针对AWS服务变更及时调整设计方案,提供具有现实指导意义的经验总结。期待更多团队能够借鉴分享的思路,推动自身的MLOps建设迈向新高度。