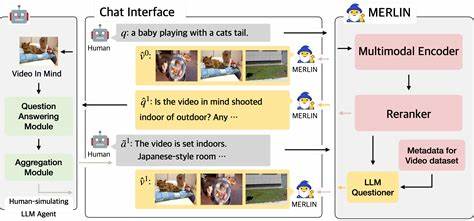

随着人工智能技术的飞速发展,基于文本生成动态图形动画已成为视觉创作领域的热门趋势。大型语言模型(LLM)如GPT-4已展现了强大的自然语言理解和生成能力,但其在生成符合复杂时空约束的动画时仍面临诸多挑战。斯坦福大学Jiaju Ma和Maneesh Agrawala提出的MoVer系统应运而生,解决了基于文本自动生成动画时对于运动属性精准符合的难题。MoVer不仅可以校验运动图形动画的时空属性,还可通过迭代反馈机制不断提升动画的准确性与完整性。传统动画创作过程繁琐且费时,设计师需要借助各种工具手动调整运动方向、时序及相对位置等细节。MoVer通过一种基于一阶逻辑的运动验证领域专用语言(DSL)定义了一系列动画常用的运动属性谓词,系统能够执行这些谓词对给定的SVG格式动画进行检测。

这种形式化验证为动画准确反映文本描述中的复杂语义提供了坚实基础。MoVer的核心创新点在于将验证步骤融入基于大型语言模型的自动动画合成流水线。当系统从文本提示生成初稿动画后,MoVer自动执行对应的验证程序,反馈出不符合属性的部分。随后,这一反馈被输入回LLM,辅助模型理解哪些运动元素需修改,从而进行针对性修正。这种迭代式的合成 - 验证 - 反馈循环使得动画生成过程不断趋近于文本提示的精确描述。为了检验效果,研究团队构建了涵盖5600个文本动画提示及其相应MoVer验证程序的合成数据集。

实验结果显示,使用MoVer带动的迭代流程,仅依赖一次生成时,约有58.8%的文本提示能够对应生成完全符合要求的动画。而经过最多50次迭代优化后,整体动画正确率显著提升至93.6%,极大增强了自动动画生成的实用性与可靠性。MoVer支持检查的运动属性十分丰富,包括单一原子动作(如单个对象的移动方向和距离)、空间相对关系(对象间位置关系稳定性)、时间相对关系(动作次序与时长)以及时空结合的复杂约束。多样性的谓词组合使得系统适配广泛的动画场景及设计需求。在实际使用中,MoVer能够加载任何标准SVG格式的动态图形动画,通过执行其运动验证程序来判定每个运动属性是否被满足。与传统静态动画不同,现代动态图形动画在时间维度上的表现尤为关键,MoVer在针对时序属性上的严谨验证,为动画质量提供了科学保障。

当前支持的几款主流大型语言模型如GPT-4o、Llama 3.3 70B、Gemini 2.0 Flash等,在MoVer验证驱动的迭代中表现不一。比如GPT-4o在首次生成动画时准确率约为58.8%,而更轻量级模型o3-mini则首次准确率高达66%。这表明不同模型在运动理解与生成能力方面存在差异,但经过多轮迭代优化后,大部分模型均能实现超过90%的成功率。这种基于验证反哺生成的训练范式,也为后续开发更高效的视觉内容自动生成技术提供了新思路。MoVer不仅可以纯自动化执行,对于某些复杂动画,结合人机交互实现半自动化调整同样有效。用户可以根据反馈结果手动调整动画,然后再由系统进行再次验证,提升交互设计体验。

这样既保持了自动化效率,又兼顾了设计师的个性化需求。除了技术本身,MoVer也为动画教育与研究提供了丰富的实践素材。5600条动画提示数据集公开后,业界开发者与学术研究者均可利用该基准测试集进行算法评估、模型创新以及交互设计探索。MoVer完美结合了符号逻辑的严谨和深度学习的灵活,使得复杂动画属性的自动验证成为可能。随着大型语言模型与动态图形技术的持续进步,MoVer所代表的融合验证机制有望成为推动视觉动画创作智能化的重要基础设施。未来,MoVer的理念与框架也可推广至影视特效、游戏设计、虚拟现实等多个应用场景,提升内容生成的智能化程度。

总的来说,MoVer为自动动画生成树立了新的标杆,它通过语言逻辑的精确定义和大型语言模型的强大理解力,实现了从文本到高质量动画的闭环迭代优化。随着技术成熟和应用广泛,设计师和内容创作者必将从中受益,打破创作桎梏,释放更多创新潜力。 。