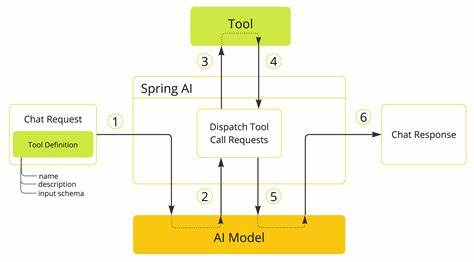

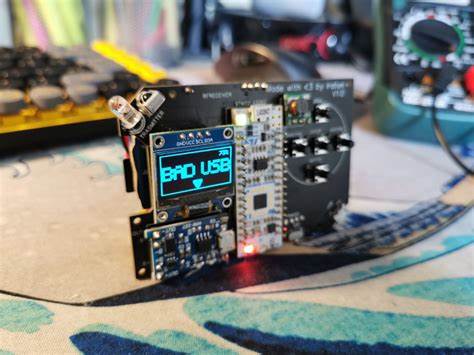

自2024年底以来,基于模型上下文协议(Model Context Protocol,简称MCP)的安全问题频频被推上风口浪尖,研究者们不断发现工具中毒攻击、内容注入漏洞及关键的远程代码执行风险。各类安全新闻头条中,“MCP中的S代表安全”似乎成为了一句调侃的口号,伴随着新兴的安全扫描工具纷纷推出应对方案。然而,真正令人不安的事实是,MCP本身并非安全问题的根源,它不过是旧问题在新舞台上的再现。工具调用的安全危机远早于MCP协议,始于2023年OpenAI推出函数调用API之时,而早期发生的漏洞正是目前MCP问题的雏形。早在ChatGPT插件推出初期,安全隐患便已暴露:OAuth重定向滥用、插件安装绕过等漏洞层出不穷。随着时间推移,诸如通过Markdown图片注入实现对话历史窃取、参数验证不足、缺少执行沙箱等安全缺陷相继被披露。

更重要的是,LLM系统本质上无法区分可信的开发者指令和用户输入,当Google Bard扩展发布后,通过提示注入手法盗取谷歌账户私密数据的问题再次得到验证。学术界对此早有警觉,2023年7月,OWASP在首个大型语言模型应用安全风险榜中将提示注入列为首位风险。现实中,大型语言模型服务的工具调用几乎都成为了这一威胁的活跃目标。MCP的快速普及和开发者友好的架构无疑放大了攻击面,使得潜在漏洞更为显性且影响力更大。细究MCP安全事件,漏洞类型并非新创,而是老问题的新装。工具中毒攻击即通过携带恶意指令的工具描述影响AI行为,类似于2023年2月Kai Greshake深入研究的间接提示注入攻击案例。

再比如广为人知的os.system指令注入漏洞,在MCP中得以通过AI构造的参数被激活,虽然漏洞根源陈旧,却因MCP的新路径而被重新放大。诸多所谓的复杂攻击,如“地毯式抽走”(rug pull)和跨服务器工具影子攻击,本质上仍是传统的供应链攻击与困惑代理攻击的新包装。显而易见,MCP安全的根本难题在于当前LLM架构本身。所有输入在模型端被统一处理,系统提示语、用户指令、工具描述与执行结果混合成同一个令牌流,模型无法区分其安全上下文。传统安全手段难以奏效,比如SQL注入可通过预编译语句防范,但提示注入恰恰利用了语言模型处理自然语言指令的核心机制。正如Simon Willison关于“致命三合一”的分析,任何同时具备私有数据访问、非信任内容暴露与对外通讯能力的系统,都存在不可避免的漏洞。

尽管业界尝试用更多AI技术来防御,其中不乏OpenAI提出的指令层级和谷歌的CaMeL架构等创新,但改进有限且常以性能和功能牺牲为代价。现实是,现有模型架构难以从根本上分辨合法指令与恶意输入,两者的语言形式高度相似。对于开发者来说,这一安全态势尤为令人恐惧。传统软件安全依赖确定性行为,漏洞可复现、易检测,静态代码分析工具可大幅提升防护能力。而MCP所在的AI工具调用安全则具备高度非确定性,同样的漏洞在不同运行条件甚至温度参数变化时成功率差异极大,令复现与修复变得异常复杂。更像是社交工程而非技术攻破,恶意提示利用平实自然的语言塑造诱骗,从而让AI执行本不会执行的操作。

IBM的分析指出,这种攻击利用了AI对自然语言指令的“信任”,对习惯于代码漏洞的开发者来说是个全新而陌生的安全威胁。加之MCP的规模效应,单一恶意服务器即可通过工具影子传播波及多客户端,传统安全边界失效。此外,供应链攻击因MCP标准化及社区广泛采用而能快速放大,典型案例如Trend Micro在Anthropic MCP参考服务器发现的SQL注入,影响数千个下游实现。MCP Inspector的远程代码执行漏洞更是凸显了缺乏认证机制与CSRF防护结合带来的灾难。针对这些挑战,行业虽涌现多款安全扫描工具如MCP-Scan,但多着眼于检测已知攻击模式,无法触及工具调用安全的本质。Anthropic等厂商的多层防御策略也坦言提示注入等漏洞“可能持续存在于前沿AI系统”。

甚至建议用户隔离安全敏感数据使用AI服务,暗示单纯技术手段解决问题的无力。研究界逐渐接受防御无望、假设系统必然被攻破的现实,强调防御深度策略。Simon Willison提倡将此类AI系统视为“天然易受输入操纵”,反映的是现有架构的固有限制。未来应对之道,需要业内正视并接受这一安全悖论,摈弃传统确定性安全思维,构建适合非确定性AI交互的全新安全模型。MCP安全危机其实是AI产业迈向创新安全架构的催化剂,促使研究者和开发者重新评估工具调用的基础安全假设。工具调用安全的不可解局面可能推动更多利用多模型协作分离内容信任度的架构创新,但代价是功能受限与计算负载加重。

最终,只有承认安全问题源于更深层的架构限制,而非单一协议,开发者社区才能调整心态,从“把MCP当作安全洪水猛兽”转向“把MCP视作推动安全创新的试验场”。追求构建真正安全的AI系统之路,必将是长期、复杂且需要跨界合作的挑战。整体而言,MCP及其引发的安全风暴警示着我们,当前大型语言模型工具调用体系的安全问题并非偶然,而是其架构本质造成的遗患。唯有拥抱创新,搭建适配非确定性环境的新安全框架,才能守护未来AI生态的健康与信任。未来的发展方向必然聚焦于隔离信任边界、增强模型对指令来源的辨识能力以及强化多层防御策略。开发者和安全研究者需持续合作,利用检测与响应并重的策略降低风险影响,最终达成兼顾安全性与便利性的平衡。

认识到工具调用中的“S”真正代表的是一种安全挑战,是迈向构建可信AI和安全工具生态的第一步。只有在此基础上,AI行业才能迎来真正的技术突破和安全革新。