受限玻尔兹曼机(Restricted Boltzmann Machines,简称RBM)是深度学习领域的经典模型之一,它通过无监督学习方式捕捉数据的高阶统计特征,在图像处理、语音识别等多个领域发挥着重要作用。传统的受限玻尔兹曼机采用的是二值随机隐藏单元,这种设计虽然简单但存在一定的局限性,尤其在信息表达和传递方面存在瓶颈。随着人工智能技术的飞速发展,研究者们不断探索改进基础模型的方法,以期提升模型的表达能力和泛化性能。整流线性单元(Rectified Linear Units,ReLU)作为近年来神经网络中的重要激活函数,其特点是输出非负且计算简便,解决了传统激活函数饱和和梯度消失的问题。将整流线性单元引入受限玻尔兹曼机,成为了一种有效的改进途径,为该模型注入了新的活力。整流线性单元的基本思想是用一类非线性函数代替传统的二元门限函数,将每一个隐藏单元视为无穷多个具有相同权重但具有递减偏置的单元集合,这种"阶梯状的Sigmoid"结构通过近似实现了ReLU的效果。

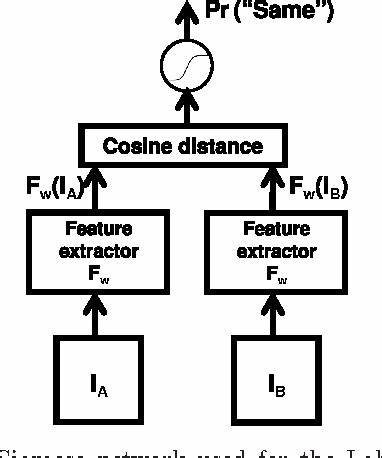

这一设计不仅保持了学习算法的稳定性和简洁性,同时有效增强了模型捕获复杂数据结构的能力。整流线性单元赋予隐藏层单元更强的表达力,使其能够保留输入数据的相对强度信息,避免了信息在多层传播过程中因二值化带来的信息丢失。这种连续而非二元的激活方式极大地丰富了中间特征的表达,提高了特征表示的细节分辨率,从而在多层深度架构中表现优异。在应用层面,采用整流线性单元的受限玻尔兹曼机在多个重要数据集上的表现均有显著提升。例如,在NORB数据集上,改进模型能更有效地提取物体的几何特征和姿态变化信息,提高目标识别的准确率。同时,在公开的人脸识别数据集Labeled Faces in the Wild(LFW)中,整流线性单元帮助模型实现了更稳定和精准的人脸验证表现,显示出其应对复杂图像识别任务的强大潜能。

这种提升不仅体现在准确率的提高,更重要的是使模型具备了更好的泛化能力和鲁棒性。在训练过程中,整流线性单元简化了梯度计算,减轻了传统激活函数带来的梯度消失难题,加速了模型的收敛速度。这对于大规模数据训练和深度体系结构构建尤为重要。整流线性单元与传统的二值隐藏单元相比具备诸多优势。它们能够更细致地区分不同特征的激活强度,支持更复杂的模型表达和推断机制。此外,ReLU的非饱和特性使得梯度在反向传播中更稳定,增强了深层网络的训练效率。

值得关注的是,整流线性单元的引入还使得受限玻尔兹曼机更便于与其他深度学习模型结合,促进多种体系结构的创新。研究者们已经尝试将改良后的受限玻尔兹曼机作为生成模块,构建更深层次的深度置信网络(Deep Belief Networks),实现端到端的复杂数据建模和生成。未来,随着计算资源的持续提升和算法优化,整流线性单元在受限玻尔兹曼机中的作用将进一步得到深化和扩展。其强大的特征表达能力和高效的训练机制为解决复杂视觉、语音以及序列数据等问题提供了坚实基础。预计在自动驾驶、医疗影像分析、智能监控等多个前沿领域,基于ReLU优化的受限玻尔兹曼机将发挥关键作用。与此同时,针对整流线性单元的改进算法也在不断涌现,例如带噪声的ReLU变体、多阶ReLU激活函数等,这些创新将持续丰富受限玻尔兹曼机的表现能力。

整流线性单元的引入不仅提升了模型的性能,也加深了我们对非线性激活函数在深度模型中作用的理解,为深度学习的理论研究奠定了新基础。总之,整流线性单元与受限玻尔兹曼机的结合,代表了深度学习发展史上的一个重要里程碑。它用更具表现力的激活机制突破了传统二元模型的限制,赋予深度结构更强的表达和学习能力。随着相关研究的深入和技术的成熟,该技术势必为人工智能领域带来更多创新应用和突破。在如今大数据和算力高速发展的背景下,探索和应用更高效的模型结构成为推动人工智能进步的关键。整流线性单元在受限玻尔兹曼机中的成功运用,为网络架构设计和优化提供了宝贵经验,推动了深度学习技术走向更加智能和高效的未来。

。