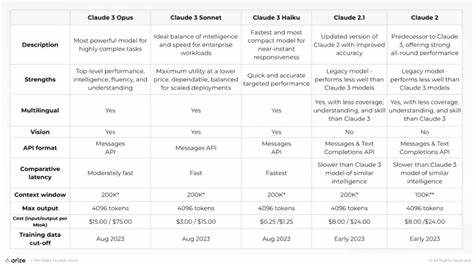

随着人工智能技术的快速发展,语言模型在自然语言处理领域的应用日益广泛,成为推动行业变革的重要力量。在众多AI模型中,Anthropic公司推出的Claude模型因其强大的性能和创新设计备受关注。然而,近期Anthropic公开承认其在八月份对Claude模型进行了"nerf" - - 即有意降低了模型某些能力的调整,此举在业界引发了广泛的讨论和深刻的思考。首先需要明确的是,所谓"nerf"在AI领域并非完全贬义,它通常意味着对模型进行一些限制或调整,目的在于优化模型的表现或确保其输出安全与合规。根据Anthropic公司的说法,此次对Claude模型的调整主要是为了减少潜在的风险,比如模型生成不当内容的概率,或者限制模型在特定敏感领域中的表现,防止误导或产生负面影响。尽管如此,用户和AI社区对这一变化反应不一。

一部分用户认为调整后Claude模型在某些任务上的表现有所下降,交互体验不如之前流畅和丰富;而另一部分用户则赞赏这一步伐,认为这体现了Anthropic在AI安全伦理上的责任感,能够更好地控制AI输出质量,避免不良信息的传播。背后驱动力是当今社会对于AI技术的监管与伦理要求日益增强,尤其是在内容生成方面,诸如涉及政治敏感、暴力、色情等话题,技术公司需要承担更重的责任,确保人工智能的使用不会带来负面社会影响。与此同时,模型调整带来的技术挑战不容忽视。降低模型的轻率输出能力,意味着算法在理解、推理的复杂度上需要更加精准和平衡。Anthropic在此次调整中,显然是在试图寻求用户体验与安全规范之间的最佳折中点。值得关注的是,此次Claude模型的调整反映了整个AI产业链面临的共同难题 - - 如何在追求更强模型能力与保障用户安全之间取得平衡。

此前,很多大型语言模型因生成有害内容遭到质疑和监管压力,促使开发者不得不在性能优化和风险控制之间进行革新和调整。Anthropic公司作为行业领先者,其决策也将在一定程度上为其他AI技术企业树立风向标,影响未来模型设计和发布策略。此外,这一事件凸显出公众对AI透明度和可控性的期待。用户不仅关注语言模型的功能强弱,更加关心其背后的安全机制和伦理考虑。Anthropic选择公开承认调整行为,本身是一种积极的态度,有助于增强用户信任,推动AI生态环境的健康发展。从长远看,人工智能技术的演进必将呈现持续调整与完善的过程。

如何设计出既强大又安全的AI系统,是所有从业者的共同课题。此次Claude模型的调整,作为一次试验与反思,或将为未来AI模型的迭代提供宝贵经验。同时,业界需要继续探索更先进的技术手段,比如强化学习与人类反馈结合、多模态数据融合等,提升模型的智能水平和责任感。社会各界也应加强对AI伦理框架和相关法律法规的建设,确保技术发展在可控范围内释放积极效应。综上所述,Anthropic承认在八月对Claude模型进行 nerf的行为,既显现了人工智能技术发展过程中的矛盾与挑战,也体现了企业在技术规范和社会责任上的不断探索。这一调整不仅是技术层面的优化,更是行业自我约束和透明度提升的重要信号。

未来,人工智能领域无疑将继续经历此类调整和革新,推动智能技术向更加安全、可靠和人性化的方向迈进。对于关注人工智能发展动态的用户、开发者和相关机构而言,深入理解此次事件背后的多维影响,能够更好地把握AI未来发展的脉搏,助力构建良性、可持续的AI生态系统。 。