随着大数据时代的到来,海量数据的存储与分析成为各行各业的核心需求。Apache Spark作为一个成熟且高效的分布式计算框架,已经被广泛应用于大数据处理场景,其强大的扩展性和丰富的生态系统使其成为大数据分析的首选工具之一。然而,尽管Spark自身不断迭代优化,Spark SQL部分仍面临性能瓶颈,尤其是在执行计算密集型任务时,性能提升空间有限。针对这一难题,Apache Gluten应运而生,致力于通过原生代码加速,引入高效的本地执行引擎,极大提升Spark SQL的性能表现。Apache Gluten项目的核心理念是"胶水"(Gluten在拉丁语中的含义),即作为连接本地高性能库与Spark SQL的中间层。它保留了Spark SQL的分布式控制流和查询优化能力,同时将计算密集型的数据处理任务交由原生代码完成,使得Spark既拥有高度的扩展能力,也享受到本地代码的卓越性能。

这种架构理念既避免了对Spark原有代码的剧烈改动,也极大地提升了数据处理速度,助力用户在不改变现有数据接口的情况下获得性能跃升。Apache Gluten的架构基于Substrait规范,Substrait定义了一套跨语言、跨平台的数据计算操作规范,能够将Spark的执行计划转换为标准化的Substrait计划。随后,通过JNI接口,Substrait计划被传递给支持的本地引擎,如Velox和ClickHouse,由这些经过高度优化的C++库进行实际的运算处理。Apache Gluten采用Apache Arrow作为基础的数据格式,方便高效地在JVM和本地环境之间传递列式数据,减少数据转换带来的开销。用户在使用时,无需更改任何SQL语句或DataFrame API,只需简单配置即可切换到Gluten加速环境,极大降低了集成门槛。当前,Apache Gluten支持多种后端,其中Velox是由Facebook开源的高性能数据处理库,提供了灵活且可扩展的内存管理和算子执行功能。

ClickHouse作为一个高效的列式数据库引擎,擅长分析型查询,Gluten集成ClickHouse后端,使得Spark能够借助其高效的查询执行能力,为用户带来巨大性能提升。Apache Gluten的关键组件涵盖了查询计划转换、统一内存管理、列式数据Shuffle机制、回退机制和多版本适配层。查询计划转换是实现JVM物理执行计划到Substrait计划无缝转换的关键,确保能够精准表达计算逻辑。统一内存管理则保证了本地内存的高效分配和释放,避免内存泄露和碎片。列式Shuffle解决了分布式执行中数据传输和重排的瓶颈问题,确保数据流动的高效和稳定。另外,回退机制保证了当某些算子本地不支持时,能够顺利切换回Spark原生执行,确保系统的健壮性和兼容性。

同时,Apache Gluten积极适配Spark的多个主流版本,力求让更多用户能够方便使用最新功能。为了方便用户快速体验性能优势,Apache Gluten提供了预编译的JAR包,支持常见的操作系统环境如CentOS和Ubuntu,满足大部分用户的基本需求。对于追求极致性能的用户,可以自行编译源码,针对自身硬件环境和Spark版本进行定制优化。开源社区中,Apache Gluten由Intel和Kyligence等多家公司联合发起,并得到了阿里巴巴云、美团、百度、微软等企业的积极参与与贡献,社区活跃度高,技术支持及文档不断完善。性能测试方面,Apache Gluten结合Velox后端,在单节点3TB数据的TPCH-like和TPCDS-like基准测试中,整体性能提升超过3倍,部分查询甚至实现20倍以上的加速效果。而使用ClickHouse后端的8节点集群环境下,数据量达1TB时,平均加速比超过2倍,显著缩短了复杂分析任务的执行时间。

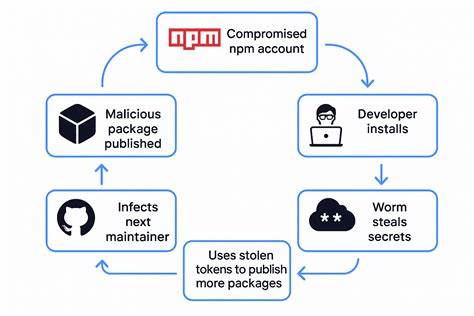

性能提升的背后,是底层采用本地高效的列式存储格式、多线程并行计算以及先进的优化组件,如向量化执行和缓存机制,使得计算资源得到了极致利用。此外,Apache Gluten也非常注重安全性,倡导及时报告漏洞,保障软件安全,并提供完善的社区支持渠道。未来,Apache Gluten计划继续扩展更多后端支持,提升对Spark更多版本的兼容性,同时优化内存管理与算子执行效率,进一步降低用户门槛,推动大数据分析的高性能发展。总结而言,Apache Gluten作为Spark SQL加速的重要创新,成功将本地高性能计算能力与Spark的分布式调度优势相结合,为大数据处理带来全新的速度革命。它不仅提升了分析任务的执行效率,也为企业节省了计算资源和时间成本,助力业务决策更加迅速精准。随着生态的不断完善和用户规模的扩大,Apache Gluten无疑将在大数据技术领域发挥越来越重要的推动作用。

未来,随着更多客户和社区成员的参与,Apache Gluten将持续释放性能潜力,成为Spark SQL性能优化的标杆解决方案,带动整个数据分析产业迈向新的高度。 。