近年来,人工智能尤其是大型语言模型(LLMs)在多个领域的崛起引起了广泛关注,其在医学、法律甚至艺术创作中的表现令人瞩目。在化学科学领域,这些模型也逐步展现出巨大的潜力,尤其是在化学知识的掌握与复杂问题的推理能力方面。本文将围绕大型语言模型与人类化学专家在化学知识与推理能力上的比较展开深入探讨,阐释当前技术的发展现状、优缺点以及未来发展方向。 大型语言模型是一类基于机器学习的人工智能系统,通常通过海量文本数据进行训练,具备理解和生成自然语言文本的能力。随着模型参数规模的不断扩大及训练方法的改进,它们不仅可以回答简单的问题,还能够处理更加复杂和专业化的任务,包括化学领域的多样化问题。像GPT-4、Claude-3.5以及其他新兴模型,已经在化学相关测验及实际任务中展现出不逊色于人类专家的表现。

一项名为ChemBench的综合评测框架,专为系统性评估大型语言模型在化学知识与推理能力上的表现而设计。ChemBench收录了超过2700个精心设计的问题,涵盖通用化学、有机化学、无机化学、分析化学、物理化学、化学安全与毒理学等多个子领域,问题类型包括多项选择和开放性问答,综合考察模型的知识储备、计算能力、逻辑推理以及化学直觉。通过与专家组对比测试,科研人员发现某些先进的语言模型在整体表现上已超越大部分参测的化学专家,这引起了学界及产业界的高度关注。 这些结果背后反映出三个重要趋势。首先,顶尖大型语言模型已经积累了大量结构化与非结构化化学数据内涵,能够快速识别并利用相关信息,完成许多曾被认为需要专业经验的问题。其次,模型的规模和训练数据的广泛性是提升化学知识与推理能力的关键因素,较大的模型普遍表现更为优异,但是依然存在“知识死角”,尤其是涉及高度专业化或欠缺公开数据支撑的领域。

最后,虽然模型在答题速度和覆盖范围上具备优势,但它们在部分基础问题及安全相关题目的表现不稳定,存在过度自信或错误推断的情况,提示了当前模型在逻辑推理和事实准确性方面仍有待完善。 此外,深入分析表明,语言模型对化学结构的空间和电子性质推理能力仍有限。例如,预测核磁共振(NMR)信号数量等需要综合空间对称性和分子拓扑的任务,模型准确率相对较低。而人类专家凭借绘图和直观理解往往表现更好。模型多依赖于与训练数据近似的分子结构信息,而非真正意义上的基于物理和化学原理的推理,这种“表面学习”限制了其在创新性和未知领域的表现。 在人机交互方面,目前大多数大型语言模型无法准确评估自身回答的可信度,往往会以较高自信给出错误答案。

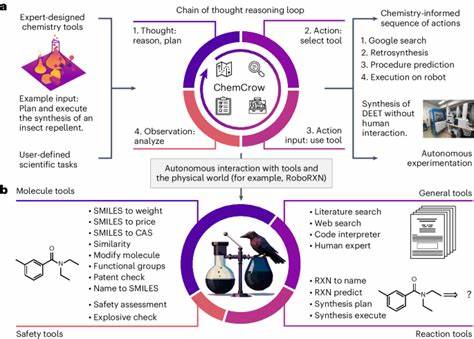

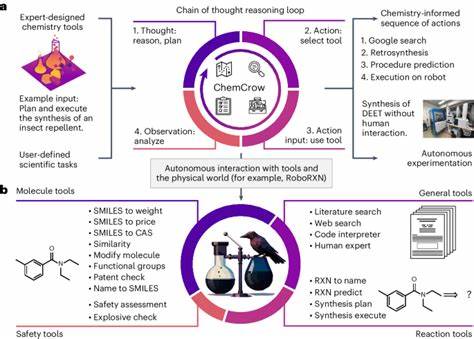

这一缺陷对真正的科研合作与日常应用带来潜在风险,尤其在处理化学安全、毒理等高风险领域时,任何误导都可能产生严重后果。由此,开发更可靠的置信度估计机制,以及将模型与专门数据库和物理模拟工具结合使用,成为当前研究的热点方向。 在实际应用中,结合语言模型与外部工具(如文献检索系统、结构绘图软件和化学数据库)可以显著提升解题质量和实用性。以PaperQA2为例,这类工具能够自动检索并整合最新文献数据,辅助模型产生更准确和权威的回答。未来,多模态AI系统将可能实现图文结合、实验数据输入与生成相结合的全方位辅助,推动化学研究更加智能、高效。 从教育视角来看,随着大型语言模型不断强大,传统的以记忆为主、题海战术的化学教学模式或将被重新审视。

模型在重复记忆和标准问题上的超越,强调了培养学生批判性思维和问题分析能力的重要性。未来,化学课程可能需要更多地聚焦于复杂推理、创新设计和实际操作技能的培养,重新定义人类专家的核心竞争力。 除了技术层面,安全伦理问题也日益重要。化学知识具有潜在的双用性质,模型若被用于设计危险化学物质或武器,可能带来极大风险。如何合理监管模型训练数据、限制敏感内容的生成,以及建立责任使用机制,是未来人工智能和化学界共同面临的课题。 总结而言,大型语言模型正在以惊人的速度提升其化学知识和推理能力,部分模型已在通用化学测试中超越大多数人类专家。

然而,现阶段它们仍然存在基础知识应用不足、推理深度不够以及自信度估计不准确等局限。人机协同、工具增强、专业数据库集成以及完善的评估框架将成为推动该领域进步的关键。此外,对教育体系和伦理监管的适应也是确保技术惠及化学研发和社会安全的基础。 未来,随着更多跨学科合作和技术创新的推进,预计大型语言模型将成为化学家不可或缺的助手,辅助他们快速获取知识、设计实验、优化过程并推动科学发现,开启人工智能和化学融合发展的新纪元。