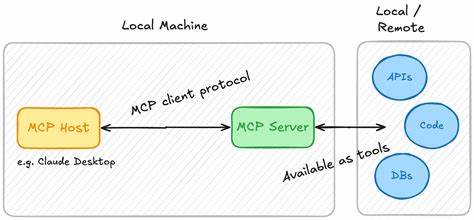

近年来,随着人工智能技术的快速发展,特别是大型语言模型(LLM)的广泛应用,运行和执行代码已成为提升智能系统实用性和交互能力的重要环节。在这一背景下,Piston-mcp应运而生,作为一种高效且灵活的MCP服务器,它为LLM提供了连接与执行代码的桥梁,极大地丰富了模型功能,推动着智能应用进入新的发展阶段。 Piston-mcp的核心优势首先体现在其与Piston的深度集成上。Piston本身作为一个跨语言的代码执行平台,支持多种编程语言环境,让用户能够在统一平台上进行灵活的代码管理和执行。借助Piston-mcp,开发者和研究人员可以轻松实现LLM与Piston服务器的无缝交互,从而远程运行代码片段。这种架构不仅提高了代码执行的效率,还保障了执行过程的安全性和稳定性,减少了由于环境差异带来的潜在问题。

安装和部署方面,Piston-mcp也展现出极强的易用性。通过简洁的命令行工具UV,用户可以快速完成环境搭建,无需繁复配置。UV以其跨平台特性,为不同操作系统提供了高效支持,进一步降低了使用门槛。其安装过程无论是在MacOS、Linux还是Windows环境下,都表现出极大的便利性,无疑为开发人员节省了大量时间和精力。 在连接客户端方面,Piston-mcp同样注重用户体验。以Claude Desktop为代表的MCP客户端通过简单配置即可接入Piston-mcp服务,实现代码的远程执行。

通过json格式的配置文件,用户能够灵活定义服务器指令及参数,适配自身需求。这种开放且模块化的设计理念,使得Piston-mcp不仅适合个人开发者使用,也具备良好的企业级集成潜力,有助于推动大型团队在多样化项目中的协同开发与测试。 安全性是代码执行平台必须重视的问题。Piston-mcp通过隔离执行环境和权限控制机制,最大程度降低了潜在的风险。它能有效避免代码执行过程中对主机系统的影响,保障服务器及用户数据的安全稳定。同时,运行日志和异常监测功能也为系统运维和故障排查提供了有力支持,确保服务的高可用性和持续优化。

从技术栈角度来说,Piston-mcp使用Python作为开发语言,借助Python简洁且强大的生态环境,开发效率高且易于扩展。整个项目结构清晰,包含了源码文件、配置文件以及相关文档,方便开发者进行二次开发和定制化调整。社区维护力度也较为稳健,不断引入新的特性和改进,以满足快速迭代的需求。 作为一个专门为LLM运行代码需求打造的MCP服务器,Piston-mcp实现了语言模型与代码执行环境的有效桥接。通过其支持的多种语言及灵活的调用接口,LLM能够根据上下文动态生成代码指令,并实时执行,极大提升了交互的智能化水平和应用的场景丰富度。例如,在自动化编程助手、智能问答系统、数据分析和科学计算领域,Piston-mcp都能发挥独特优势,助力模型输出更准确实用的程序解决方案。

此外,Piston-mcp的开源性质促进了社区的积极参与。开源使得程序模块透明,方便用户自主审阅代码安全及性能,同时也激发了创新与合作。开发者们能够基于Piston-mcp构建自定义扩展,满足更高阶的业务需求。相比传统封闭平台,开放生态下的Piston-mcp更具活力和发展潜力,推动人工智能与软件工程的深度融合。 展望未来,随着相关技术的不断成熟,Piston-mcp有望在更多领域得到广泛应用。无论是智能助理的代码调用,还是复杂系统的远程管理,都能因其高效稳定的架构获益。

同时,结合云计算和容器化技术,Piston-mcp的部署将更加灵活便捷,适应分布式计算环境的需要。更智能的自动调度策略及错误恢复机制,也将提升整体用户体验和系统健壮性。 总结来看,Piston-mcp作为一款专注于大型语言模型远程代码执行的MCP服务器,凭借其强大的功能、易用的安装流程、安全稳健的执行环境,以及开放的社区生态,正逐步成为AI开发领域不可或缺的基础设施。它不仅满足了当前多样化的代码执行需求,更为未来智能软件应用的发展奠定了坚实基础。随着技术进步与应用场景扩展,Piston-mcp必将持续引领代码执行服务的新潮流,赋能更智能、更高效的人工智能时代。