生成式人工智能近年来迅速发展,广泛应用于文本生成、对话系统、内容创作等各个领域。然而,随着其影响力的提升,安全风险也日益显现,尤其是针对恶意提示攻击的安全问题。恶意提示攻击指攻击者通过设计特殊输入,诱使AI模型执行未授权操作或泄露敏感信息,给应用带来严重隐患。 面对这种挑战,如何有效保护GenAI应用成为业内关注的焦点。首先,了解恶意提示的工作原理和攻击形式有助于制定针对性的防御策略。恶意提示攻击往往利用了语言模型对上下文的高度依赖性,攻击者通过嵌入看似正常却隐藏恶意指令的输入,诱导模型产生潜在有害的响应或行为,进而侵犯数据隐私、扭曲内容输出,甚至导致系统崩溃。

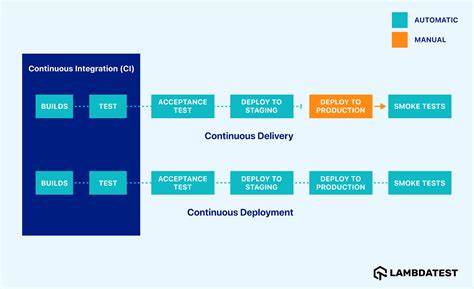

在实际应用中,传统的安全防护措施难以完全覆盖生成式AI的特殊风险。相比于传统软件漏洞,恶意提示更多地体现为语义层面的风险,攻击内容隐蔽且多样,使检测变得尤为复杂和高成本。因此,创新的安全框架和工具应运而生,以应对高度动态和多样化的威胁环境。 一种值得关注的做法是构建多层次的检测机制。通过结合规则引擎与机器学习模型,实现对输入提示的多维度分析,能够更精准地识别潜在的恶意内容。规则引擎能够快速匹配已知攻击特征,保障实时响应能力;机器学习模型则通过学习海量正常与异常提示的差异,提升对未知攻击的发现率。

这种组合策略既保证了效率又提升了安全覆盖面。 此外,向开源社区开放安全检测框架,借助集体智慧推动技术演进,是提升生成式AI安全的重要渠道。开源项目如AIDR-Bastion正是针对恶意提示攻击设计的框架,集成了规则检测、机器学习分类、向量相似度分析等多种手段,支持基于规则的允许、阻断或通知操作,灵活适配不同场景需求。通过社区的不断贡献和迭代,有望逐步完善检测规则库和检测算法,增强系统整体防护能力。 在实际部署过程中,安全团队应结合应用特点,制定细化的策略。对关键业务场景实行强化审查,例如对生成敏感信息的接口增加实时监控,对模型交互环节注入安全校验,避免潜在恶意输入激活危险功能。

同时,应建立完善的日志记录和异常告警系统,确保任何异常行为能得到快速响应和处理,防止风险扩散。 此外,加强模型自身的鲁棒性设计从根源减少安全隐患亦十分重要。通过训练时引入安全约束,提升模型对异常环境的稳定性;利用对抗训练提高模型抵御精心伪装恶意提示的能力;定期更新和优化模型以修补潜在漏洞,形成动态防御体系。 与此同时,结合行业标准和安全框架规范,也能为GenAI安全建设提供指导。例如,将MITRE ATLAS等攻击矩阵纳入风险评估体系,通过系统化的方法识别潜在威胁路径和防护点;依托OWASP LLM Top 10等最佳实践,合理规划防御优先级和策略执行,提升整体安全成熟度。 从企业管理层面看,培养跨部门协作的安全文化同样关键。

安全不仅仅是技术问题,更涉及到治理、合规与意识提升。定期开展安全培训和模拟演练,提升开发者和运维人员对恶意提示风险的认识和应对能力;建立多元化沟通渠道,确保技术安全措施与业务需求紧密结合,实现安全风险的全方位管理。 技术创新的同时,保持对安全态势的持续关注尤为重要。随着攻击手法不断演变,及时掌握最新威胁情报,动态调整防御策略,是保障生成式AI长期安全运行的根基。可借助大数据与人工智能技术,构建智能安全监控平台,实现自动化风险识别与响应,减轻人工压力,提高整体安全效能。 展望未来,生成式人工智能应用的安全挑战将愈加多样复杂,但也推动相关技术和标准不断成熟。

通过多层次协同防御、多渠道社区共建以及先进算法研发,构建起坚实的安全防线指日可待。每一位开发者与安全专家都有责任共同探索更安全、可信赖的智能应用生态,推动生成式AI健康可持续发展。 总而言之,保护生成式人工智能应用免受恶意提示攻击是一项系统工程,涵盖技术、管理与规范多方面。结合多元检测机制、开源框架合作、模型鲁棒性提升以及行业安全标准,构建全面防护体系,是实现安全可信GenAI应用的关键途径。随着技术进步与安全意识普及,未来我们有望迎来更安全、更智能的生成式人工智能新时代。 。